5月20日,由深度学习技术及应用国家工程实验室与百度联合主办WAVE SUMMIT2021深度学习开发者峰会在北京盛大举行。百度首次揭晓人工智能融合创新趋势下的AI工业大生产实现路径,飞桨深度学习平台带来全新发布,持续引领深度学习技术发展。

峰会上,百度深度学习技术平台部高级总监马艳军就飞桨全新发布与升级展开演讲。他表示,年初飞桨正式发布了开源框架2.0版本,是飞桨发展历程中的重要里程碑。2.0版本默认的编程范式由静态图升级为动态图,而且实现了动静统一的设计,很好地兼顾了科研和产业的需求。目前,飞桨深度学习开源平台从基础模型库、端到端开发套件到工具组件,都基于框架2.0版本进行了升级,开发体验得到了全面提升。2.0版本的大规模训练能力持续突破,参数服务器技术迭代到第三代,是业内首个通用异构参数服务器架构。最近又发布了4D混合并行技术,支持超大模型训练。

此次峰会飞桨框架又迎来了重磅发布,展示最新的技术成果和开源生态成就,其关注程度可想而知。接下来,我们来逐一揭秘飞桨开源深度学习平台从开发、训练、部署全链路的最新成果。

飞桨开源框架V2.1,技术底座呈破圈之势

基础设施一小步,AI上线一大步。

峰会上,飞桨开源框架正式发布V2.1版本,自动混合精度、动态图、高层API等进行了优化和增强。尤其是自定义算子功能全面升级,降低开发者自定义算子的学习与开发成本。“自定义OP功能优化”等升级带来极强的科研开发灵活性和扩展能力,产业应用已从成熟的AI行业延伸到生物、物理、化学等大科学跨界领域的开发集成,助力前沿基础科学研究。

封装更简洁、训练和推理全打通、一键编译、安装并生成算子API,有效降低了开发者编写和使用自定义算子的成本,让开发者更加专注于算子计算的本质。深度势能的分子动力学开源项目(DeePMD-kit)就是一个典型的案例。DeePMD-kit发布以来,在凝聚态物理、化学物理、材料理性设计、生物物理、药物分子设计等领域均得到广泛应用。DeePMD-kit的社区开发者使用飞桨框架的自定义OP功能可以方便地进行计算单元的自定义,加速功能开发。

开发上便捷灵活、应用上普适多元。飞桨正在一步步创造领先同行的深度学习开源能力,产业渗透已呈“破圈”之势。

大规模图检索引擎,特殊场景的“启动密码”

随着大规模图学习在知识图谱和搜索推荐领域的广泛应用,大规模图模型训练愈加受到重视,已经成为诸多特殊场景的“启动密码”。

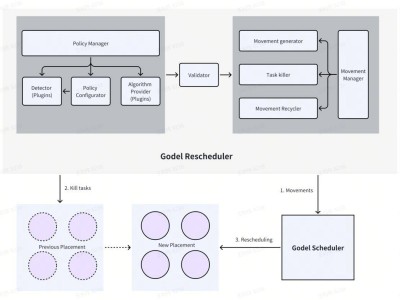

飞桨提供了从分布式数据处理、图检索、前向反向图模型计算、多server参数更新的全流程通用分布式能力,形成了大规模图模型训练架构。对于其中图检索环节,此次发布的图检索引擎,可以高效支持万亿边的图存储和检索,将图的邻接表通过双层哈希切分方式存放到不同graphserver上。worker端请求graphserver通过图检索引擎获得子图进行训练。最后在Intel CPU环境上实测,可以支持万亿边图模型训练,也很好地支持线性扩展。

这一技术在网易云音乐主播推荐业务进行了应用。基于大规模图检索引擎和飞桨分布式训练技术,成功支撑语音主播业务十亿边的图模型训练,通过知识迁移有效解决冷启动问题,提高主播推荐场景有效播放率。

ERNIE四大预训练模型,开源家族又添生力军

模型套件方面,文心ERNIE全新开源发布 4大预训练模型,分别是多粒度语言知识增强模型ERNIE-Gram、超长文本理解模型ERNIE-Doc、融合场景图知识的跨模态理解模型ERNIE-ViL和语言与视觉一体的模型ERNIE-UNIMO。知识与深度学习相结合实现知识增强的语义理解,不仅仅能理解语言,还可以理解图像,实现统一的跨模态语义理解。

ERNIE-Gram提出显式的n-gram掩码语言模型,通过引入多粒度语言知识增强预训练模型效果,5项典型中文文本任务效果显著超越业界开源的预训练模型。

ERNIE-Doc针对篇章长文本建模不充分问题,提出回顾式建模技术和增强记忆模型机制,在13 项长文本理解任务上取得领先效果。

ERNIE-ViL针对跨模态理解难题,基于知识增强思想,实现了融合场景知识的跨模态预训练,在5项跨模态理解任务上取得效果领先。

ERNIE-UNIMO进一步增强不同模态间的知识融合,通过跨模态对比学习,同时提升跨模态语义理解与生成、文本理解与生成的效果,在13项跨模态和文本任务上实现领先。

推理部署导航图,打通AI应用最后一公里

在产业数字化背景下,AI建设从互联网市场向千行百业迈进,落地成为必然要求。AI能否顺利推理部署,已经成为落地成败的关键。飞桨提供全流程的深度学习开发工具。针对不同的软硬件部署环境,飞桨都提供了完善的推理部署工具,并打通了完整的工具链。

峰会现场,飞桨多端多平台推理部署工具链发布全面升级。飞桨模型压缩工具PaddleSlim模型压缩升级,优化剪枝压缩技术,新增非结构化稀疏工具,拥有软硬一体协同优化的能力,结合多种压缩策略优势,率先支持 OFA 压缩模式,面向不同部署环境实现高精度压缩。飞桨的轻量化推理引擎Paddle Lite也进行了全面升级,兼具稳定易用、性能优异、多硬件支持诸多特性。针对服务化部署的实际需求,Paddle Serving 新增全异步设计的 Pipeline 模式,可以一个服务启动10+模型,打破串行设计的约束,提升吞吐量和 GPU 利用率。飞桨的前端推理引擎Paddle.js 新升级后保持高兼容性,完整支持了飞桨框架2.0及之后版本的模型格式,新增支持多种 Backend和主流图像分割及分类模型,在高兼容性的同时兼顾了高性能。另外,Paddle.JS还推出了前端模型加密解决方案,有效提高业务的安全性。

推理部署工具链各个工具正加速升级,而整个链条是否通畅也非常重要,这一定程度上决定了AI应用最后一公里的路能否走顺。峰会现场,一张飞桨推理部署导航图成功吸睛,300多条部署通路一目了然,深刻诠释了飞桨在打通AI应用最后一公里所做出的不懈努力。

硬件生态新成果,AI工业大生产“朋友圈”再扩容

AI基础软硬件生态构建意义非凡,芯片与深度学习框架的融合成为构建全球领先的AI 应用与推广生态的关键。

飞桨的枝繁叶茂也离不开广大硬件生态伙伴的支持。硬件生态方面,从去年WAVE SUMMIT2020峰会发布硬件生态伙伴圈到今天的一年时间里,飞桨已经和包括百度昆仑、英特尔在内的22家国内外硬件厂商开展适配和联合优化,已完成和正在适配的芯片或IP达到了31款。

飞桨正与合作伙伴们携手,加快软硬一体适配,提供功能强大、高效、可扩展和高性能的解决方案,助力实现AI创新,推动AI工业大生产的实现进程。峰会现场,英特尔、英伟达、海光、华为昇腾、瑞芯微多家合作伙伴进行了企业硬件生态成果展示,飞桨生态的硬件朋友圈再次扩容。

螺旋桨、量桨最新升级

当天除了全新发布,还见证了螺旋桨、量桨的最新升级。

螺旋桨 (PaddleHelix)升级到了1.0正式版本,新增了化合物预训练模型ChemRL,并将ChemRL模型应用到更多的下游任务。在今年3月,国际权威的图神经网络OGB 上,在HIV和PCBA两个药物相关的数据集上,获得双冠军。

量桨( Paddle Quantum)适配飞桨框架2.X,整体运行大幅度提升;量桨的整体功能也得到了进一步加强,适配了近期量子设备,新增量子核方法等特征提取方式等。对于难度很大的纠缠提纯任务,量桨新增了最优化量子纠缠处理框架,给出了目前业界最优且可实施的提纯方案,多个场景达到业界最优。

AI大生产阶段,作为百度大脑“AI大生产平台”的基础底座,飞桨始终保持着高频更新迭代,是“技术使能者”也是“价值赋能者”。IDC数据显示,飞桨是全球排名前三的深度学习框架。目前,飞桨平台已经凝聚了320万开发者,相比一年前增幅70%,服务12万家企事业单位。飞桨“AI赋能万物”的磅礴力量再次凸显,也用行动践行着百度“用科技让复杂的世界更简单”的使命。