关键词:深度学习;高性能计算;数据分析;数据挖掘;LLM;PPO;NLP;ChatGPT;人工智能;高性能服务器;HPC;AIGC

随着人工智能、深度学习、高性能计算、数据分析、数据挖掘、LLM、PPO、NLP等技术的快速发展,ChatGPT得到快速发展。ChatGPT是OpenAI开发的大型预训练语言模型,GPT-3模型的一个变体,经过训练可以在对话中生成类似人类的文本响应。

ChatGPT背后的算法基于Transformer架构,这是一种使用自注意力机制处理输入数据的深度神经网络。Transformer架构广泛应用于语言翻译、文本摘要、问答等自然语言处理任务等领域。ChatGPT可用于创建能与用户进行对话的聊天机器人。

一、何为ChatGPT?和过去的人工智能有哪些区别?

ChatGPT是人工智能革命性的一大进步,众所周知,过去想要寻找某个问题的答案,可以百度、谷歌等搜索页面上手动搜索各种答案,百度和谷歌只通过爬虫技术搜索大量已知问题的相关答案。但是ChatGPT不一样,ChatGPT几乎所有的问题都可以智能地回答,并且保证原创性,答案与以前发表的任何已知答案完全不同!ChatGPT甚至可以编程、绘画、写诗、写文章!

目前,微软正在就ChatGPT开发者OpenAI投资100亿美元进行谈判。如果达成交易,OpenAI估值将达到290亿美元。与此同时,微软正在将OpenAI人工智能技术纳入其办公软件Office。

据悉,OpenAI与微软的合作历史悠久。2019年,OpenAI在微软投资10亿美元后,随后两家公司进行了多年的合作,OpenAI开发微软Azure云计算服务中的人工智能超级计算技术。

二、ChatGPT训练全过程

ChatGPT作为一个智能对话系统,效果极其震撼。记得上一次引起如此轰动的AI技术是两年半以前的事了,那时候人工智能如日中天;多模态领域是以DaLL E2、Stable Diffusion为代表的Diffusion Model,也就是最近一直流行的AIGC模型。

在整体技术路线上,ChatGPT引入了“手动标注数据+强化学习”(RLHF,从人的反馈进行强化学习)来不断Fine-tune预训练语言模型。主要目的是让LLM模型学会理解人类命令的含义(比如写一篇短文生成问题、知识回答问题、头脑风暴问题等不同类型的命令),让LLM学会判断对于给定的提示输入指令(用户的问题)什么样的回答是优质的(富含信息、内容丰富、对用户有帮助、无害、不包含歧视信息等多种标准)。

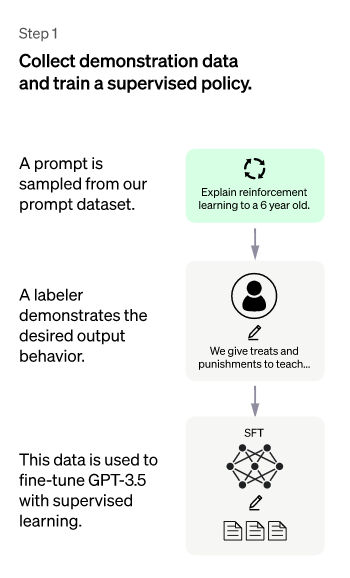

在“人工标注数据+强化学习”的框架下,具体来说,ChatGPT的训练过程分为以下三个阶段:

1、第一阶段

以GPT 3.5本身来说,虽然强大,但是很难理解不同类型的人类不同指令中所包含的不同意图,也很难判断生成的内容是否是高质量的结果。为让GPT 3.5初步理解指令中包含的意图,首先会随机抽取一批测试用户提交的prompt(即指令或问题),由专业的标注者对指定的提示给出高质量的回答,然后专业人员标注的数据对GPT 3.5模型进行微调。通过这个过程,可以认为GPT 3.5初步具备了理解人类提示所包含的意图,并根据这种意图给出相对高质量答案的能力。

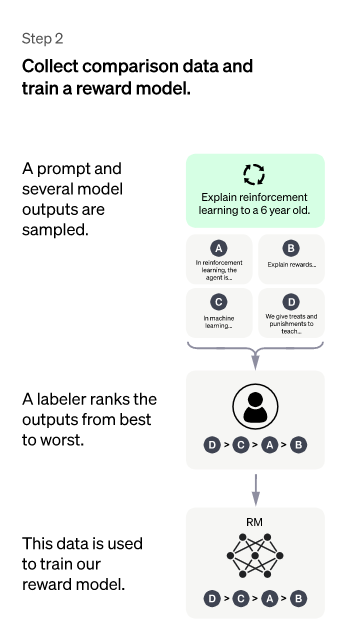

2、第二阶段

在这个阶段里,首先由冷启动后的监督策略模型为每个prompt产生X个结果,人工根据结果质量由高到低排序,以此作为训练数据,通过pair-wise learning to rank模式来训练回报模型。对于学好的RM模型来说,输入,输出结果的质量得分,得分越高说明产生的回答质量越高。

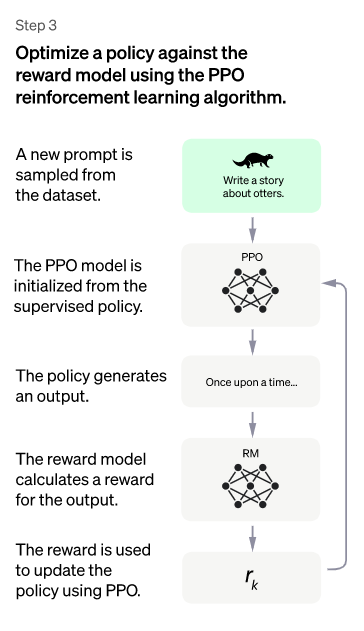

3、第三阶段

本阶段不需要手动标注数据,而是使用前一阶段学习的RM模型,根据RM评分结果更新预训练模型的参数。具体来说,首先从用户提交的prompt中随机抽取一批新的命令(指不同于第一、第二阶段的新提示,实际上非常重要,对于提升LLM模型理解instruct指令的泛化能力很有帮助),由冷启动模型初始化PPO模型的参数。然后对于随机选取的prompt,用PPO模型生成回答answer,用前一阶段训练好的RM模型给出answer质量评估的奖励分数,这是RM对整个答案(由词序列组成)给出的整体reward。有了单词序列的最终回报,每个单词可以视为一个时间步长,把reward由后往前依次传递,由此产生的策略梯度可以更新PPO模型参数。这是标准的强化学习过程,目的是训练LLM产生高reward的答案,也即是产生符合RM标准的高质量回答。

如果我们不断重复第二和第三阶段,很明显,每次迭代都使LLM模型越来越强大。因为在第二阶段,RM模型的能力通过人工标注数据来增强的,而在第三阶段,增强的RM模型对新prompt产生的回答进行更准确的评分,并使用强化学习来鼓励LLM模型学习新的高质量内容,这类似于使用伪标签来扩展高质量的训练数据,所以LLM模型得到进一步增强。显然,第二阶段和第三阶段是相互促进的,这就是为什么不断迭代会有不断增强的效果。

尽管如此,小编认为在第三阶段采用强化学习策略并不一定是ChatGPT模型效果特别好的主要原因。假设第三阶段不采用强化学习,取而代之的是以下方法:类似于第二阶段的做法,对于一个新的prompt,冷启动模型可以生成X个答案,分别由RM模型打分。我们选择得分最高的答案形成新的训练数据,并进入fine-tune LLM模型。假设换成这种模式,相信效果可能会比强化学习更好。虽然没那么精致,但效果不一定差很多。第三阶段无论采用哪种技术模式,本质上很可能都是利用第二阶段学会的RM,起到了扩充LLM模型高质量训练数据的作用。

以上是ChatGPT的训练过程,这是一个改进的instructGPT,改进点主要是标注数据收集方法上的一些差异。其他方面,包括模型结构和训练过程,基本遵循instructGPT。可以预见的是,这种Reinforcement Learning from Human Feedback技术将会迅速蔓延到其他内容生成方向,比如一个很容易想到的方向,类似“A machine translation model based on Reinforcement Learning from Human Feedback”等等。

但个人认为在NLP的某个特定内容生成领域采用这种技术意义不大,因为ChatGPT本身可以处理各种类型的任务,基本涵盖了NLP生成的很多子领域。所以对于某个NLP子领域,单独采用这种技术的价值不大,因为其可行性可以认为已经被ChatGPT验证了。如果将这种技术应用于其他模式的生成,如图片、音频、视频等,可能是更值得探索的方向。也许很快就会看到类似“A XXX diffusion model based on Reinforcement Learning from Human Feedback”之类的东西。

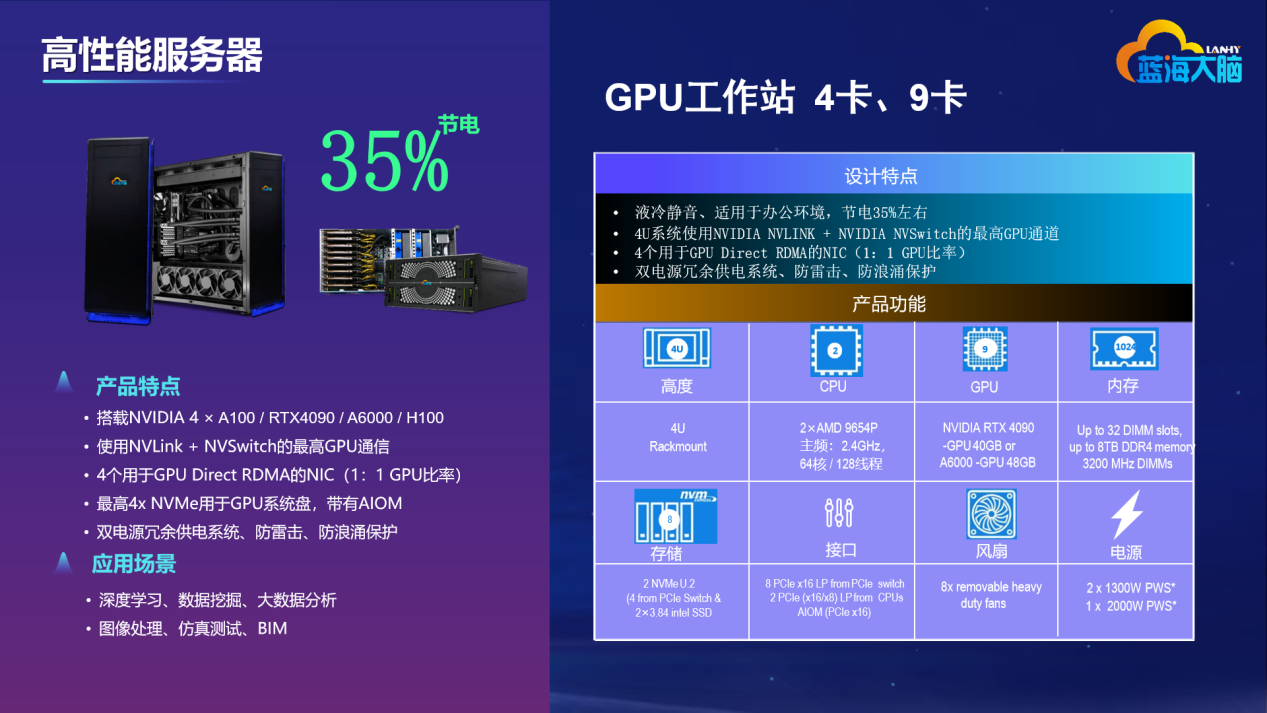

三、蓝海大脑高性能深度学习ChatGPT一体机

蓝海大脑通过多年的努力,攻克了各项性能指标、外观结构设计和产业化生产等关键技术问题,成功研制出蓝海大脑高性能深度学习ChatGPT一体机,支持快速图形处理,GPU 智能运算,性价比高,外形美观,满足了人工智能企业对图形、视频等信息的强大计算处理技术的需求。

快速、高效、可靠、易于管理的蓝海大脑液冷工作站具备出色的静音效果和完美的温控系统。在满负载环境下,噪音控制在 35 分贝左右。借助英伟达 NVIDIA 、英特尔Intel、AMD GPU显卡可加快神经网络的训练和推理速度,更快地创作精准的光照渲染效果,提供高速视频和图像处理能力,加速AI并带来更流畅的交互体验。

突破传统风冷散热模式,采用风冷和液冷混合散热模式——服务器内主要热源 CPU 利用液冷冷板进行冷却,其余热源仍采用风冷方式进行冷却。通过这种混合制冷方式,可大幅提升服务器散热效率,同时,降低主要热源 CPU 散热所耗电能,并增强服务器可靠性;支持VR、AI加速计算;深受广大深度学习ChatGPT领域工作者的喜爱。

1、主要技术指标

可 靠 性:平均故障间隔时间MTBF≥15000 h

工作温度:5~40 ℃

工作湿度:35 %~80 %

存储温度:-40~55 ℃

存储湿度:20 %~90 %

声 噪:≤35dB

2、产品特点

集中管理:支持多种异构硬件平台、操作系统和应用程序,提供单一系统镜像,实现计算节点和图形工作站节点的集中管理和统一调度

负载均衡:提供强大的负载均衡能力,保证计算服务器的任务分配尽可能均匀,避免机器忙闲不均的现象。并根据服务器的负载指标(如CPU利用率、可用内存、IO等),可以采取保护措施

资源的有效利用:避免计算任务之间发生冲突,导致任务失败或计算时间延长

优先级管理:确保在资源不足时,紧急的项目或任务可以获得更高的优先级,从而更快地启动,避免影响设计和工程的进度

3、客户收益

实现统一的用户登录、验证、作业管理、数据管理;实现资源跨部门共享以及利用率最大化

加快企业的产品研发进度、大幅缩短研发周期、提升产品的设计开发效率

提供统一平台,最大化提升在深度学习、虚拟图像、HPC等领域的快速响应以及精准预测,带来更流畅的交互体验

提高客户满意度,在图像、视频、声音等提供实时用户体验、加快搜索速度

降低总体拥有成本,简化工作流程,加速多种工作负载,提高生产力,促进企业创新