在科技界的万众瞩目下,阿里巴巴正式推出了其最新的通义千问模型Qwen3(简称千问3),该模型一经发布便迅速登顶全球最强开源模型的宝座。这一壮举发生在4月29日凌晨,阿里巴巴宣布开源这一新一代模型,标志着人工智能领域的一次重大突破。

千问3的旗舰模型Qwen3-235B-A22B,尽管参数量仅为DeepSeek-R1的三分之一,总参数量达到235B,但激活时仅需22B,实现了成本的大幅下降。更为惊人的是,其性能全面超越了R1、OpenAI-o1等全球顶尖模型,成功登顶。这一成就不仅彰显了阿里巴巴在人工智能领域的深厚积累,更为全球开源模型树立了新的标杆。

千问3的预训练数据量高达36T,经过多轮强化学习的后训练阶段,将快思考模式和慢思考模式无缝整合。这一创新使得千问3在推理、指令遵循、工具调用、多语言能力等方面均实现了大幅提升,创下了所有国产模型及全球开源模型的性能新高。千问3的推出,无疑为人工智能领域注入了新的活力。

此次发布的千问3系列模型共计八款,包括两款30B、235B的MoE模型,以及0.6B、1.7B、4B、8B、14B、32B等六款密集模型。每一款模型都在同尺寸的开源模型中取得了最佳性能(SOTA),展现了千问3系列模型的强大实力。其中,30B参数的MoE模型实现了模型性能杠杆的10倍以上提升,仅需激活3B就能媲美上代Qwen2.5-32B模型的性能;而32B版本的千问3模型,更是能够跨级超越Qwen2.5-72B的性能。

4月成为了大模型集中发布的一个月。除了千问3之外,OpenAI发布了GPT-4.1 o3、o4 mini系列模型,谷歌推出了Gemini 2.5 Flash Preview混合推理模型,豆包也公布了1.5·深度思考模型。业内还传出DeepSeek R2模型即将发布的消息,但千问3的“先发制人”无疑抢占了大模型“平民化”的先机。

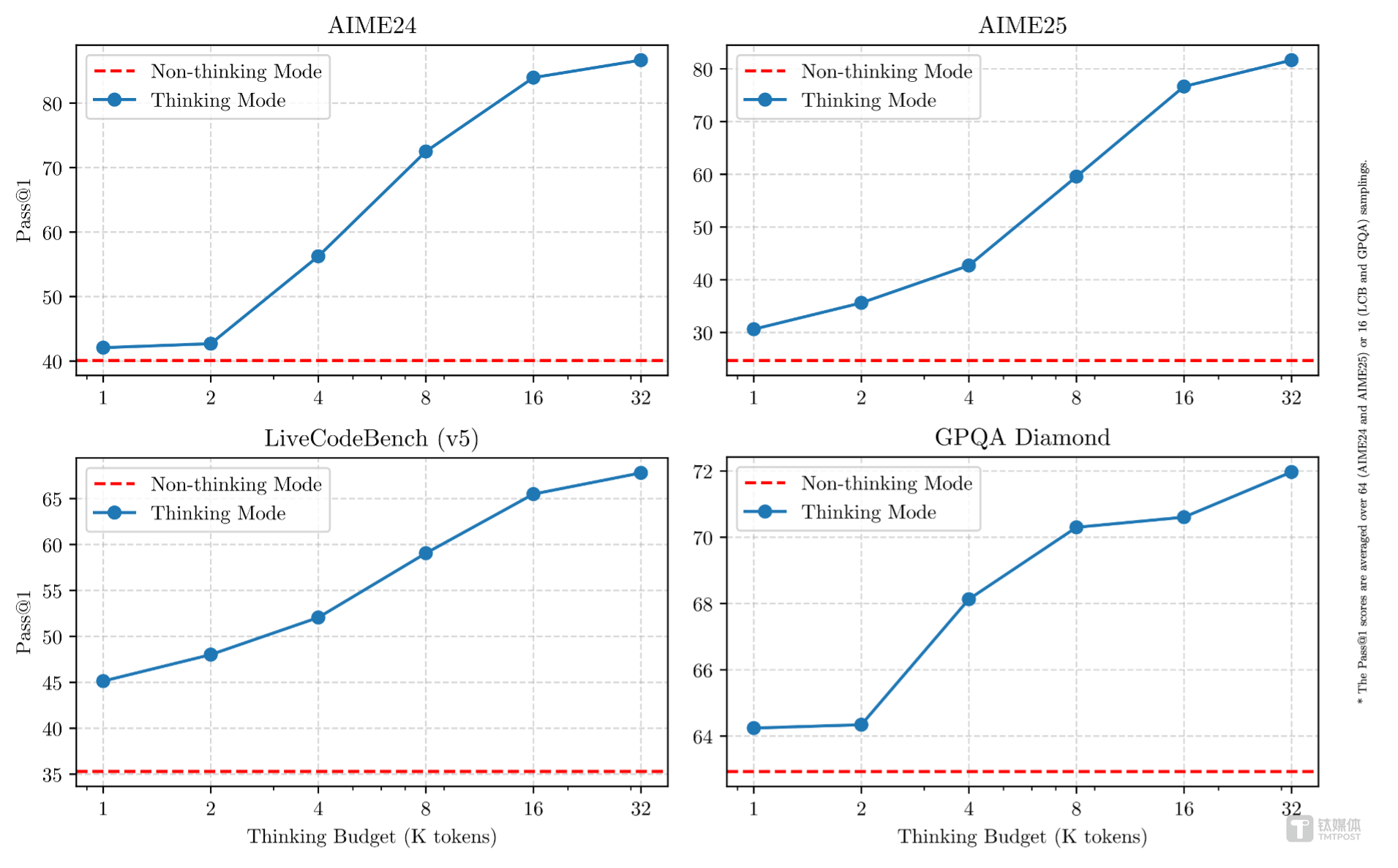

千问3作为国内首个混合推理思考模型,支持两种思考模式:慢思考模式和快思考模式。在慢思考模式下,模型会逐步推理,给出深思熟虑的答案,适合复杂问题;而在快思考模式下,模型则提供快速、即时的响应,适用于简单问题。这一创新使得千问3能够根据不同需求进行不同程度的思考,大大节省了算力消耗。

在性能大幅提升的同时,千问3的部署成本也大幅下降。仅需4张H20即可部署千问3满血版,显存占用仅为性能相近模型的三分之一。千问3模型还支持119种语言和方言,满足了全球用户的需求。目前,这些模型均在Apache 2.0许可下开源,并已在Hugging Face、ModelScope和Kaggle等平台上开放使用。

千问3不仅在性能和成本上取得了显著优势,还在智能体Agent和大模型应用落地方面做出了积极探索。在评估模型Agent能力的BFCL评测中,千问3创下了70.8的新高,超越了Gemini2.5-Pro、OpenAI-o1等顶尖模型。同时,千问3原生支持MCP协议,并具备强大的工具调用能力,将大大降低编码复杂性,实现高效的手机及电脑Agent操作等任务。

在预训练方面,Qwen3的数据集相比Qwen2.5有了显著扩展。Qwen3使用了约36万亿个token的数据进行预训练,几乎是Qwen2.5的两倍。为了构建这一庞大的数据集,千问团队不仅从网络上收集数据,还从PDF文档中提取信息,并利用专家模型合成数学和代码数据。预训练过程分为三个阶段,逐步提升了模型的语言技能和通用知识。

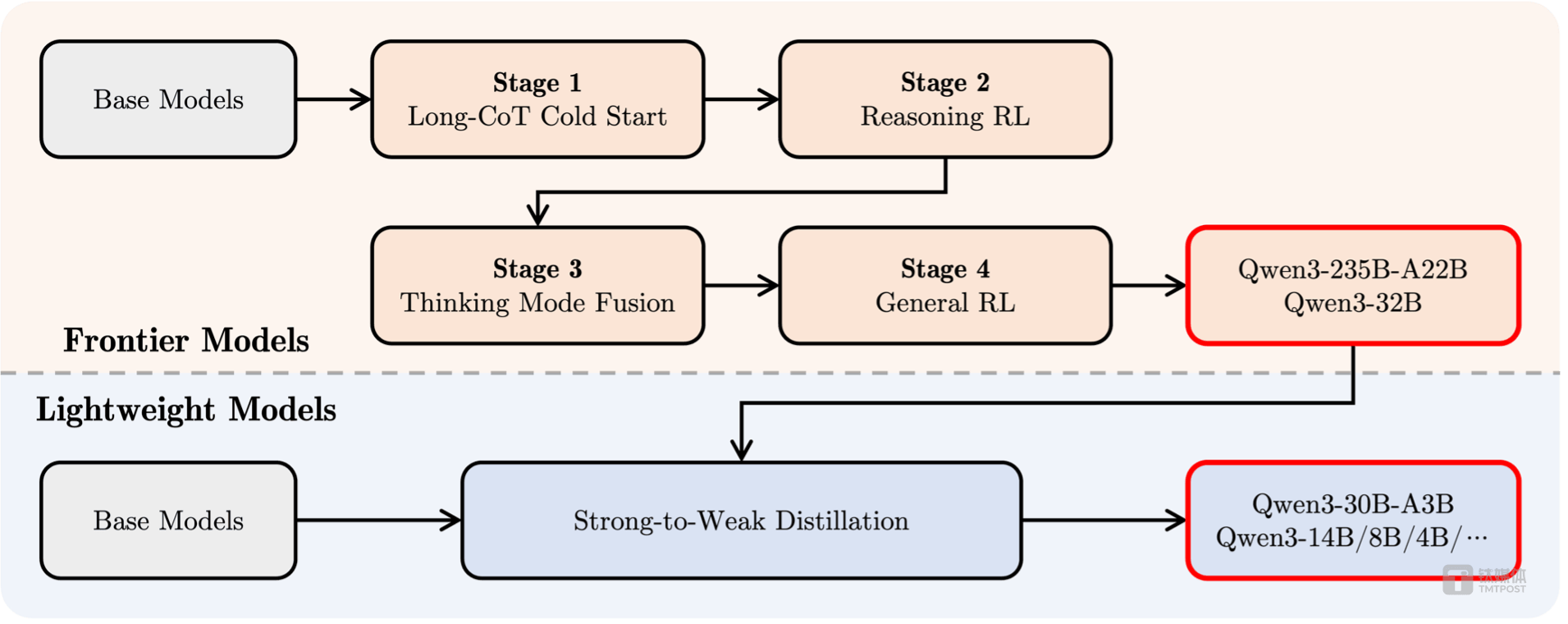

在后训练方面,千问团队实施了一个四阶段的训练流程,旨在开发同时具备思考推理和快速响应能力的混合模型。这一流程包括长思维链冷启动、长思维链强化学习、思维模式融合以及通用强化学习。经过这一系列的训练,千问3成功实现了推理和快速响应能力的无缝结合。

目前,个人用户已经可以通过通义APP直接体验千问3,夸克也即将全线接入千问3。阿里巴巴通义已经开源了200余个模型,全球下载量超过3亿次,千问衍生模型数超过10万个。这一成就不仅超越了美国的Llama模型,更使千问3成为了全球第一开源模型。