在近期举办的2025智源大会上,面壁智能这家北京的大模型创新企业,推出了其开源模型MiniCPM 4.0的两个新版本,分别为0.5B和8B,内部代号“前进四”。这一发布引起了业内广泛关注。

据悉,MiniCPM4-0.5B的训练成本仅为Qwen3-0.6B的2.7%,却以一半的参数量实现了性能翻倍,综合得分平均分高达52.06分,远超同类模型。更为出色的是,面壁智能还推出了一个0.5B的三级量化版本,平均得分更是达到了56分,这一成绩实属不易。

而MiniCPM4-8B的表现同样令人瞩目。其训练开销仅为22%,并加入了长上下文稀疏化版本,使得同等参数下性能更强。在同类端侧模型排行榜中,MiniCPM4-8B的综合得分甚至超越了Gemma3-12B,与Qwen3-8B比肩,位居榜首。

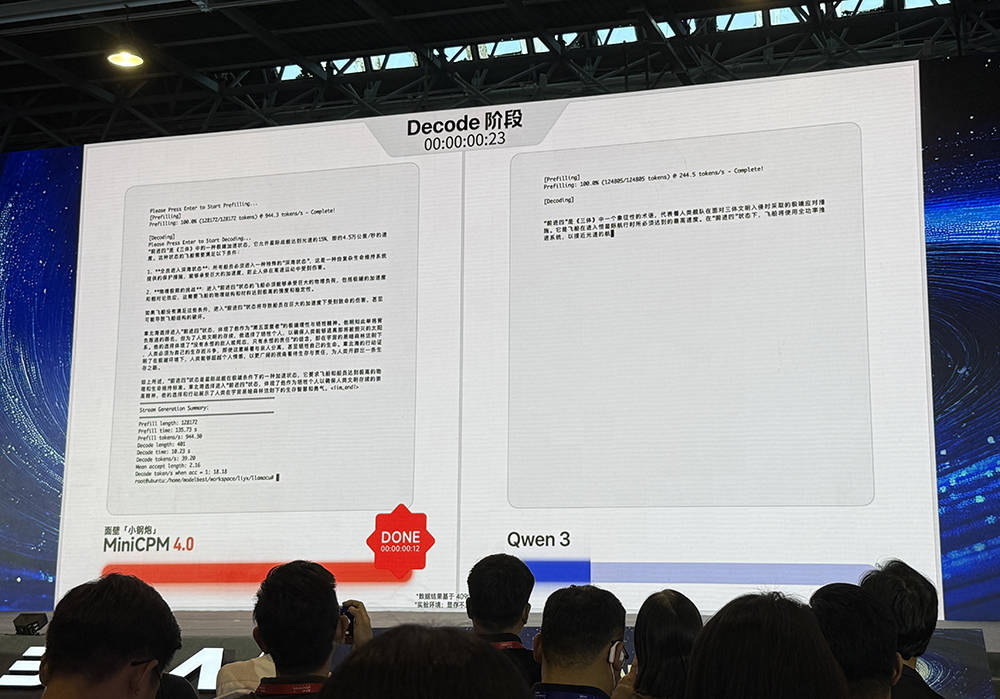

面壁智能CEO李大海在会上表示,MiniCPM4模型的最大特点就是速度快。在处理极端场景下的140K上下文时,需要极大的端侧内存。而在Jetson Orin AGX(64G)或RTX 4090(24G)硬件上运行128K长文本时,像Qwen3-8B这样未进行上下文稀疏化的模型,显存往往不够用,需要借助CPU内存,这会导致速度急剧下降。而MiniCPM4-8B则通过快速稀疏化工作,将占用的低长文本缓存降至1/4,在常规场景中至少可以取得3-5倍的速度优势。

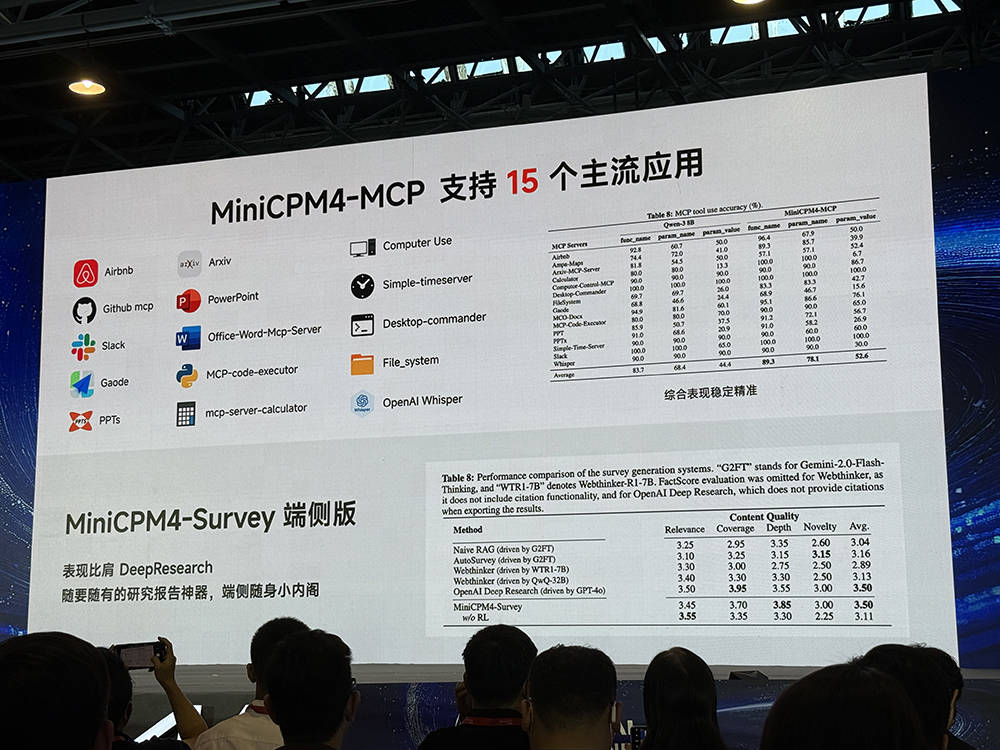

李大海进一步透露,在显存受限的极限场景中,MiniCPM4的测试数据甚至可以达到220倍的速度提升。面壁智能的MiniCPM4-MCP模型在端侧利用MCP协议,支持15个主流应用,综合评测表现得分颇高。而另一个MiniCPM4-Survey端侧版则可在AI PC上构建深度研究服务,成为离线可用的随身研究报告工具,有助于保护本地隐私数据。

值得注意的是,面壁智能与英特尔紧密合作,首次在端侧解锁了128K长上下文窗口。在英特尔平台上,基于InfLLM 2.0稀疏注意力结构,实现了3.8倍加速的推理优化效果。同时,MiniCPM4已经可以在华为昇腾、联发科、高通等主流芯片上流畅运行,并支持vLLM、AutoGPT等推理框架,欧拉版也正在积极适配中。

那么,面壁智能是如何实现MiniCPM4又快又好的表现的呢?李大海分享了背后的技术细节。他提到,这是行业首个全开源系统级上下级稀疏化高效创新。MiniCPM4采用了InfLLM 2.0混合稀疏注意力结构,通过分块分区域处理文本,只对最具相关性的重点区域进行注意力计算,从而大大提高了效率。同时,面壁智能还创新地采用了高效的自动双频换挡技术,长文本用稀疏方案,短文本用稠密方案,进一步提升了性能。

在推理方面,面壁智能自研了全套端侧高性能推理框架,包括实现稀疏、投机和量化的高效结合的CPM.cu,极致低位宽量化的BitCPM,以及面向多平台端侧芯片极致优化的Arkinfer。这些创新使得MiniCPM4在端侧的表现更加出色。