在人工智能领域的一次重大突破中,MiniMax公司于近日震撼发布了全球首个开源大规模混合架构推理模型——MiniMax-M1。这一发布不仅标志着AI技术的新里程碑,还伴随着一项为期五天的连续更新计划,引起了业界的广泛关注。

MiniMax-M1的参数规模达到了惊人的4560亿,每个token能激活459亿参数,支持长达100万的上下文输入,以及业内最长的8万token推理输出。这一能力不仅与闭源模型巨头谷歌Gemini 2.5 Pro持平,更是DeepSeek-R1的8倍之多。为了满足不同需求,MiniMax还训练了两个版本的M1模型,思考预算分别为40K和80K。

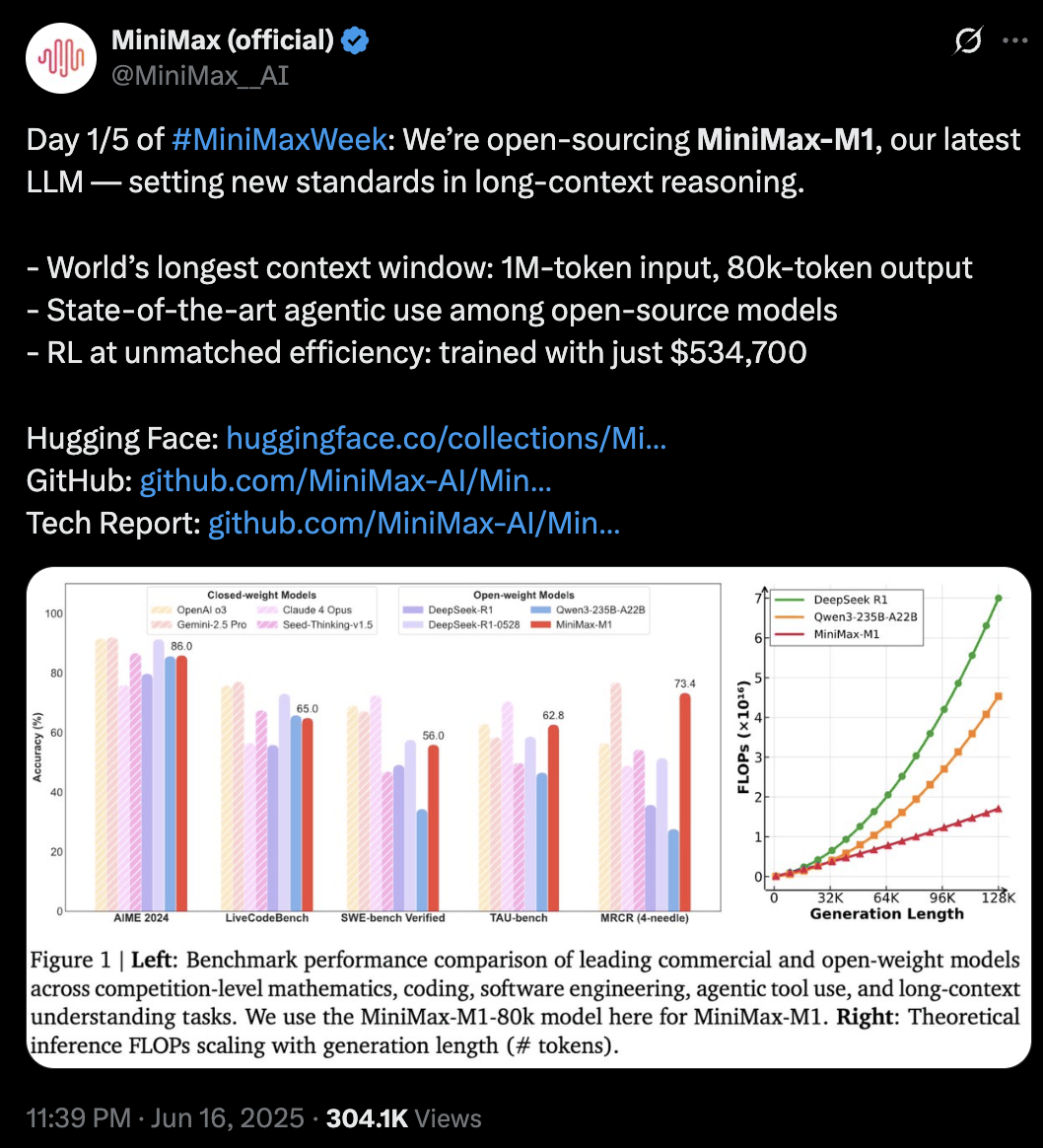

在标准基准测试集上的对比结果显示,MiniMax-M1在复杂的软件工程、工具使用以及长上下文任务方面,均展现出了优于DeepSeek-R1和Qwen3-235B等开源模型的表现。这一成就不仅得益于其庞大的参数规模,更在于其独特的混合架构和高效算法。

在M1的研发过程中,MiniMax团队采用了创新的强化学习方法。据透露,整个强化学习阶段使用了512块H800训练了三周,租赁成本仅为53.74万美金(折合人民币约385.9万元),远低于最初的成本预期。这一高效的成本控制策略,无疑为M1的成功发布奠定了坚实基础。

对于用户而言,MiniMax-M1提供了极大的便利。在MiniMax APP和Web平台上,用户可以不限量免费使用M1。而在API价格方面,MiniMax也提供了多种选择。对于0-32k的输入长度,输入价格为0.8元/百万token,输出价格为8元/百万token;对于32k-128k的输入长度,输入价格为1.2元/百万token,输出价格为16元/百万token;对于128k-1M的输入长度,输入价格为2.4元/百万token,输出价格为24元/百万token。与DeepSeek-R1相比,M1在第三档价格上展现出了绝对优势,因为DeepSeek-R1并不支持如此长的输入长度。

在评测方面,MiniMax-M1在软件工程、长上下文和工具使用等方面的表现尤为突出。在OpenAI发布的MRCR测试集中,M1虽然略逊于Gemini 2.5 Pro,但相比其他模型仍具有明显优势。在评估软件工程能力的SWE-bench Verified测试集中,M1的表现也仅次于DeepSeek-R1-0528。特别是在航空业的TAU-bench(airline)测试集中,M1的表现优于所有其他开源和闭源模型。然而,在数学和编程能力方面,M1的得分相对较低,仍有提升空间。

MiniMax-M1的成功发布,不仅展示了MiniMax在AI技术方面的深厚积累,更为整个行业带来了新的发展机遇。随着AI技术的不断进步和应用场景的不断拓展,MiniMax-M1有望在未来发挥更大的作用,推动人工智能技术的持续创新和发展。