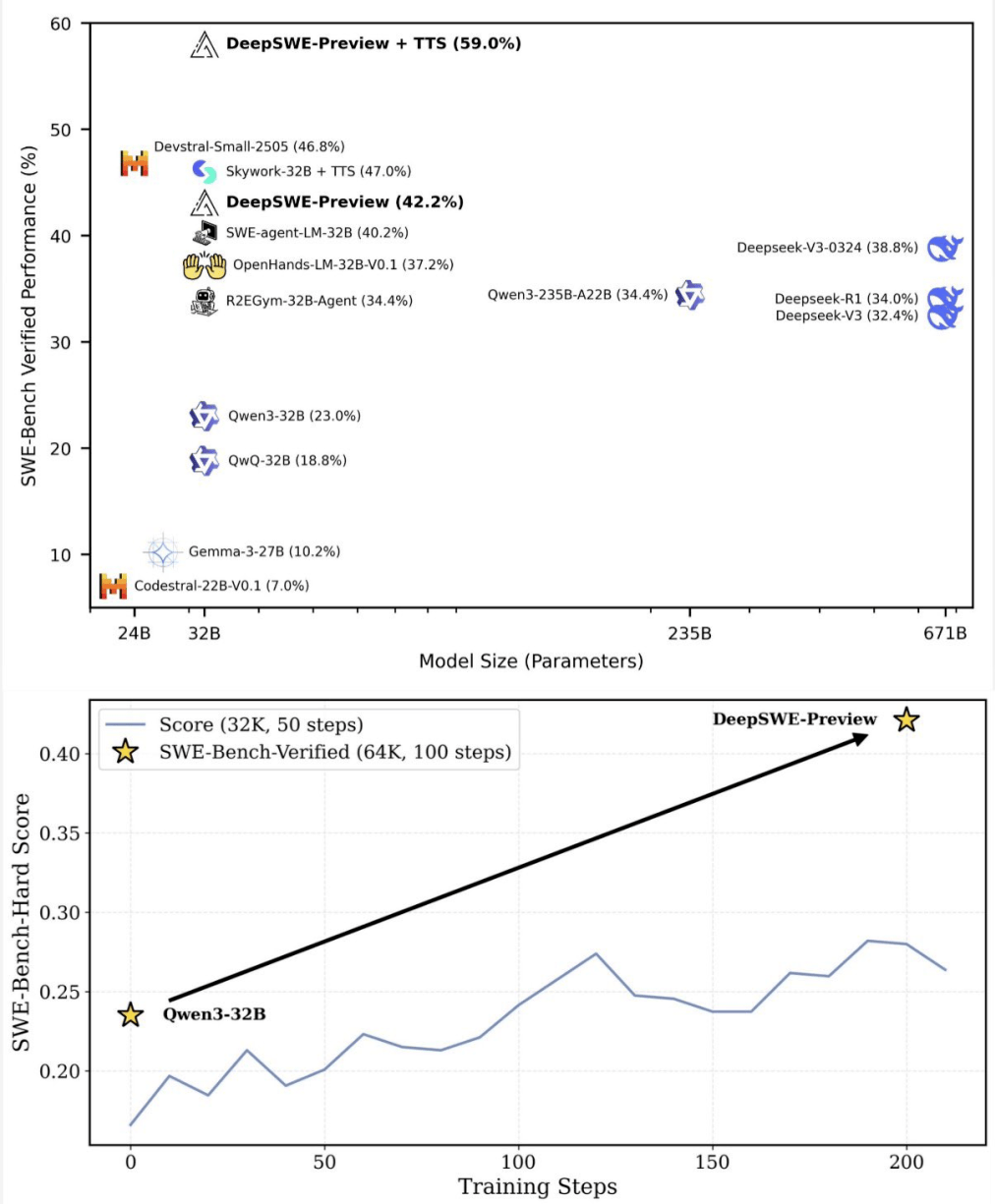

在人工智能编程领域,一场革命性的突破正在悄然发生。新晋AI编程冠军DeepSWE,凭借其纯强化学习的训练方式,在基准测试中取得了59%的准确率,这一成绩大幅刷新了现有技术的上限。

DeepSWE的诞生,打破了长期以来闭源模型在该领域的垄断地位。这款开源软件工程模型,基于Qwen3-32B架构,完全通过强化学习进行训练,无需依赖任何“老师模型”。这一创新性的训练方法,使得DeepSWE能够从零开始,逐步成长为一个性能卓越的智能体。

DeepSWE的训练过程充满了挑战与创新。它采用了模块化RL后训练框架rLLM,这一框架使得用户能够轻松构建一个由强化学习训练的AI助手,极大地简化了训练流程。同时,DeepSWE在R2E-Gym训练环境中进行训练,该环境为高质量可执行软件工程(SWE)任务提供了可扩展的管理方案。

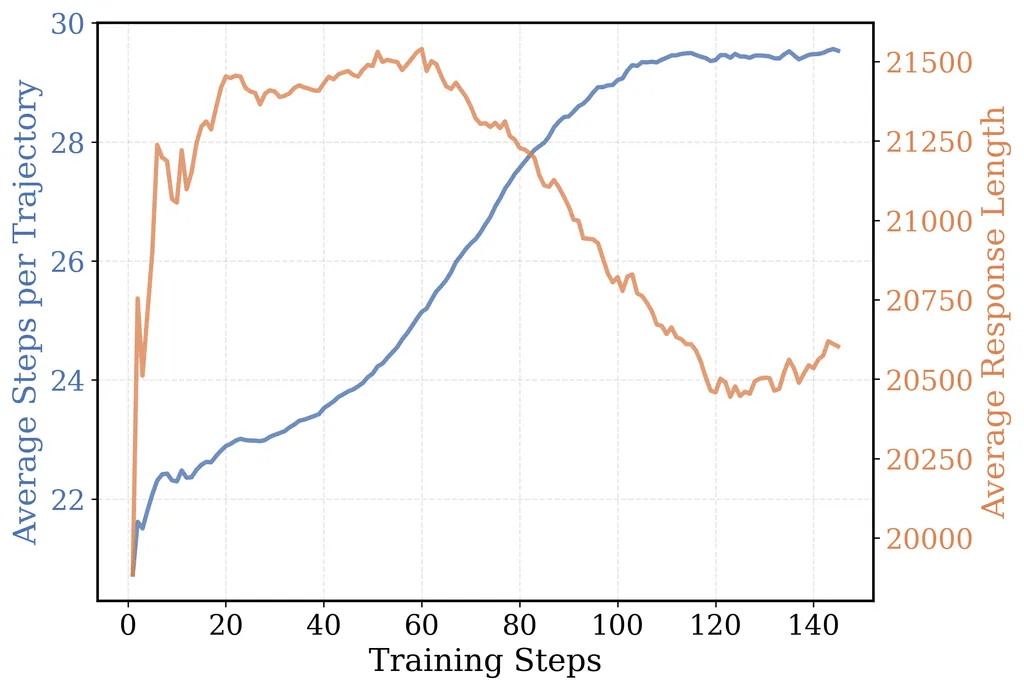

在动作空间方面,R2E-Gym定义了包括执行Bash命令、搜索、文件编辑和完成/提交等四个工具。这些工具共同构成了DeepSWE在训练过程中的操作基础。而奖励模型则采用了一种稀疏的结果奖励模型(ORM),通过简单的“成功/失败”奖励信号,DeepSWE自发地学会了高级程序员才具备的复杂行为,如主动思考边缘案例和回归测试,以及根据任务复杂程度自适应调整思考深度。

算法方面,DeepSWE摒弃了传统的蒸馏方法,仅使用强化学习进行直接训练。研发人员独家改良的GRPO++算法,在之前的基础上进行了增强,进一步提升了模型的稳定性和性能。还整合了包括Clip High (DAPO)、无KL损失(DAPO)、无奖励标准差(Dr.GRPO)、长度归一化(Dr.GRPO)、一法(Loop/RLOO)、紧凑过滤和无熵损失在内的七个算法,共同构成了DeepSWE的训练配方。

其中,“紧凑过滤”算法对模型训练尤为关键。它不仅有效防止了训练过程中的奖励崩溃,还减少了每一步的过度思考,鼓励跨步骤的长篇推理,从而显著提升了模型的性能。

然而,训练过程中也遇到了不少挑战。特别是在扩展SWE-Bench环境时,由于需要同时启动大量Docker容器,一度导致Docker崩溃。为了解决这一问题,研发人员将Kubernetes支持集成到了R2E-Gym环境中,实现了容器的高效调度。同时,为每个服务器配备了高性能硬件,并提前下载了所需软件镜像,以确保训练过程的顺利进行。

在评估策略方面,DeepSWE采用了“测试时扩展(TTS)”策略,通过多方案生成和智能验证的方式,将性能推向了新的高度。通过扩展上下文长度和扩展代理部署两种方法,DeepSWE在SWE-Bench Verified上达到了59%的准确率,实现了新的技术上限。

DeepSWE的成功,离不开其背后的研发团队。项目负责人Michael Luo,加州大学伯克利分校电气工程与计算机科学系博士生,对人工智能和系统领域有着深入的研究。他带领的团队,凭借出色的研发能力和创新精神,成功打造了这款开源软件工程模型。

DeepSWE的诞生,标志着人工智能编程领域的一次重大突破。它不仅刷新了技术的上限,更为未来的软件开发和智能化转型提供了无限可能。