苹果机器学习团队近日在GitHub平台上震撼发布并开源了一款名为FastVLM的视觉语言模型,这款模型是苹果自研技术的又一力作。FastVLM提供了三种不同规模的版本,分别是0.5B、1.5B和7B,全部基于苹果特有的MLX框架构建,并通过LLaVA代码库进行了深度训练。尤为FastVLM针对Apple Silicon设备进行了优化,旨在提升端侧AI运算的效率。

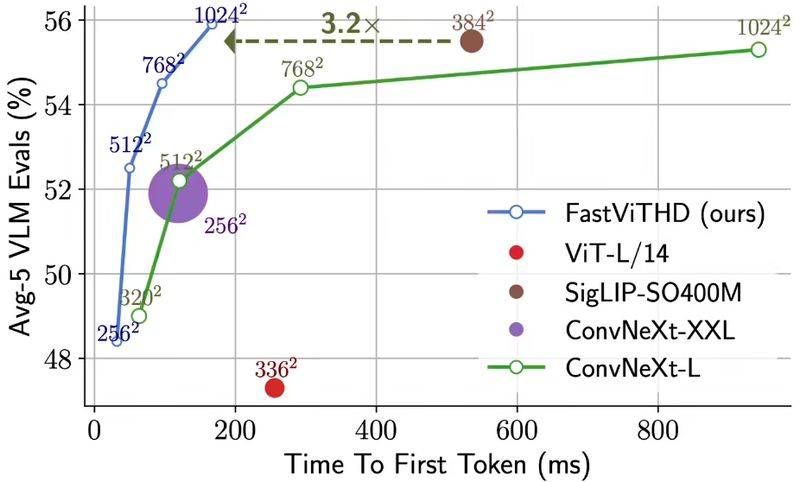

FastVLM的核心组件是一个创新的混合视觉编码器,名为FastViTHD。这款编码器专为处理高分辨率图像而设计,旨在实现高效的VLM性能。据官方数据显示,FastViTHD的处理速度相较于同类模型提升了3.2倍,而其体积仅为前者的3.6分之一。这一显著的性能提升得益于其减少的令牌输出量和大幅缩短的编码时间。

技术文档揭示,FastVLM不仅保持了高精度,还实现了高分辨率图像处理的近实时响应,同时所需的计算量远低于同类模型。特别是最小版本FastVLM-0.5B,其首词元响应速度比LLaVA-OneVision-0.5B模型快了85倍,而视觉编码器的体积更是缩小了3.4倍。当与Qwen2-7B大语言模型搭配使用时,FastVLM使用单一的图像编码器即可超越Cambrian-1-8B等近期的研究成果,首词元响应速度提升了7.9倍。

苹果技术团队表示,FastVLM的开发是基于对图像分辨率、视觉延迟、词元数量以及LLM大小的全面效率分析。该模型在延迟、模型大小和准确性之间找到了最佳的平衡点。这一技术的潜在应用场景指向了苹果正在积极研发的智能眼镜类穿戴设备。据多方消息透露,苹果计划在2027年推出与meta Ray-Bans相媲美的AI眼镜,并可能同期发布配备摄像头的设备。

FastVLM的本地化处理能力为这类设备提供了有力的支持,使它们能够在脱离云端的情况下实现实时视觉交互。MLX框架的引入,使得开发者能够在Apple设备上本地训练和运行模型,同时兼容主流的AI开发语言。FastVLM的推出,无疑证实了苹果正在构建一个完整的端侧AI技术生态系统。