在科技领域的一次重大突破中,Google DeepMind于近日宣布了Gemini Robotics On-Device的诞生,这是首个能够完全在机器人本地部署的视觉-语言-动作(VLA)模型。这一创新标志着具身智能(Embodied AI)的发展迈入了新阶段,即从云端依赖转向本地自主运行,为行业应用开辟了全新的可能性。

长久以来,具身智能的两大部署难题——对云计算资源的严重依赖和模型体积庞大难以在机器人有限计算资源上高效运行——一直困扰着业界。Gemini Robotics On-Device的推出,有效解决了这些问题。该模型能够在算力受限的机器人设备上流畅运行,展现出卓越的通用性和任务泛化能力,尤其在对延迟敏感的应用中展现出显著优势。

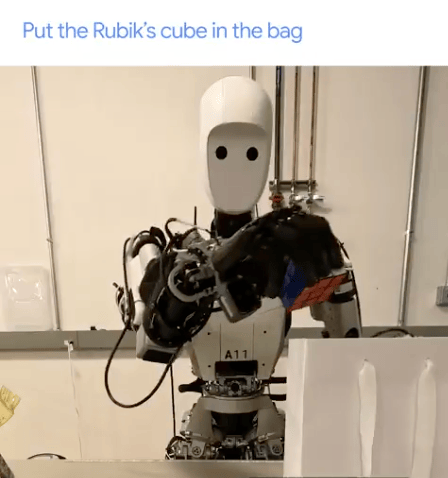

DeepMind的演示视频中,Gemini Robotics On-Device在无网络连接状态下成功完成了诸如“将魔方放入包装袋”和“拉开包包拉链”等复杂任务,这些任务涵盖了感知、语义理解、空间推理和高精度执行等多个环节,充分展示了其高水平的通用能力和稳定性。据DeepMind研究人员介绍,该模型仅需50至100次演示就能学习新技能,大大提升了模型的应用范围和部署灵活性。

值得注意的是,尽管Gemini Robotics On-Device最初是针对特定机器人进行训练的,但它却能够泛化到不同形态的机器人上,如双臂机器人和人形机器人,这进一步扩展了其应用潜力。在演示视频中,可以看到该模型在双臂Franka机器人上执行通用指令,包括处理未见过的物体和场景、完成折叠衣服等灵巧任务,或执行需要精确度和灵巧性的工业皮带组装任务。

谷歌还首次开放了VLA模型的微调功能,这意味着工程师或机器人公司可以根据自有数据对模型进行定制训练,从而优化其在特定任务、场景或硬件平台上的表现。同时,谷歌推出了Gemini Robotics SDK,为开发者提供了模型评估和快速调整的便利。这些举措表明,谷歌正致力于打造一个开放、通用且易于开发的机器人平台,类似于安卓系统在智能手机行业所扮演的角色。

具身智能领域的一位专家表示,Gemini Robotics On-Device的推出标志着机器人终于能够走进真实环境。以往受限于带宽和算力,许多机器人AI只能停留在示范阶段。而这次谷歌的进展意味着通用模型可以真正运行在硬件终端上,未来即使不依赖联网也能执行复杂操作。这一创新将使得机器人更适合家庭、医疗、教育等敏感场景,解决数据隐私、实时反应、安全稳定性等核心挑战。

随着AI算力和模型架构的持续演进,边缘智能正逐步从传统的物联网(IoT)走向以具身智能为代表的更高级阶段。本地VLA模型将成为下一个竞争焦点。一位关注机器人领域的投资人认为,一旦硬件标准趋于统一,将大大推动算法的标准化与本地部署的实现。谷歌正在构建的“机器人安卓生态”愿景预示着一个更加标准化、易于开发与普及的具身智能时代的到来。

然而,在实际落地过程中,挑战依然严峻。机器人硬件的多样性和复杂性意味着即使是强大的通用模型,也需要针对每种具体硬件进行细致的适配和调优。要在海量、多样化的实际应用场景中真正落地,数据收集和标注的成本可能异常高昂,特别是在需要专业操作知识和设备的工业或特定服务场景。更重要的是,机器人需要在极其复杂、动态且不可预测的真实世界环境中保持鲁棒性,这对模型的实时感知和决策能力提出了严苛考验。