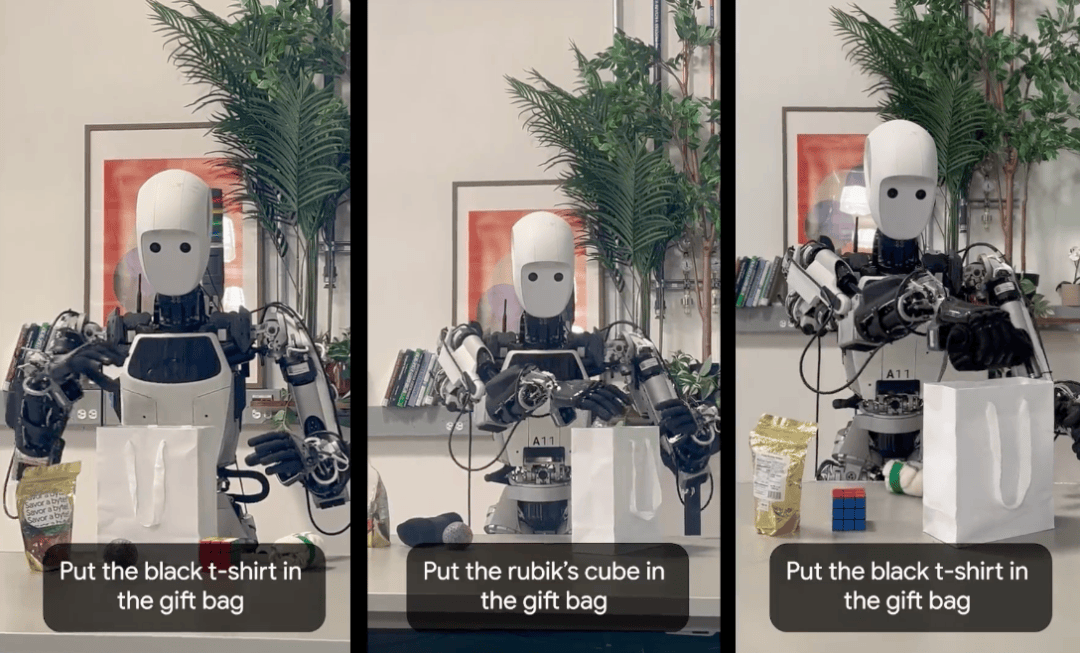

在具身智能领域,VLA(Vision-Language-Action,视觉-语言-动作)模型正迅速崛起,成为业界瞩目的焦点。谷歌近期推出的Gemini Robotics On-Device模型,以其强大的离线运行能力和高灵巧度任务执行能力,为机器人技术树立了新的标杆。

这款专为机器人设计的端侧模型,无需依赖数据网络,即可在机器人设备上本地运行。在多种测试场景中,Gemini Robotics On-Device展现了出色的视觉识别、语义理解和行为泛化能力。它能够理解自然语言指令,并完成诸如拉开拉链、折叠衣物等复杂任务,展现了极高的智能化水平。

VLA模型的出现,标志着具身智能领域的一次重大突破。它让机器人能够将语言意图、视觉感知与物理动作紧密结合,形成连续的决策流。这一技术范式不仅提升了机器人的智能化水平,更为机器人产业的落地应用开辟了广阔的空间。

值得注意的是,谷歌并非唯一在VLA领域布局的巨头。今年以来,微软、Figure AI等海外公司也相继推出了自己的VLA模型。在国内,银河通用、智元机器人、自变量机器人等机器人公司也在这一领域展开了积极探索。

谷歌DeepMind团队推出的Gemini Robotics模型,被誉为“机器人版的安卓”。这一模型基于Gemini 2.0打造,能够让机器人理解复杂环境并执行精细任务。在演示视频中,Gemini Robotics借助双臂机器人,流畅地完成了折纸、拉拉链等高难度动作,展现了其强大的应用能力。

而Gemini Robotics On-Device的推出,更是将具身智能从云端算力依赖转向了本地自主运行。这一转变不仅解决了机器人在无网络环境中的作业难题,还提高了模型在机器人有限计算资源上的运行效率。业内人士认为,这将为机器人在更多场景中的应用提供可能。

除了谷歌之外,国内机器人公司也在VLA领域取得了显著进展。银河通用推出的TrackVLA和GroceryVLA模型,分别针对导航和零售场景进行了优化。在演示中,搭载了GroceryVLA的机器人能够根据语言指令,在商超场景中自主为顾客选择食物并送到手中,全程无需遥控操作。

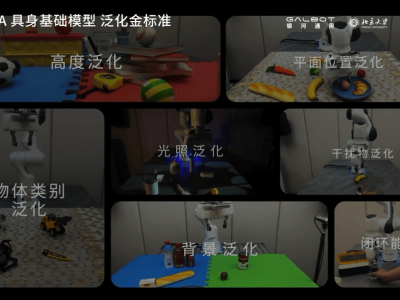

智元机器人则发布了首个通用具身基座模型智元启元大模型(GO-1),该模型采用了Vision-Language-Latent-Action (ViLLA) 架构,实现了小样本快速泛化。目前,GO-1大模型已成功部署到智元多款机器人本体之中,展现了良好的应用效果。

自变量机器人研发的WALL-A模型,则是世界上最大规模的端到端统一具身大模型。这一模型突破了传统分层架构的噪声传递问题,支持从原始传感器信号到机器人动作的纵向统一和横向任务统一,跨任务泛化能力出色。自成立以来,自变量机器人已完成了多轮融资,累计融资金额超过10亿元。

随着VLA模型的不断发展,机器人将拥有更加智能、灵活的应用能力。这一技术趋势将推动机器人产业迈向新的高度,为人类社会带来更多便利和惊喜。