在人工智能领域,大公司凭借资源优势引领技术浪潮,而小型创业团队和高校研究机构正面临新的挑战。随着预训练阶段逐渐饱和,如何让模型从“记忆数据”转向“理解推理”成为行业焦点。强化学习被视为突破这一瓶颈的关键技术,但其高昂的算力需求和复杂的工程实现,长期制约着中小团队的发展。近期,一支中国科研团队推出的后训练平台,正试图改变这一局面。

由95后科学家主导的Mind Lab团队,发布了名为MinT(Mind Lab Toolkit)的后训练工具包。该平台宣称支持在普通CPU设备上完成万亿参数模型的训练验证,并通过分布式架构将成本降低至行业水平的十分之一。团队核心成员来自清华大学、麻省理工学院等顶尖学府,兼具OpenAI、DeepMind等机构的研发经验,其学术成果累计被引用超3万次。这一背景为MinT的技术突破提供了背书。

预训练模型的局限性日益凸显。当前主流模型在完成训练后参数固定,难以适应动态变化的用户需求,导致实际应用中频繁出现“重复错误”现象。强化学习通过引入环境反馈机制,使模型能够持续优化决策能力,但传统实现方式需要海量算力支撑。Mind Lab提出的解决方案,通过低秩适配技术(LoRA)在模型参数层引入可训练模块,既保留了预训练模型的基础能力,又大幅降低了训练资源消耗。

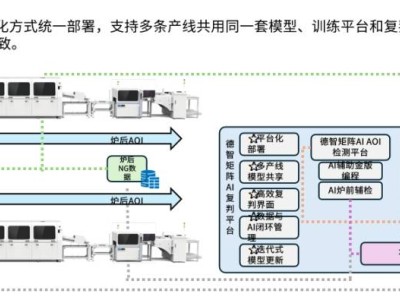

对于开发者而言,MinT的核心价值在于简化工程复杂度。用户只需编写少量Python代码,平台即可自动完成集群调度、资源分配和故障恢复等底层操作。其API设计完全兼容海外竞品Tinker,现有代码迁移成本接近零。目前平台已支持Qwen3-VL视觉语言模型、π0具身智能模型等前沿架构,覆盖从基础研究到医疗、脑机接口等垂直领域的应用场景。

在学术验证层面,清华大学黄高团队利用MinT探索强化学习突破模型知识边界的机制,上海交通大学蔡盼盼实验室则将其应用于具身决策大模型训练。行业应用案例显示,硅谷创业公司Eigen AI借助该平台合成数据训练1T参数的智能体模型;瑞铭医疗通过强化学习优化医疗编码系统,准确率提升后已落地数十家三甲医院。这些实践表明,MinT的技术路线具备跨领域通用性。

该平台的推出,折射出中国AI团队在工程化领域的独特优势。区别于海外竞品侧重API范式定义,MinT更强调“开箱即用”的完整工具链构建。其技术文档详细披露了万亿参数模型的训练方法论,包括学习率选择、并行策略配置等关键参数,这种开放态度在商业公司中较为罕见。随着后训练阶段成为行业竞争新焦点,这类降低技术门槛的基础设施,或将重塑AI生态的力量格局。