在机器人技术的前沿探索中,智元机器人近日宣布了一项重大突破,正式推出了其自主研发的大型仿真框架——AgiBot Digital World。这一框架旨在为机器人操作提供一个全面的仿真数据生成方案,包括预训练的大规模仿真数据和统一的模型评测标准,并慷慨地开源了海量的仿真数据。

AgiBot Digital World是专为机器人操作技能的研究与应用量身打造的仿真平台,集成了丰富的三维资产、多样化的专家轨迹生成机制以及全面的模型评估工具。通过高精度的模拟训练场景,该框架能够自动生成数据,提供一系列具身仿真服务,如生动模拟各种机器人训练场景。

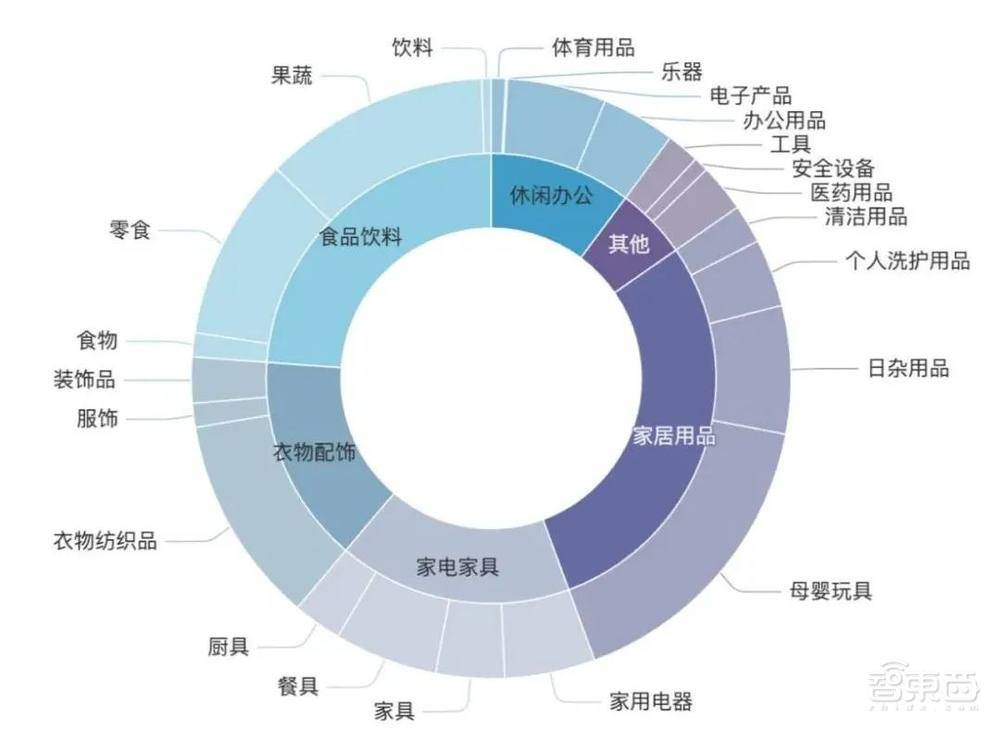

智元机器人还同步上线了规模庞大的仿真数据集AgiBot Digital World Dataset,该数据集覆盖了五大类场景,包括家居、商超、办公、餐饮和工业,涵盖了超过180种具体物品、9种常见材质和12种核心技能。这些三维资产通过精细的人工建模、三维重建技术和生成式人工智能(AIGC)转化而来,能够满足复杂机器人操作任务的仿真需求。

AgiBot Digital World的三维资产库,拥有多样化的物体、场景和机器人模型。基于NVIDIA Isaac-Sim仿真平台,该框架提供了高度逼真的视觉渲染和精确的物理模拟,使得仿真情景与真实世界之间的域差异极小,感知和交互的细节异常真实。例如,光透过玻璃窗投射的光影、随着机器人动作而变化的倒影,都显得非常自然。

AgiBot Digital World还能模拟出真实世界的物理效应,如当机器人把小车放入篮子时,两者会因触碰而晃动。更重要的是,该框架引入了多模态大模型,支持基于资产库自动生成操作任务,以及根据指定任务自动生成操作场景和物体布局,从而实现数据闭环。这意味着,在实际训练需求下,可以灵活创建多样化、复杂度可调的仿真任务与仿真环境。

在数据生成方面,AgiBot Digital World提供了多元化的专家轨迹生成策略。这些策略包括真机操作数字孪生,即将真实机器人的操作轨迹数据1:1映射到仿真环境中,用于生成丰富的数据标签和专家示例轨迹;具身智能体自动生成,即将多模态大模型与模块化机器人操作小模型结合,自动化生成机器人操作轨迹;以及仿真遥操作,通过人机交互界面允许操作者在仿真环境中通过遥操作获取专家演示数据。

在仿真过程中,具身智能数据生成引擎可以进行环境光照、物体材质、物理属性域的随机化,并支持多种操作轨迹增强方式,以生成具有多样性和鲁棒性的专家轨迹数据,增强模型在真实环境中的泛化能力。同时,该引擎还支持包括多视角RGB-D图像、触觉信息、机器人状态信息在内的多模态数据,用于策略学习。

智元机器人此次开源的仿真数据,为各类场景应用提供了坚实的开发基础和广泛的应用可能性。这些高质量的数据,不仅支持快速泛化,还包含多个步骤的长程任务和多技能组合的短程任务,适用于多技能训练和多任务泛化执行。通过12种核心技能的组合,数据集能够灵活应对各种复杂任务,提升机器人操作的适应性和效率。

据了解,AgiBot Digital World后续还将进一步扩展,适配更多的机器人本体和执行器,并融合更多模态,包括深度噪声传感器仿真、触觉传感仿真等。智元机器人的这一开源行动,无疑将加速具身智能技术的开发和应用,降低行业研发门槛,为机器人技术的未来发展注入新的活力。