在科技巨头纷纷布局人工智能领域的浪潮中,小米公司近期宣布了一项重大进展,正式推出了其首个专注于提升模型推理能力的大型语言模型——Xiaomi MiMo,并且决定将其开源,以供全球开发者共同研究和使用。

据小米方面介绍,MiMo模型的诞生,源于对当前大模型技术瓶颈的深刻洞察以及对提升模型推理能力的迫切需求。该模型旨在通过技术创新,打破现有预训练模型的局限性,进一步激发AI在复杂逻辑推理、数学运算及代码生成等高级认知任务上的潜力。

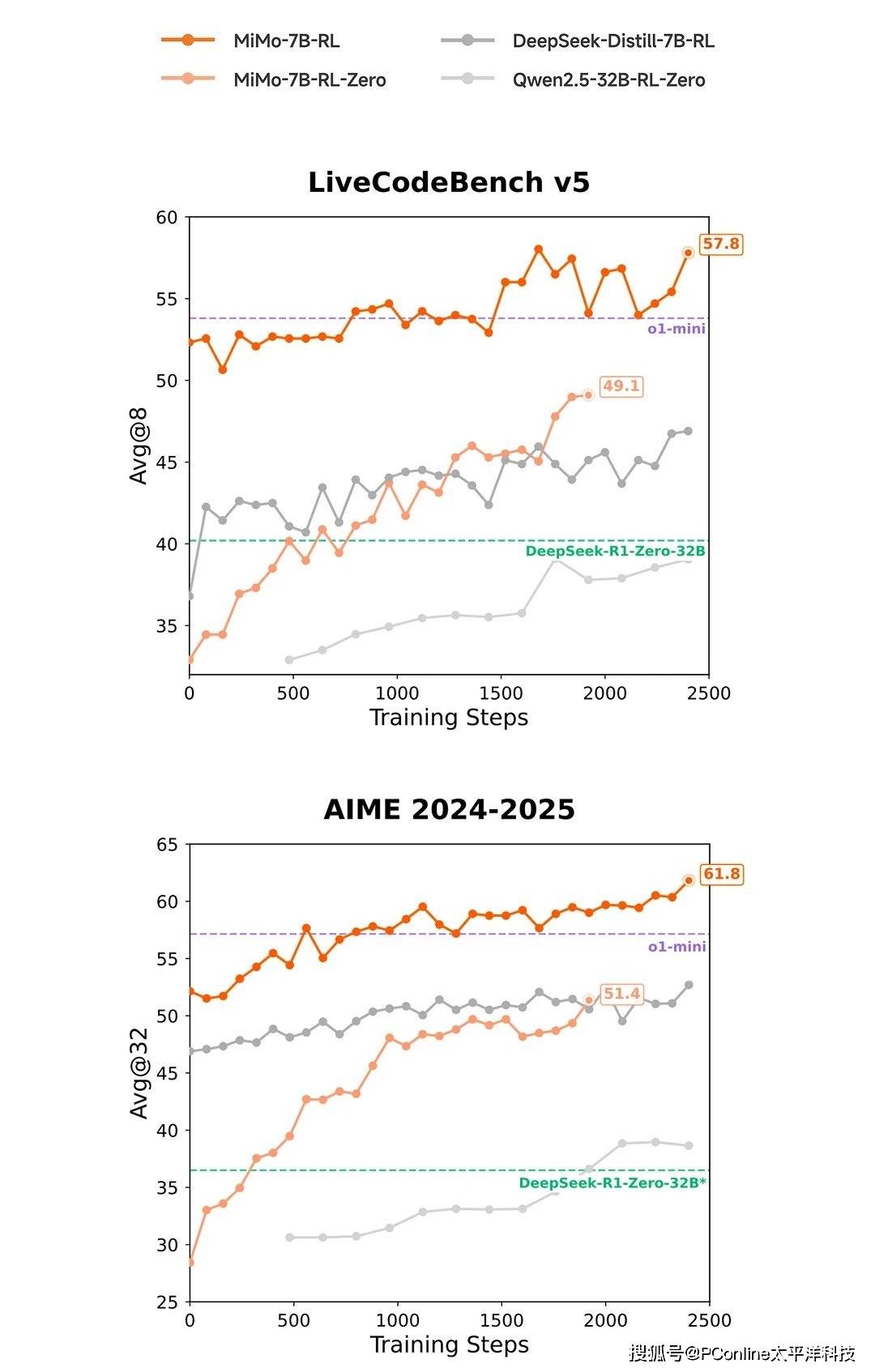

在基准测试方面,MiMo模型展现出了令人瞩目的表现。小米公布的测试数据显示,其7B参数的MiMo模型在多个衡量模型推理能力的公开基准测试中,性能超越了同类甚至更大规模的模型。特别是在AIME 24-25评测集和LiveCodeBench v5评测集上,MiMo的表现不仅超过了OpenAI的闭源推理模型o1-mini,还超越了参数量高达32B的阿里开源推理模型QwQ-32B-Preview。

MiMo模型在强化学习领域也展现出了显著的优势。与当前业内广泛用作强化学习起始模型的DeepSeek-R1-Distill-7B和Qwen2.5-32B相比,MiMo-7B在数学与代码领域的强化学习潜力评估中表现更优。这一成果进一步证明了MiMo模型在推理效率和效果上的行业领先地位。

那么,MiMo模型是如何在推理能力上取得如此突破的呢?这得益于小米大模型Core团队在模型设计与训练流程上的多项技术创新。在预训练阶段,团队着重挖掘富推理语料,并创新性地合成了约200B tokens的高质量推理数据,采用三阶段训练模式,逐步提升难度,累计训练数据量达到25T tokens。

在后训练阶段,小米团队引入了创新的强化学习算法和框架。他们提出了Test Difficulty Driven Reward机制,旨在缓解困难推理问题中的奖励稀疏性,并引入Easy Data Re-Sampling策略以提高训练稳定性。同时,通过设计的Seamless Rollout系统,显著提升了强化学习训练效率和验证效率。

为推动人工智能社区在推理能力方向的共同发展,小米已将Xiaomi MiMo-7B的四个变体模型全部开源,并托管于HuggingFace平台。这一举措使得全球的开发者和研究人员能够免费获取并使用这些模型,进一步促进了人工智能技术的创新和发展。

据了解,Xiaomi MiMo是小米新近成立的「小米大模型Core团队」的首个重要对外成果。该团队表示,将继续秉持务实创新的精神,探索人工智能的前沿领域,致力于通过技术突破不断拓展智能的边界。这一成果不仅展示了小米在人工智能领域的实力,也为全球开发者提供了宝贵的研究资源。