近日,DeepSeek在其官方交流渠道宣布,其R1模型已经完成了小版本的迭代升级,并邀请用户通过官方网站、App及小程序进行测试,同时确认API接口及使用方法维持原样,未做变动。

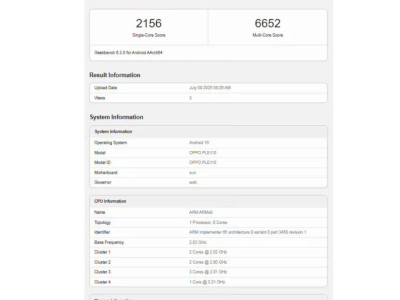

此次升级后的R1模型,DeepSeek团队已在Hugging Face开发者平台上架了新版本(命名为DeepSeek-R1-0528),参数规模从原先的671B增加至685B。值得注意的是,Hugging Face平台上的存储库仅包含了模型的配置文件及权重,而缺少了模型的详细描述。

尽管DeepSeek官方未透露此次升级的具体细节,但新版本App的更新说明中简要提及了“修复部分已知问题”。然而,这并未阻挡用户们对新版本的热情探索。

众多用户在第一时间体验了升级后的R1模型,并反馈称其在思维链(CoT)方面的表现有了显著提升,能够持续进行长达30至60分钟的深度思考,且响应速度更快。特别是在代码生成能力上,用户们普遍认为DeepSeek R1已经跃升至国际领先水平,能够一次性生成可运行且结构清晰的代码,甚至在某些方面与Claude 4模型相媲美。

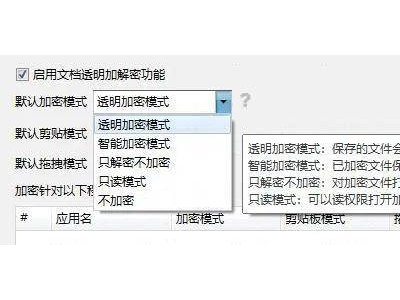

相较于Claude模型,DeepSeek R1的调用成本更为亲民,仅为前者的三分之一,这对于中小开发者而言无疑是个好消息。使用DeepSeek R1无需翻墙,本地服务器响应稳定,极大地简化了网络配置过程。

用户们纷纷展示了使用新版本R1模型完成的各种任务,包括制作天气卡片、设计世界时钟面板等,均取得了令人满意的成果。TechWeb也尝试了请DeepSeek R1设计一个“端午节赛龙舟小游戏”,结果令人惊喜,短短两分钟内便完成了游戏设计。

然而,尽管DeepSeek R1在深度思考和代码生成方面表现出色,但在写作方面仍存在一些问题,尤其是AI幻觉现象依旧不容忽视。有用户在撰写论文时发现,尽管模型能够基于真实材料进行分析,并标注引用源,但仍会捏造数据,导致信息失真。

例如,有用户在使用新版本R1时发现,尽管信息源明确标注了论文的发表年份为2024年,但在信息整理过程中却被错误地标注为“2025年”。这可能是由于提示词对AI产生了误导,使其倾向于迎合用户期望,即使这与参考资料相悖。

因此,尽管DeepSeek R1的升级为程序员们带来了福音,但码字人员在使用时仍需谨慎核查AI生成的内容,以免被其一本正经的胡说八道所误导。