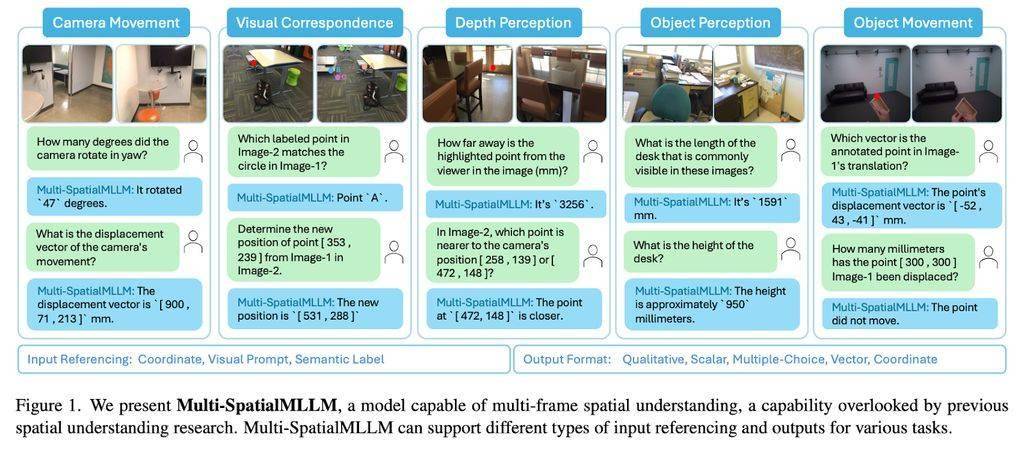

近日,科技界传来一项重要进展,meta公司与香港中文大学携手,在人工智能领域迈出了关键一步。他们共同推出的Multi-SpatialMLLM模型,实现了对深度感知、视觉对应和动态感知三大功能的整合,打破了单帧图像分析的局限性。

近年来,多模态大语言模型(MLLMs)在视觉任务处理方面取得了显著成果。然而,作为独立的数字实体,MLLMs的实际应用却受到了一定限制。随着机器人、自动驾驶等领域的快速发展,对MLLMs的空间理解能力提出了更高要求。但遗憾的是,现有的模型在基础空间推理任务中表现并不理想,例如,它们常常无法准确区分左右。

针对这一难题,meta旗下的FAIR团队与香港中文大学展开了深入研究。他们发现,过去的研究往往将问题归咎于缺乏专门的训练数据,并试图通过单张图像的空间数据进行改进。然而,这种方法只能局限于静态视角的分析,缺乏动态信息处理的能力。

为了解决这个问题,FAIR团队与香港中文大学联合推出了MultiSPA数据集。这个数据集包含了超过2700万个样本,涉及多样化的3D和4D场景,为MLLMs的训练提供了丰富的资源。MultiSPA数据集结合了Aria Digital Twin、Panoptic Studio等高质量标注场景数据,并通过GPT-4o生成了多样化的任务模板,从而确保了数据的全面性和多样性。

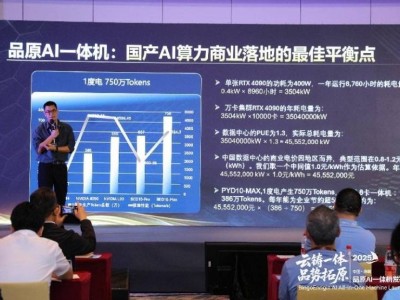

在MultiSPA数据集的基础上,研究团队设计了五个训练任务,包括深度感知、相机移动感知、物体大小感知等。这些任务旨在提升Multi-SpatialMLLM模型在多帧空间推理上的能力,使其能够更好地理解和处理复杂的空间信息。

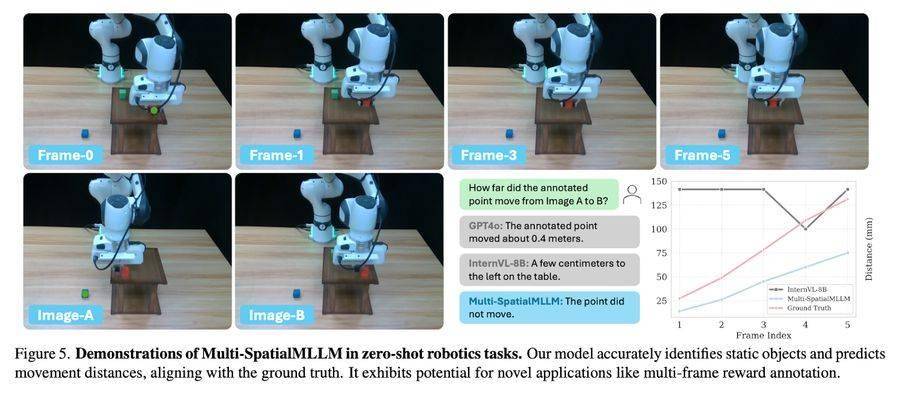

经过严格的测试和评估,Multi-SpatialMLLM模型展现出了卓越的性能。在MultiSPA基准测试中,该模型相比基础模型平均提升了36%,在定性任务上的准确率达到80%-90%,远超基础模型的50%。甚至在预测相机移动向量等高难度任务上,该模型也取得了18%的准确率。在BLINK基准测试中,Multi-SpatialMLLM模型的准确率接近90%,平均提升26.4%,超越了多个专有系统。

Multi-SpatialMLLM模型在保持原有性能的同时,还展现出了不依赖过度拟合空间推理任务的通用能力。在标准视觉问答(VQA)测试中,该模型依然保持了出色的表现。这一成果不仅为MLLMs在空间理解方面的发展提供了新的思路和方法,也为机器人、自动驾驶等领域的未来发展奠定了坚实的基础。