通义实验室的自然语言智能团队近期宣布了一项重大突破,他们成功研发并开源了名为VRAG-RL的多模态推理框架。这一创新框架专为解决真实业务场景中,AI如何从多样化的视觉语言中提取关键信息并进行精确推理而设计。

在AI领域,从复杂的视觉文档知识库中检索并推理关键信息一直是个难题。传统的检索增强型生成(RAG)方法在处理富含视觉信息的内容时表现欠佳,尤其是面对图像、图表等复杂视觉元素时更是力不从心。现有的视觉RAG方法受限于固定的检索-生成流程,难以深度挖掘视觉信息中的核心知识。

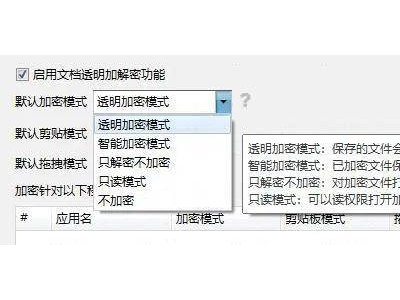

为了克服这些挑战,VRAG-RL框架在多个维度上实现了创新。首先,它通过强化学习训练多模态智能体,引入了多种视觉感知动作,如区域选择、裁剪和缩放等。这些动作使模型能够从宏观到微观逐步聚焦信息密集区域,精确捕捉关键视觉信息,从而提高了对视觉信息的理解能力和检索效率。

在训练策略上,VRAG-RL采用了多专家采样方法,结合大规模模型的推理能力和专家模型的精确标注,使模型能够学习到更高效的视觉感知策略。同时,该框架还引入了一种细粒度的奖励机制,综合考虑检索效率、模式一致性和生成质量,引导模型在与搜索引擎的交互中不断优化检索与推理路径,实现了检索与推理的双向驱动和闭环优化。

VRAG-RL还引入了业界前沿的GRPO算法,通过本地部署搜索引擎模拟真实应用场景,实现了搜索引擎调用的零成本,极大地提高了模型训练的效率和泛化能力。这使得VRAG-RL能够在不同领域和不同类型的视觉任务中均表现出色。

实验数据表明,VRAG-RL在多个视觉语言基准数据集上的性能表现均显著优于现有方法。它涵盖了从单跳到多跳推理、从纯文本理解到图表识别和复杂布局解析等多种视觉丰富场景。无论是传统的基于提示(prompt-based)方法还是基于强化学习的方法,VRAG-RL都展现出了更为卓越的综合性能。

VRAG-RL还支持多轮交互,能够在推理阶段逐步聚焦于信息密集区域,实现从宏观到微观的信息获取。通过优化检索效率和推理路径,VRAG-RL在保持高效率的同时,显著提升了模型在视觉任务上的性能表现。

对于感兴趣的开发者而言,VRAG-RL的开源代码可在Github上找到,地址为github.com/Alibaba-NLP/VRAG。这一创新成果无疑将为AI领域的发展注入新的活力。