随着人工智能技术的飞速发展,其与终端设备的融合正成为行业的新趋势。这一趋势不仅革新了用户交互方式,提升了智能体验,还确保了数据的本地化安全。AI手机、AI个人电脑、智能机器人等新型终端设备如雨后春笋般涌现,标志着AI技术正逐步渗透至我们生活的每一个角落。

然而,AI技术在终端设备上的应用并非一帆风顺。算力受限、隐私安全挑战、响应稳定性不足以及高昂的成本和效率问题,成为了制约AI入端的关键因素。在此背景下,端侧操作系统凭借其轻量化、实时响应、低功耗和高安全性等优势,成为了连接物理设备与云端服务的桥梁,为AI与终端的融合提供了核心载体。

开源鸿蒙,作为面向万物互联时代的智能终端操作系统根社区,正积极拥抱这一变革。它以“AI原生操作系统”为目标,致力于构建涵盖中小模型部署、大语言模型融合、芯片适配与模型加速、智能体理解与应用的全栈AI端侧能力体系。这一体系的建立,旨在推动AI技术在终端设备的规模化普及,为用户提供更加高效、可控和普惠的智能体验。

在中小模型部署方面,开源鸿蒙通过MindSpore Lite Kit支持了包括语音识别、文本转语音、计算机视觉在内的多种模型推理。同时,它还打通了PyTorch、ONNX等模型转换流程,适配了CPU、GPU、NPU等异构计算硬件,实现了跨芯片部署与高性能运行。在TTS领域,开源鸿蒙已支持Fastspeech2、MelGAN等模型的端侧压缩与本地语音合成;在CV领域,YoloV5等模型也在端侧实现了完整推理链路。

在大模型探索领域,开源鸿蒙同样取得了显著进展。它与生态伙伴联合创新,成功适配了TinyDongni和DeepSeek R1等大模型。通过自研的Dongni-AMDC算法,这些模型在内存占用和推理速度上得到了大幅提升。同时,结合本地编译优化、多芯片协同并行推理、NPU加速、内存按需加载等技术,大模型得以在手机等终端设备上实现落地。

在芯片适配与算力支持方面,开源鸿蒙已成功适配了多款芯片,并构建了覆盖CPU、GPU、NPU的异构推理体系。通过引入MindSpore Lite、NNRT和AI插件引擎,它实现了模型与芯片的快速适配与高效运行,支持多模态AI任务如图像识别、语音交互和大模型本地推理。

为了加速AI端侧能力的构建,开源鸿蒙还成立了AI Model SIG,旨在汇聚大中小模型资源,构建端到端应用范例,降低AI能力向端侧落地的技术门槛。目前,已有多家成员单位共同参与,推动开源鸿蒙AI能力的共建。

在模型部署到系统后,如何让这些模型真正发挥作用,开发出解决用户实际问题的智能体,成为了开源鸿蒙关注的重点。为此,它正联合头部高校加速构建面向智能终端的原生智能体体系,推动操作系统从被动响应走向智能理解与主动服务。上海交通大学通过引入“经验驱动”的Record & Replay范式,让智能体能够记录用户行为并复用经验,实现了复杂任务的自动化执行。

在应用场景方面,开源鸿蒙正加速将自身AI能力体系赋能硬件,并落地了一系列AI终端产品。这些产品涵盖了AI机器人、AI个人电脑、AI试验箱等多个领域,助推了AI终端的规模化普及。在AI机器人层面,开源鸿蒙计划筹建机器人PMC,致力于构建一套完整全栈式的机器人系统能力,以适应不同形态机器人的需求。

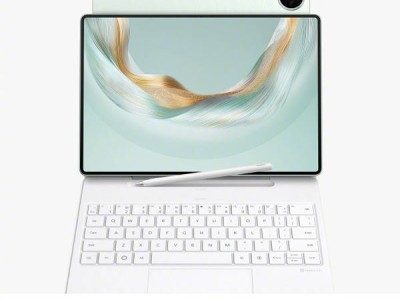

在AI个人电脑领域,华为近期发布的鸿蒙电脑搭载了基于开源鸿蒙的HarmonyOS 5,内置全新小艺AI助手。这一创新为用户带来了全新交互、高效办公、知识空间、设备操控等AI智慧体验。深开鸿的开鸿BotBook笔记本电脑也搭载了基于开源鸿蒙的桌面操作系统,提供了行业智能支持和原生AI智能助理。

开鸿智谷基于开源鸿蒙开发的“在鸿OS 人工智能实验箱”实践平台已在人才培养领域实现应用。它支持DeepSeek模型的本地部署与多轮对话,具备语音输入、联网搜索等能力,广泛应用于AI对话、执行控制等典型场景。

开源鸿蒙正以全栈化的AI能力和多样化的终端应用,推动“端侧操作系统+AI”从理念走向实践。它不仅为用户提供了更加智能、便捷的体验,还为产业的智能化转型升级注入了新的活力。