近日,全球视觉AI领域的年度盛会CVPR 2025在美国田纳西州纳什维尔召开,快手可灵AI事业部万鹏飞博士在备受瞩目的“From Video Generation to World Model” Tutorial(《从视频生成到世界模型》专题讲座)上,发表了题为An Introduction to Kling and Our Research towards More Powerful Video Genaration Models的报告,从模型架构与生成算法、互动与可控能力、效果评估与对齐机制、多模态理解和推理四大技术方向介绍了可灵AI团队在视频生成及世界模型领域的最新进展与思考。

先进的模型结构与生成算法(Advanced Model Architectures and Generation Algorithms)

Scaling laws在大语言模型中已经有众多研究工作和实际应用,但视频生成领域缺乏精准好用的scaling laws公式。可灵团队通过严谨的实验与分析,首次建立了超参数、模型规模与计算预算之间的精确数学关系。这个成果让我们可以更科学地设置模型参数规模和关键参数,从而更充分的发挥算力和数据资源的价值,达成更优的模型效果。参考论文:Towards Precise Scaling Laws For Video Diffusion Transformers

可灵团队还推出了面向扩散模型的混合专家(MoE)架构DiffMoE。基于全局范围的token选择机制和配套的推理策略,DiffMoE可根据扩散模型在不同生成阶段的异构特性,更合理地分配计算资源。在图像生成中,仅需激活1倍的参数量,便能达到3倍规模的密集模型的生成性能。参考论文:DiffMoE: Dynamic Token Selection For Scalable Diffusion Transformers

强大的交互与可控能力(Powerful Interaction and Control Capacities)

可灵团队提出了一个多任务视频生成模型框架FullDiT,将所有时空条件作为上下文无缝融合到一个统一的Diffusion Transformer架构中。FullDiT不需要针对不同任务更改模型结构,降低了各种不同控制条件之间的冲突,且展示出了优秀的可扩展性甚至涌现能力。参考论文:FullDiT: Multi-Task Video Generative Foundation Model with Full Attention

在交互式视频生成方向,可灵团队提出了GameFactory框架,只需少量带有动作控制信息的视频训练数据,即可支持可泛化到不同游戏场景的连续(如鼠标)和离散(如键盘)的动作控制能力。参考论文:GameFactory: Creating New Games with Generative Interactive Videos

准确的评估和对齐机制(Accurate evaluation and Alignment Mechanisms)

可灵团队构建了一套基于人类反馈的强化学习(RLHF)的视频生成框架,包括多维偏好数据构造、基于VLM的Reward模型,以及多种对齐算法。该框架是最早的系统性阐述如何应用RLHF到视频生成任务的工作之一。参考论文:Improving Video Generation with Human Feedback

此外,面向图像和视频生成领域主流的流匹配(Flow Matching)生成算法,团队通过ODE-to-SDE(常微分方程转换到对应的随机微分方程)等方案,有效解决了流匹配缺乏随机性以及多步生成计算效率低的问题,提出了首个将GRPO引入流匹配模型的在线强化学习(RL)算法Flow-GRPO,并证明了其在图像生成任务中的有效性。参考论文:Flow-GRPO: Training Flow Matching Models via Online RL

多模态感知与推理(Multimodal Perception and Reasoning)

视频captioner(视频内容的文本描述模型)对最终的视频生成效果非常关键,但行业中缺乏好的效果评估的方法。可灵团队提出一个视频captioner评估框架VideoCapBench,具备稳定性和可靠性更高、以及与最终视频生成效果相关性强的优点。参考论文: VidCapBench: A Comprehensive Benchmark of Video Captioning for Controllable Text-to-Video Generation

面向用户意图理解,可灵团队提出的Any2Caption按照一种统一的方式理解多模态用户输入信息,进而生成语义丰富的结构化描述,可显著提升视频生成的成功率。参考论文:Any2Caption: Interpreting Any Condition to Caption for Controllable Video Generation

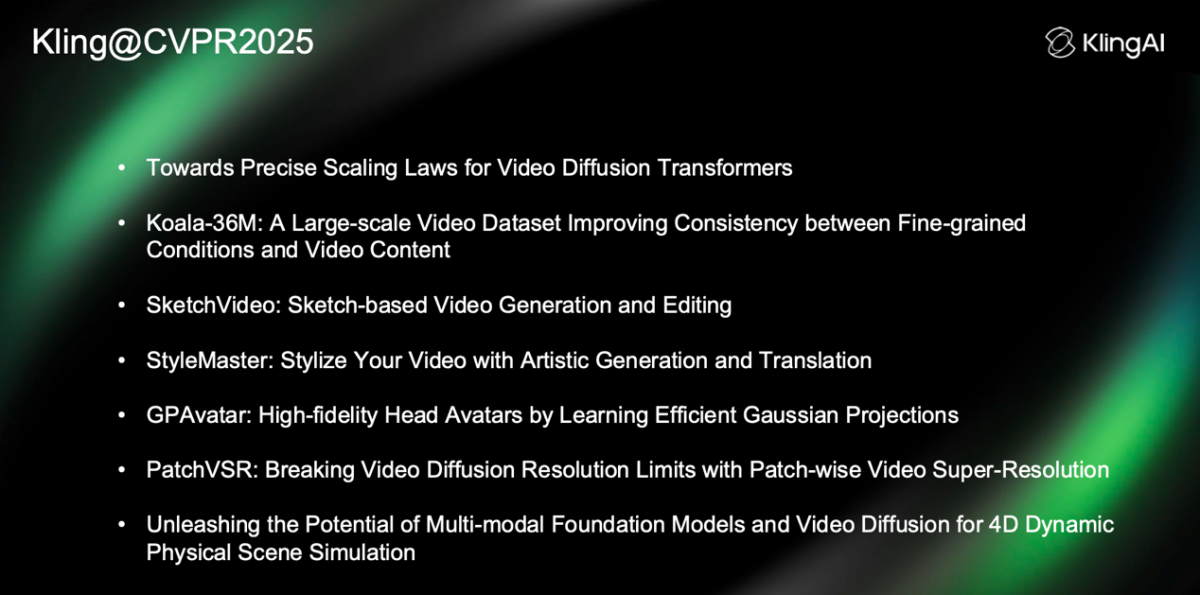

除tutorial报告外,本届CVPR上可灵共有7篇论文入选,涵盖视频模型scaling law、视频数据集、可控生成、人像生成、高清生成、4D生成等多个方向。