在上海浦东张江科学会堂,一场聚焦于人工智能前沿技术的盛会——智谱开放平台产业生态大会圆满举行。会上,智谱公司揭晓了一项重大科研成果:新一代视觉语言模型GLM-4.1V-Thinking正式面世,并向全球开发者开源。

此次大会不仅见证了GLM-4.1V-Thinking的发布,还传来了一则融资喜讯。智谱公司宣布成功获得浦东创投集团与张江集团联合投资的10亿元人民币战略资金,首笔资金交割已顺利完成。同时,三方携手启动了共建人工智能新型基础设施的合作项目,标志着智谱在人工智能领域迈出了坚实的一步。

GLM-4.1V-Thinking,作为智谱公司倾力打造的视觉语言大模型,具备处理图像、视频、文档等多模态输入的能力,专为应对复杂认知任务而生。该模型在GLM-4V架构的基础上,创新性引入了“思维链推理机制”,结合“课程采样强化学习策略”,显著提升了跨模态因果推理的准确性和稳定性。

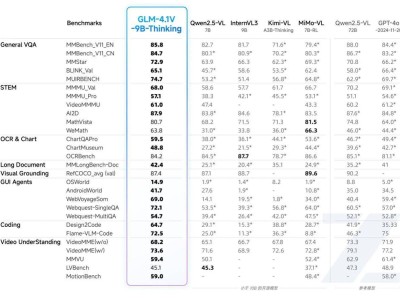

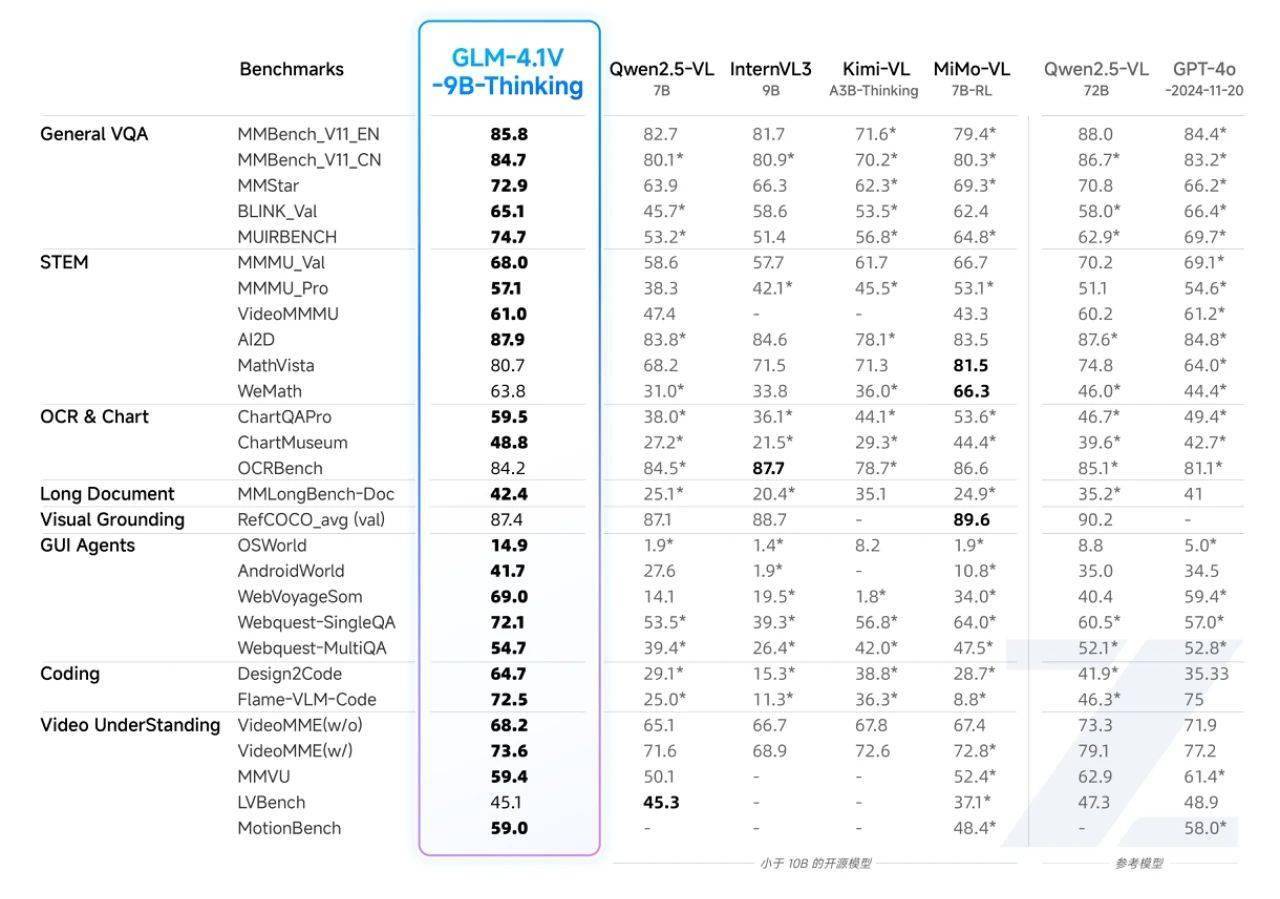

尤为GLM-4.1V-Thinking的轻量版——GLM-4.1V-9B-Thinking,在保持模型体积小巧的同时,展现出了惊人的性能。其参数规模控制在10B级别,却在28项权威评测中取得了23项10B级模型的最佳成绩,其中18项甚至超越了参数量高达72B的Qwen-2.5-VL模型。这一成就,无疑证明了小体积模型在极限性能方面的巨大潜力。

GLM-4.1V-9B-Thinking在多个应用场景中均表现出色,彰显了其高度的通用性和稳健性。在图文理解方面,它能够精准识别并综合分析图像与文本信息;在数学与科学推理领域,它支持复杂题解、多步演绎与公式理解;在视频理解方面,它具备时序分析与事件逻辑建模能力;在GUI与网页智能体任务中,它能理解界面结构,辅助自动化操作;在视觉锚定与实体定位方面,它实现了语言与图像区域的精准对齐,提升了人机交互的可控性。

目前,GLM-4.1V-9B-Thinking已在Hugging Face与魔搭社区同步开源,包括GLM-4.1V-9B-Base基座模型和具备深度思考与推理能力的GLM-4.1V-9B-Thinking模型。这一举措旨在帮助更多研究者探索视觉语言模型的能力边界,推动人工智能技术的创新与发展。