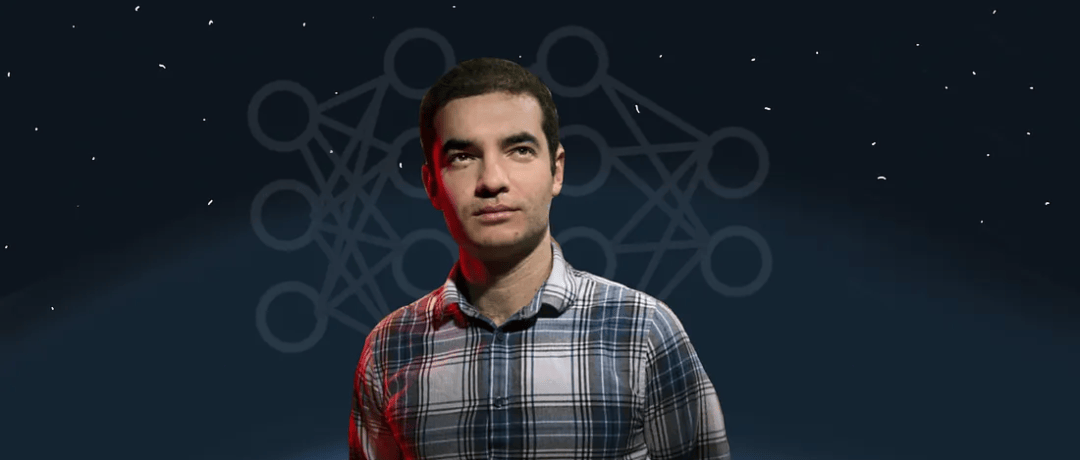

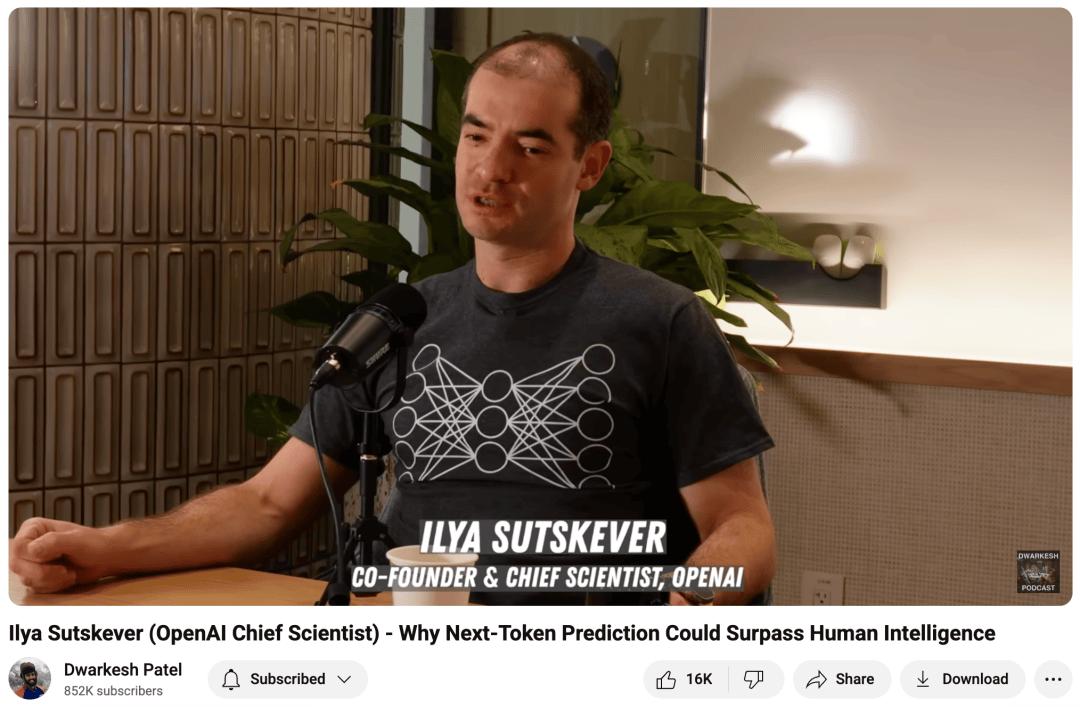

在人工智能领域,总有一些名字因其远见卓识而被铭记。Ilya Sutskever,这位深度学习的先驱,早在ChatGPT和Transformer风靡全球之前,就已洞察到这一技术的无限潜力。近日,一段来自2015年的访谈音频重新浮出水面,让我们得以窥见Ilya当年对深度学习的深刻见解。

Ilya Sutskever,一个在数学与人工智能间架起桥梁的天才,他的故事始于对人工智能的痴迷。在访谈中,他回忆起自己年轻时对AI的浓厚兴趣,以及如何通过数学学习,逐渐踏入这一充满未知与挑战的领域。对他而言,机器学习中的归纳推理,如同魔法般难以捉摸,却又令人着迷。

“数学讲究证明,而机器学习却强调归纳。”Ilya这样说道。在他看来,这种从具体到一般的推理方式,与数学的严谨性形成了鲜明对比,却也激发了他探索未知的热情。于是,他踏上了与Jeff Hinton等AI巨擘合作的道路,开始了对深度学习的深入探索。

在访谈中,Ilya分享了自己对深度学习的独到见解。他认为,监督学习是机器学习中最成功的领域之一,其关键在于利用大型数据集和简单的学习算法,找到最佳的神经网络结构。他强调,深度学习之所以有效,是因为它把握住了那些触手可及的低垂果实,而这些机会往往需要人们付出努力去挖掘。

谈及深度学习的核心要素,Ilya提到了数据、通用性和简单的学习算法。在他看来,尽管深度学习模型的目标函数高度非凸,优化过程充满挑战,但经验证明,这些看似简单的启发式优化算法在实际应用中却表现得异常出色。他坦言,我们尚未完全理解其中的原理,但这并不妨碍我们利用这些“够好”的系统创造出惊人的成果。

Ilya还谈到了神经网络初始化的重要性。他指出,初始化的尺度直接决定了模型的可训性。如果随机权重太小,信号在传递过程中会迅速衰减,导致学习算法无法发现输入和输出之间的关联。因此,在实际应用中,我们需要确保初始化的权重足够大,以保证输入的变化能够一路传递到输出层。

这段访谈音频的曝光,让我们再次感受到了Ilya Sutskever的远见卓识。在2015年,当Transformer和ChatGPT还遥不可及的时候,他已经深刻地体会到了神经网络的威力。他的观点,如追求务实、拥抱简单等,至今仍具有极高的指导意义。在这个日新月异的AI时代,让我们铭记Ilya的教诲,继续探索未知,创造未来。