在AI大模型市场的风起云涌中,DeepSeek R1的横空出世无疑成为了一颗震撼弹,仅仅128天的时间,便深刻改变了行业的格局。

DeepSeek R1的问世,如同一把利剑,直接刺破了推理模型价格的高墙。OpenAI在六月更新的o3价格,相较于之前的o1,价格直接打了二折,这无疑为整个市场树立了新的价格标杆。

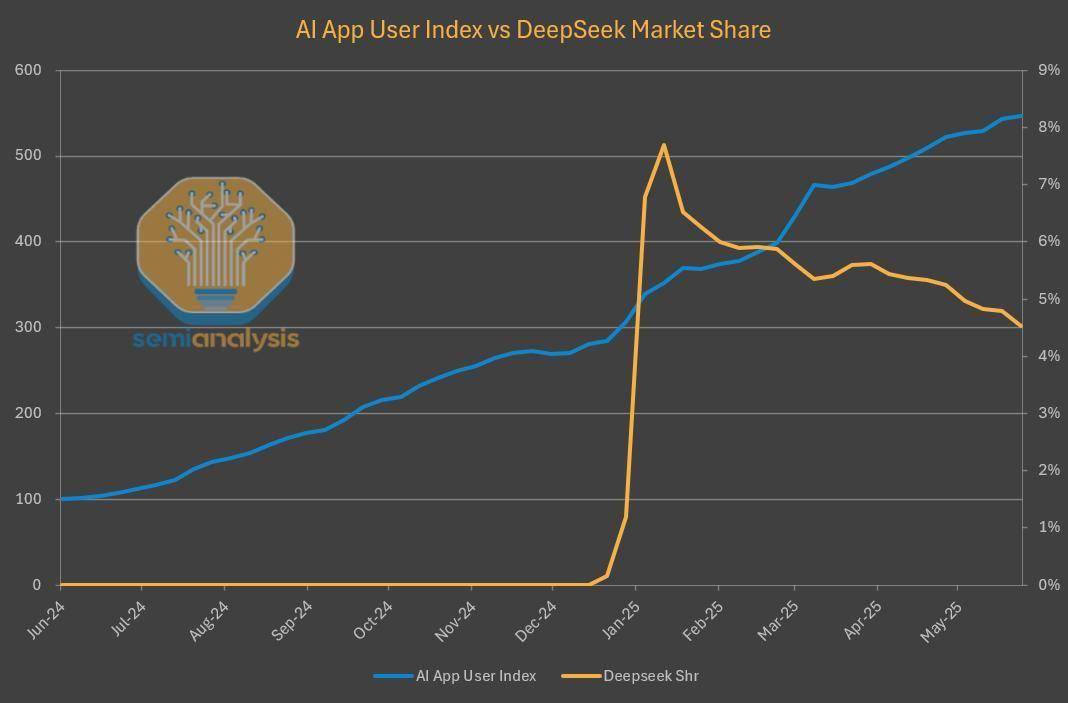

与此同时,第三方平台上DeepSeek模型的使用量呈现爆炸式增长,与刚发布时相比,增长了近20倍,这一趋势不仅推动了AI技术的普及,更为众多云计算厂商带来了前所未有的商业机遇。

然而,令人意外的是,尽管DeepSeek模型在第三方平台上大放异彩,但其自家的网站和API市场份额却出现了下滑,似乎未能跟上AI产品上半年持续增长的步伐。

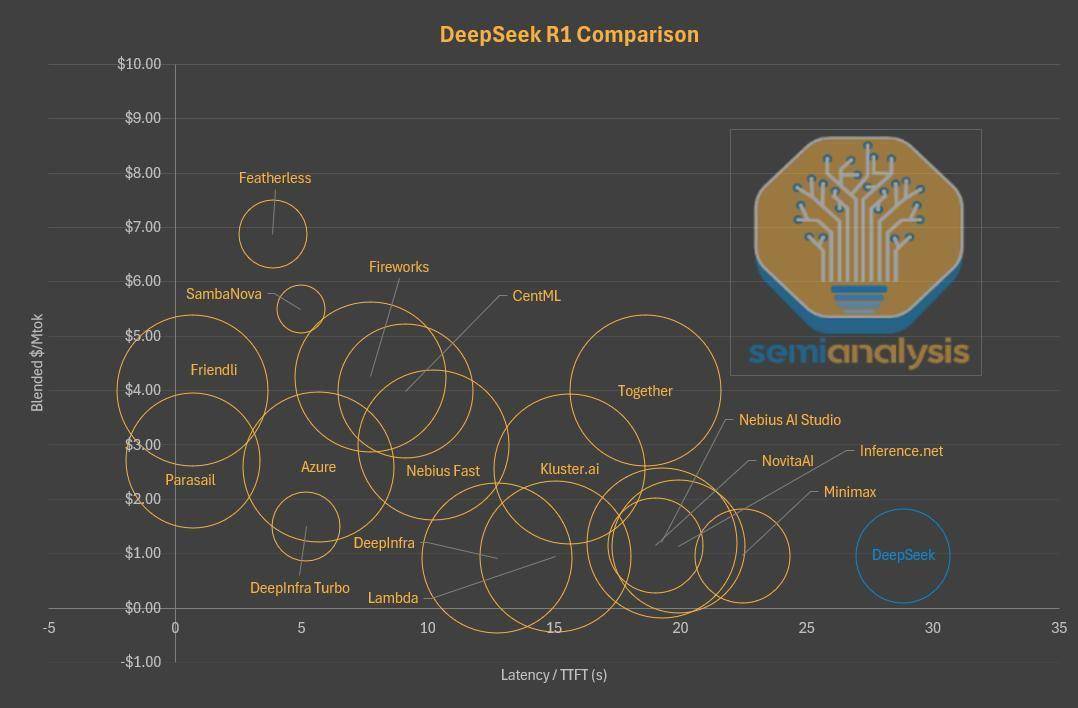

据SemiAnalysis发布的一篇深度报告揭示,DeepSeek之所以能够迅速降低推理模型的价格,背后是其对服务质量的妥协。用户在使用DeepSeek官方平台时,往往需要等待数秒才能看到第一个字符的出现,这一首token延迟的问题,成为了制约其用户体验的关键因素。

相比之下,虽然其他平台的价格普遍更高,但其在响应速度上的优势却显而易见。例如,在Parasail或Friendli等平台,用户只需支付3-4美元,便可享受到几乎零延迟的100万token服务。而微软Azure平台,尽管价格是DeepSeek官方的2.5倍,但其延迟却减少了整整25秒。

DeepSeek在价格与性能之间的权衡也显而易见。在有限的推理计算资源下,DeepSeek只提供了64k的上下文窗口服务,这在主流模型提供商中堪称最小之一。对于需要读取整个代码库的编程场景而言,64k的上下文窗口显然不够用,因此用户更倾向于选择第三方平台。

值得注意的是,DeepSeek的这些降本策略并非偶然,而是其主动做出的决定。DeepSeek目前似乎并不太关注用户体验,也无意通过聊天应用或API服务向用户提供大量token,而是将更多的算力资源投入到内部研发中,以实现其AGI的宏伟目标。

DeepSeek的这一策略,不仅降低了推理服务的成本,还通过开源策略吸引了其他云服务托管其模型,从而赢得了更广泛的影响力并培养了生态。然而,这也使得DeepSeek在用户体验上有所欠缺,尤其是在响应速度和上下文窗口大小等方面。

在DeepSeek的影响下,其他大模型供应商也开始调整策略。例如,Claude为了缓解算力紧张的问题,降低了输出速度,但仍然在努力平衡用户体验。而Claude模型的设计也更加注重生成简洁的回复,以减少token的使用量。

这些迹象表明,大模型供应商正在从多个维度改进模型,不仅追求模型的智能上限,更注重提升每个token所能提供的智能。这一趋势无疑将推动AI技术的进一步发展,为用户带来更加高效、智能的服务。