近期,科技界围绕华为诺亚方舟实验室发布的盘古Pro MoE开源模型展开了一场热烈讨论。这一模型拥有720亿参数,采用混合专家(MoE)架构,专为昇腾硬件平台设计。随后,业界出现了一项对比分析,指出盘古Pro MoE与阿里巴巴的通义千问Qwen-2.5 14B模型在参数结构上存在高度相似性。

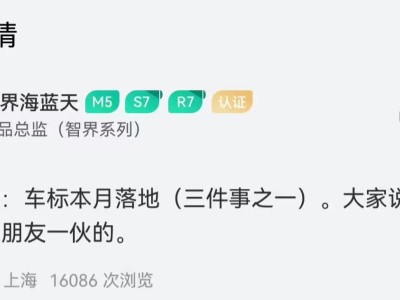

面对这一热议,7月5日,诺亚方舟实验室迅速作出回应。实验室强调,盘古Pro MoE模型是基于昇腾硬件平台独立开发和训练的,并非在其他厂商模型的基础上进行增量训练所得。实验室的这一声明旨在澄清模型的开发背景和独立性。

具体而言,GitHub上的一项研究指出,盘古Pro MoE与通义千问Qwen-2.5模型在注意力参数分布上的平均相关性高达0.927,这一数值远超正常对比范围。对此,诺亚方舟实验室解释称,盘古Pro MoE模型在代码实现过程中确实参考了业界的开源实践,包括其他开源大模型的部分代码。但实验室明确表示,所有开源代码的使用均严格遵循了开源许可证的要求,并在文件中清晰标注了版权信息。

业内分析人士指出,尽管盘古Pro MoE与通义千问Qwen-2.5在参数结构上存在高度相似性,但两者在偏置的绝对数值分布上存在本质差异。这意味着,通过常规的微调或持续预训练,很难将一个模型的状态转变为另一个模型的状态。分析人士认为,这种相似性可能更多地体现在架构设计层面,而非具体的预训练权重。

诺亚方舟实验室进一步强调,盘古Pro MoE模型在架构设计和技术特性上进行了关键创新。作为全球首个面向昇腾硬件平台设计的同规格混合专家模型,盘古Pro MoE创新性地提出了分组混合专家模型(MoGE)架构。这一架构有效解决了大规模分布式训练中的负载均衡难题,显著提升了训练效率。

实验室在回应中还提到,他们始终坚持开放创新的原则,尊重第三方知识产权,并倡导包容、公平、开放、团结和可持续的开源理念。实验室感谢全球开发者与合作伙伴对盘古大模型的关注和支持,并表示将高度重视开源社区的建设性意见。

通过盘古大模型的开源,诺亚方舟实验室希望与志同道合的伙伴共同探索并不断优化模型能力,加速技术突破与产业落地。这一开放合作的态度,无疑为科技界的未来发展注入了新的活力。