人工智能在回答事实性问题时频繁“编造答案”的现象,正通过一项突破性研究迎来转机。由国际科研团队开发的“许可证神谕”系统,通过强制AI在输出答案前完成双重验证,成功将事实性回答的准确率提升至接近完美水平。这项发表在权威学术期刊上的成果,为解决AI“幻觉”问题提供了全新技术路径。

传统AI模型在处理事实查询时,常因架构缺陷产生令人啼笑皆非的错误。例如当被问及某条河流长度时,模型可能自信地报出完全虚构的数字。研究团队通过解剖这类现象发现,问题根源在于变换器架构的“平面语义空间”——模型仅能捕捉词汇间的统计关联,却无法理解“河流必须从高处流向低处”这类基本物理规律。这种认知局限导致AI生成的内容看似合理,实则与现实脱节。

新系统通过构建“证据-验证”双保险机制破解难题。科研人员首先创建包含11.8万条结构化事实的美国河流知识图谱,涵盖长度、流量等21个维度数据。每个数据点都经过交叉验证,例如系统会自动检查河流源头海拔是否高于入海口。当用户提问时,AI需先从图谱中提取相关信息,再通过SHACL约束规则进行逻辑校验——只有同时满足“知识图谱存在该事实”和“不违反物理/地理规律”两个条件的回答,才能获得输出许可。

实验数据印证了该架构的革命性效果。在对比测试中,基础大语言模型对专业领域问题的准确率不足42%,即便经过事实微调的模型也仅达8.5%。更严峻的是,当模型被训练学会说“我不知道”后,其拒绝回答的准确率仍徘徊在56.7%左右。而引入许可证神谕的系统不仅将准确率推高至89.1%,更实现了100%的拒绝可靠性——即系统说“不知道”时必然是超出知识范围,且从未在应拒绝时给出错误答案。

该技术的泛化能力同样令人瞩目。在跨领域测试中,系统处理哲学家影响关系等抽象知识时,准确率与地理领域相差不足0.1%。这得益于其独特的混合架构:RDFLib负责知识图谱操作,pySHACL执行逻辑约束检查,GLiNER模型则从回答中精准提取事实声明。这种将符号推理与神经网络结合的设计,使系统既能理解“科罗拉多河发源于落基山脉”这类具体事实,也能处理“苏格拉底是柏拉图老师”这类抽象关系。

研究团队特别强调认知诚实性指标的创新价值。除传统准确率外,他们引入“虚假答案率”“约束违反拒绝率”等新维度,全面评估系统区分已知与未知的能力。测试显示,系统对逻辑矛盾声明的识别成功率达50%,且所有通过验证的答案均100%正确。这种“宁缺毋滥”的设计哲学,标志着AI从“追求流畅回答”向“确保可靠输出”的根本转变。

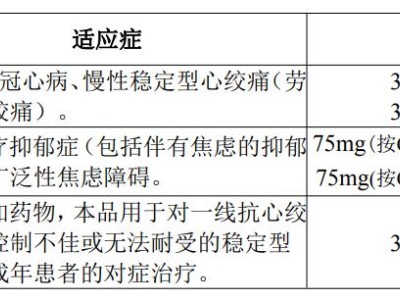

尽管存在知识图谱覆盖度、多步推理能力等局限,该成果已在高风险领域展现应用潜力。在医疗咨询场景中,系统可明确区分“已验证治疗方案”与“研究阶段疗法”;法律文书生成时,能自动标注“依据第X条法规”等溯源信息。这种透明性对需要审计决策过程的关键应用至关重要,为AI伦理建设提供了可操作的技术框架。

科研人员指出,未来改进方向包括扩展动态知识处理能力、优化图谱自动更新机制,以及开发更精细的语义解析工具。当前系统已开放技术文档查询,其核心思想——通过架构创新弥补统计模型的认知缺陷——正启发更多研究者探索可信AI的新范式。对于普通用户而言,这意味着未来的智能助手将更倾向于说“让我查证后回答您”,而非冒险给出可能错误的即时回复。