范式智能首席执行官戴文渊在近期一场行业交流活动中指出,当前中国人工智能应用生态过度依赖国际巨头英伟达的技术体系,国产算力生态建设面临严峻挑战。他透露,公司统计显示其服务的22个行业、数千个AI应用中,超过99%均基于英伟达架构开发,这一现象在中美AI竞争中尤为突出——所谓的中美技术对抗,实质上更多是中国开发者在不同体系下的内部竞争。

"我们既自豪又遗憾,"戴文渊坦言,"自豪于中国AI应用的广泛落地,遗憾的是这些成果都在为他人做嫁衣。"他以手机应用生态作比:若华为手机只能运行50个应用,而苹果手机拥有200万个应用,消费者根本不会考虑性能差异就会直接放弃前者。当前国产GPU生态正面临类似困境,开发者社区规模不足导致用户粘性缺失,形成恶性循环。

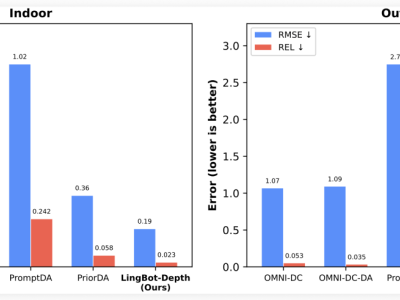

技术差距方面,英伟达CUDA生态拥有约1.8万个算子(计算核心单元),而国产GPU平均仅数百个,核心数量相差达20倍。这种差距直接导致资源利用率失衡:某央企搭建的万卡集群实际利用率极低,单个应用仅能消耗万分之一的算力资源。戴文渊强调,绝大多数商业开发者更需要"单卡运行万模型"的解决方案,而非盲目追求集群规模。

市场现状显示,国产GPU销量增长主要源于安全需求而非性价比优势。企业采购多作为英伟达产品的替代方案,而非基于性能价格比的选择。戴文渊认为,这种被动局面必须改变:"美国的技术优势也是华人创造的,中国开发者完全有能力构建自主生态。"

针对这些痛点,范式智能推出信创魔盒Model Hub XC平台,致力于打造全球最大的国产大模型社区。该平台自去年9月上线以来,模型数量从零增长至1.2万个,上周单周新增2500个模型。戴文渊预计,按当前增速,今年模型数量将突破10万,与英伟达生态的差距缩小至一个数量级。

在技术支撑层面,公司开发的Honey社区VGPU平台已实现异构计算支持,可兼容英伟达及多家国产GPU。这项技术使单物理卡可虚拟为多个逻辑卡,显著提升资源利用率。新推出的Fancy Cloud云服务整合了VGPU技术、开发平台及信创魔盒,目前可提供上万个国产模型调用,计划年内将模型数量提升至10万级。

垂直领域布局方面,范式智能基于十多年行业经验,已在二十多个领域构建近万个专业模型。戴文渊特别指出,通用大模型在专业场景存在局限,如OpenAI去年关闭财务、医疗等专业问答服务,印证了垂直模型的重要性。Fancy Cloud将集成这些专业能力,为企业提供开箱即用的解决方案。

在算力成本方面,戴文渊对国产GPU性价比提升充满期待。随着曦望科技发布启望S3芯片及百万token一分钱的算力计划,他认为国产算力有望打破价格壁垒。"我们不仅要解决安全问题,更要让中国算力成为全球最便宜的选择,"他表示,"通过与曦望合作打造Fancy Cloud,我们将共同为全球市场提供高性价比的算力服务。"