在新加坡国立大学与新加坡海AI实验室的联合研究中,一项名为“按需通信”(On-Demand Communication,ODC)的技术为分布式人工智能训练领域带来了突破性进展。该成果发表于国际学习表征会议(ICLR),论文编号arXiv:2601.19362v1,为解决大语言模型训练中的效率瓶颈提供了全新思路。

传统训练模式如同集体舞蹈,所有设备必须严格同步完成每个计算步骤。当处理长短不一的文本序列时,这种“齐步走”的方式导致严重资源浪费——处理短文本的设备常需等待处理长文档的设备,时间损耗最高可达50%。以训练ChatGPT类模型为例,不同设备分配到的文本长度差异可达数千倍,这种不均衡性在模型规模扩大后愈发显著。

研究团队将目光投向十年前被淘汰的“参数服务器”架构,通过创新性改造使其焕发新生。ODC系统让每个计算设备兼具“数据请求者”和“参数提供者”双重身份,形成点对点的动态通信网络。当设备需要参数时,可直接从持有该参数的设备获取;计算完成后,梯度更新也通过直接通信完成,彻底打破传统同步限制。这种设计既保留了现代分布式训练的内存效率,又引入了异步计算的灵活性。

技术实现层面,研究团队攻克了三大核心挑战。针对点对点通信可能增加的网络负载,他们通过计算-通信重叠技术,利用长文本计算时间长掩盖通信开销。对于梯度更新的竞争条件,开发了基于Triton-Distributed的轻量级后台守护程序,实现无阻塞的参数更新。在负载均衡方面,采用Karmarkar-Karp算法进行动态任务分配,允许设备处理不同数量的微批次,就像让“大胃王”和“小食量者”按需分配工作量。

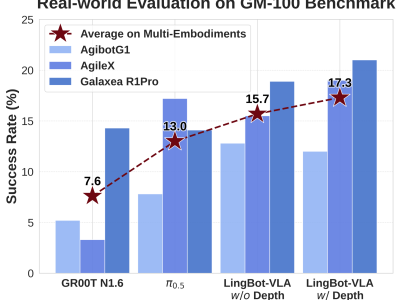

实验数据验证了ODC的显著优势。在包含6.4万token超长文本的训练场景中,该技术实现36%的速度提升;处理平均3.4万token的软件工程任务时,320亿参数模型的设备利用率从60%提升至80%;即便在文本长度相对均衡的数学推理任务中,仍带来10%的性能优化。特别值得注意的是,ODC的优势随文本长度差异和设备数量增加而扩大,在跨节点训练中展现出强大扩展性。

为降低技术门槛,研究团队已将完整代码开源。开发者只需替换原有通信模块,在训练批次结束时获取累积梯度即可完成集成,无需重构现有训练流程。这种“即插即用”的设计,使得使用PyTorch FSDP框架的团队都能快速应用该技术。实际测试表明,在16卡GPU集群上训练长文本模型时,ODC可减少约1.2万小时的无效等待时间。

该成果引发行业深度思考。传统评估体系过度关注理论峰值吞吐量,而ODC的成功证明实际设备利用率才是关键指标。这种理念转变正在推动AI基础设施设计革新——未来的芯片和系统可能更侧重优化点对点通信能力,而非单纯提升集体通信带宽。研究团队特别指出,ODC在短文本均匀负载场景下优势减弱,这为后续优化指明了方向。

在开源社区,ODC已获得积极反馈。某大型语言模型开发团队表示,应用该技术后,其微调训练成本降低28%,模型迭代周期缩短近三分之一。这种实质性提升,使得ODC成为应对当前AI训练成本飙升的有效解决方案。随着异步训练思想逐渐被接受,分布式训练领域正迎来新的范式转变。