随着科技行业的快速发展,ASIC(专用集成电路)市场正经历着前所未有的增长浪潮。据摩根士丹利的预测,AI ASIC市场规模将在未来几年内实现显著飞跃,从2024年的120亿美元猛增至2027年的300亿美元,年复合增长率高达34%。这一增速远高于同期高性能计算GPU市场的25%增长率,以及CPU和APU的5%和8%增长率。

驱动这一市场扩张的主要因素之一,是人工智能服务器需求的激增。TrendForce的最新研究报告指出,美国主要的云计算服务提供商(CSP)正在加速内部开发ASIC芯片的步伐,平均每1至2年便推出新一代产品。在中国,面对美国即将实施的新出口管制政策,人工智能服务器市场也在逐步调整,预计进口芯片(如NVIDIA和AMD产品)的市场份额将在2025年降至42%,而中国本土芯片制造商的市场份额则将提升至40%。

定制芯片的选择,对于许多企业而言,不仅是一种技术上的优化,更是一种经济上的考量。面对GPU服务器的算力缺口和部分产品的供应限制,许多头部互联网企业选择增大自研ASIC芯片服务器的部署数量,以降低成本并更好地适配自身业务场景。例如,AWS的Trainium 2 ASIC芯片在同等预算下,比英伟达的H100 GPU更快完成推理任务,性价比提高了30%~40%。而即将推出的Trainium 3,计算性能更是提高了2倍,能效提高40%。

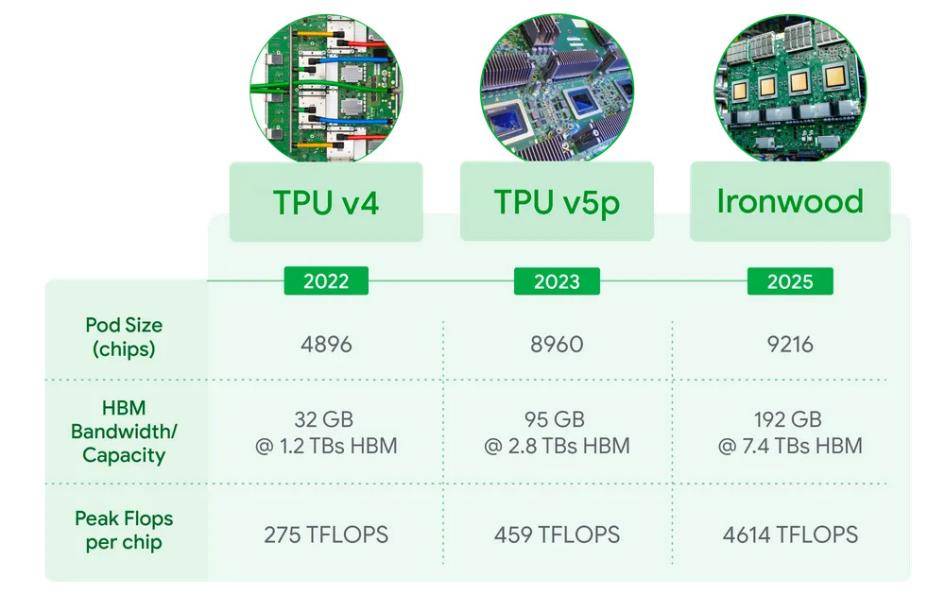

在全球范围内,大型云计算和大模型厂商如谷歌、亚马逊、meta、OpenAI等,都在加速布局定制化ASIC。谷歌的TPU作为ASIC的典型代表,已经从2016年的首款产品发展到今年的第七代Ironwood。这款AI加速器在大规模部署的情况下,计算能力能达到全球最快超级计算机的24倍以上,每块芯片的峰值计算能力可达4614 TFLOPs,配备192GB高带宽内存,内存带宽达到7.2 terabits/s。

在国内,中昊芯英等企业也在积极布局TPU芯片市场。中昊芯英的创始人及CEO曾透露,公司成功实现了全自研的专为AI训练而生的中国首枚高性能TPU训练芯片“刹那”的量产交付。这款芯片在处理大规模AI模型训练和推理任务时,计算性能超越英伟达A100,系统集群性能更是十倍于传统GPU,能耗仅为传统GPU的一半,单位算力成本仅为国外产品的42%。

在市场竞争方面,博通以55%~60%的份额位居ASIC市场第一,Marvell则以13%~15%的份额位列第二。博通的核心优势在于定制化ASIC芯片和高速数据交换芯片,其AI相关收入在2025财年第一季度同比增长77%,占总营收的28%。博通与meta合作开发的第三代MTIA芯片,以及与OpenAI合作的两代ASIC芯片项目,都将成为其未来增长的重要动力。Marvell的定制芯片业务也正成为其强劲增长的核心动力之一,主要来自亚马逊的Trainium 2和谷歌的Axion Arm CPU处理器。

国内企业也在积极研发ASIC。寒武纪科技正在扩展其思元(MLU)芯片系列,以支持云端的AI训练和推理。阿里巴巴推出了含光800云端AI推理芯片,峰值性能为7.8万IPS,峰值能效达到500IPS/W。百度则量产了昆仑芯二代,并宣布使用昆仑芯三代P800构建了首个自研万卡集群,在成本上实现了显著降低。腾讯则通过自主研发和战略投资,推出了紫霄推理芯片,并在多个头部业务中落地应用。

然而,ASIC市场的增长也带来了新的挑战。芯片设计成本不断攀升,尤其是先进芯片设计,已经变得非常昂贵。企业需要认真考虑,是否真的需要自主设计CPU。毕竟,在追求技术自主的同时,也需要权衡成本和效益。