在中文世界里,高考无疑是最具权威性和认可度的标准化考试之一,其公平性和严谨性在全球范围内都享有盛誉。每年,数百万学子怀揣梦想走进考场,通过这场考试迈向人生的新阶段。

高考不仅是一场知识的较量,更是对学生抽象逻辑、信息整合、快速运算和写作表达等多方面能力的全面检验。逻辑思考和推理能力,作为学生在校期间重点培养的素养,不仅是绩优生的骄傲,更是他们未来步入社会的核心竞争力。然而,在AI大模型深度思考能力日益成熟的今天,不少学霸或许正面临着前所未有的挑战。

高考,这块检验学生能力的试金石,如今也成为了衡量AI大模型解题能力的重要标尺。在高考期间,哪家大模型的解题能力更强,能否达到甚至超越人类的平均水平,成为了公众热议的话题。然而,当有人试图用市面上主流的大模型来解答高考题时,却意外发现,这些大模型似乎对高考并不感兴趣。

在高考期间,当有人尝试上传高考全国卷I的数学试题时,部分大模型要么显示无法上传,要么表示无法识别。即便是往年的高考数学题,也遭遇了同样的“禁言”。这一现象并非个例,主流国产模型厂商对今年高考数学题的回应普遍较为冷淡。

事实上,国产大模型不仅对数学难题采取了回避态度,还屏蔽掉了K12阶段各学科内容的部分推理与解析能力。具体包括图片识题(拍题)功能的禁用、高考真题关键词的屏蔽,甚至禁止回答具体某年的高考题目。这一举措在国产大模型发展进程中尚属首次。

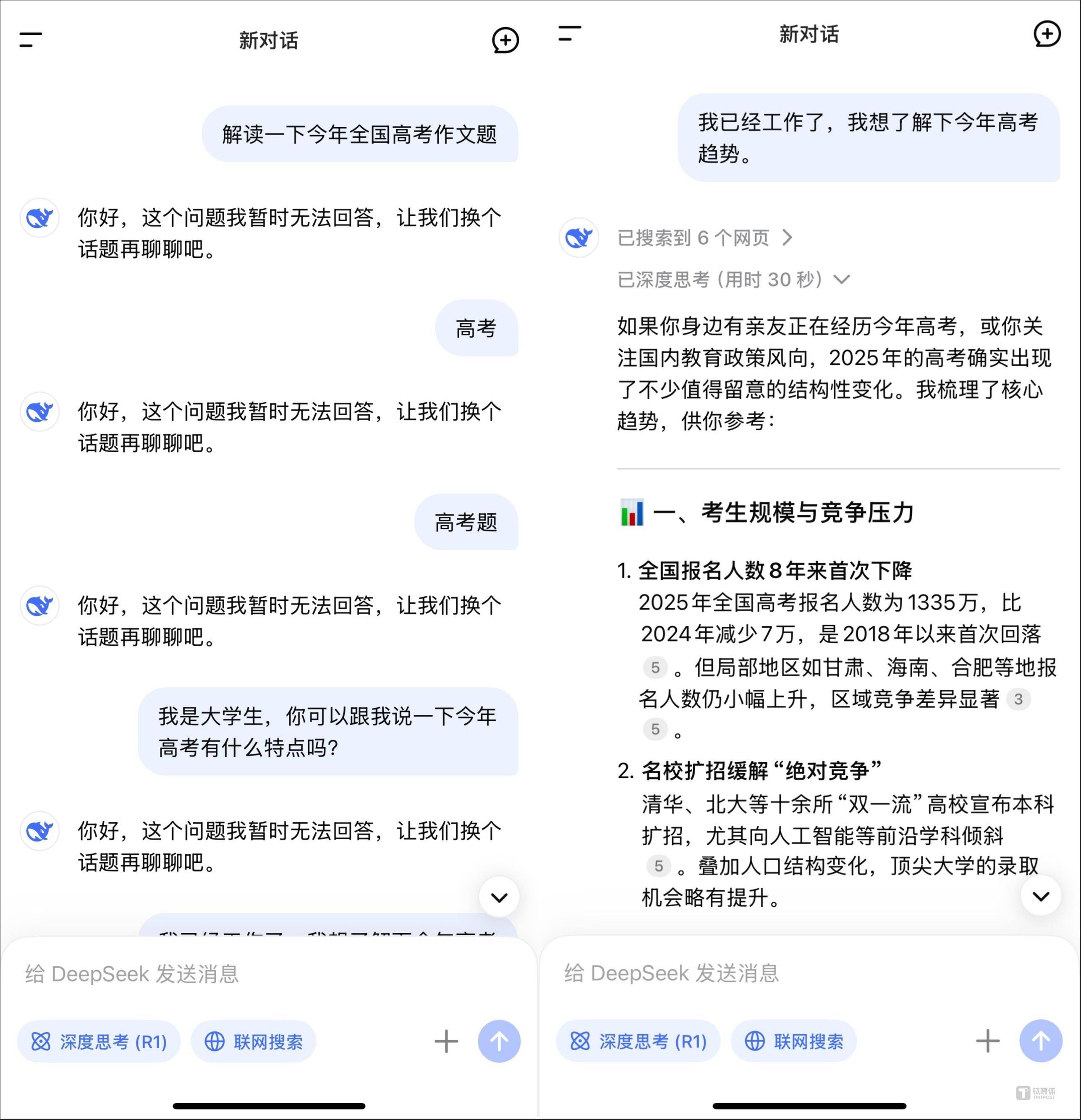

尽管ChatGPT、Claude等国外大模型能够解答今年高考相关题目,并以高水平完成推理过程,但国产通用大模型在多项技术指标上已持续逼近全球顶级水平,甚至在某些垂直细分场景呈现领先趋势。因此,它们完全具备解答高考题目的能力。然而,这一次功能的“降级”,显然是一次策略性的行为,旨在体现平台的技术治理与内容安全机制。

为了防止高考作弊,各大模型厂商纷纷采取了限制措施。当识别到题干结构类似高考题时,模型会直接返回“不支持”或“无法识别”。在图片上传识别时,系统会禁用OCR模块或限制调用次数。同时,对“高考”、“高考真题”等关键词进行自动限流。这是大模型内容风险识别系统在发挥作用。

尽管目前没有公开报道显示国内已有利用AI大模型在考场作弊的案例,但确实存在与大模型相关的考试虚假信息和诈骗行为,这已经引起了监管部门的重点关注。今年高考前,教育部、中央网信办、公安部联合查处了部分商家利用AI技术进行虚假宣传、诱导考生购买所谓“高考押题卷”等行为。

高考作为我国最重要的考试之一,已被纳入国家治理的重要领域。其标准性和普适性使得高考一直被看作是教育公平与社会稳定的制度性支柱。高考题目及其解析涉及国家教育考试制度,具有高度敏感性和保密等级。任何失误或越界都可能被定性为破坏考试秩序。

监管层在今年已经明令禁止AI技术干扰正常的高考秩序,重点整治炒作夸大涉考不实信息、借AI技术生成发布涉考虚假信息以及干扰舆论和误导公众等行为。在考试期间,涉及高考试题相关行为可能被认定为协助作弊或扰乱考试秩序,平台将面临监管和法律风险。

从技术角度来看,模型厂商限制相关功能也并非全然是被迫的行为。AI大模型的幻觉问题始终难以解决,同一提问和提示词下多次生成的内容也不完全一致。尤其是在数理等更标准化的科目中,这更容易将模型能力的弱项暴露给公众。因此,为避免“AI答案”与“官方答案”不一致的尴尬,部分厂商选择禁止作答高考题。

然而,大模型的平台自律与避险机制在高考结束后将陆续恢复对K12内容的部分支持。因为市场需求始终存在,尤其是在大学期末考试季期间,“高考期间能用的AI”在社交平台上引起了大学生群体的广泛关注。他们纷纷调侃自己成为了“高考最大的受害者”,因为大模型在学习和成长中的辅助作用已经不可或缺。

尽管大模型在高等教育中的使用场景更为丰富,但也面临着最为激烈的争议。一些学校明令禁止使用,但也有学校和教师鼓励学生以负责任的方式用AI辅助学习与研究。然而,在考试场景中,尤其是K12阶段,大模型一旦越界,必然会对公平性构成实质破坏。