近期,苹果公司公布了一项关于人工智能(AI)的重要研究,揭示了大型推理模型(LRM)在面对复杂问题时的局限性,这一发现引发了业界的广泛关注。

在这项研究中,苹果科研人员测试了多款前沿的LRM,包括OpenAI的o1与o3、DeepSeek R1、Claude 3.7 Sonnet Thinking以及Google的Gemini Flash Thinking。他们通过一系列经典逻辑谜题来评估这些模型的推理能力,例如河内塔、跳棋问题、过河难题和方块堆叠问题等。

研究结果显示,尽管这些LRM在中等难度的谜题上表现优于传统的大型语言模型(LLM),但在面对简单问题时,它们的表现却不尽如人意。更令人惊讶的是,当问题难度提升时,这些模型不仅无法有效应对,还会出现“完全崩溃”的现象,甚至在解题过程中提前“放弃”。

苹果研究人员指出,尽管LRM在数学和编程任务中展现出了强大的能力,但在面对更加复杂的挑战时,它们只是呈现出了一种“思考的假象”。这一发现无疑给那些期待通用人工智能(AGI)早日实现的人们泼了一盆冷水,同时也让AI怀疑论者看到了希望的曙光。

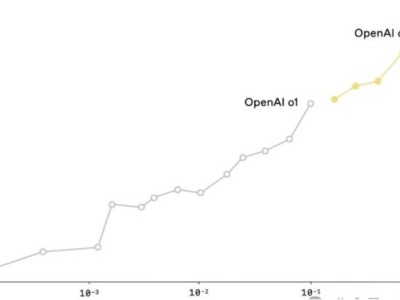

在具体测试过程中,研究人员发现,随着问题难度的增加,这些LRM模型的准确率逐渐下降,最终在各自的临界点完全崩溃,准确率为零。例如,在河内塔问题中,当圆盘数量增加到第五个时,Claude 3.7 Sonnet + Thinking和DeepSeek R1就开始频繁失败。即使增加算力,也无法解决高复杂度的问题。

研究人员还发现,随着问题难度的提升,这些模型在解题初期会投入更多的“思考token”(即推理努力),但接近临界点时,反而会减少“思考”,即token使用量下降。这意味着,面对更难的问题,这些模型反而更快地放弃了努力。

尽管这一研究结果令人失望,但AI专家Gary Marcus在博客中指出,这并不意味着这些模型完全没有推理能力。他指出,人类在类似的任务中也存在局限性,例如许多人在解决包含8个圆盘的河内塔问题时也会出错。同时,他也强调,研究并未将这些AI模型的表现与人类进行直接对比。

总的来说,苹果的研究揭示了大型语言模型在推理能力方面的局限性。尽管它们在编程、写作等任务中表现出色,但在面对更加复杂的挑战时,仍然需要传统算法的支持。因此,我们应该将这项研究视为一项重要的参考数据,结合其他LLM研究来全面理解AI的发展现状。

在AI研究领域,每次新的发现都会引发社会舆论的极端反应。有些人会彻底看衰AI,而有些人则会过度兴奋地庆祝所谓的“突破”。然而,现实往往介于这两个极端之间。AI的发展既非惊天动地,也非一无是处,而是在不断进步和完善中。