在近期的一次技术分享会上,亚马逊云科技深度探讨了生成式AI应用评估的策略与实践,为行业提供了宝贵的洞见。分享嘉宾首先描绘了生成式AI技术带来的革命性变革,同时也不避讳地指出了伴随而来的风险与挑战。一个生动的案例被提及:一家企业早在2024年便引入了基于大语言模型的客服智能体,虽然迅速上线,但在实际应用中,智能体偶尔会因模型“幻觉”而做出不切实际的承诺,比如同意为已过保质期的商品退货,这无疑加剧了企业的运营风险。

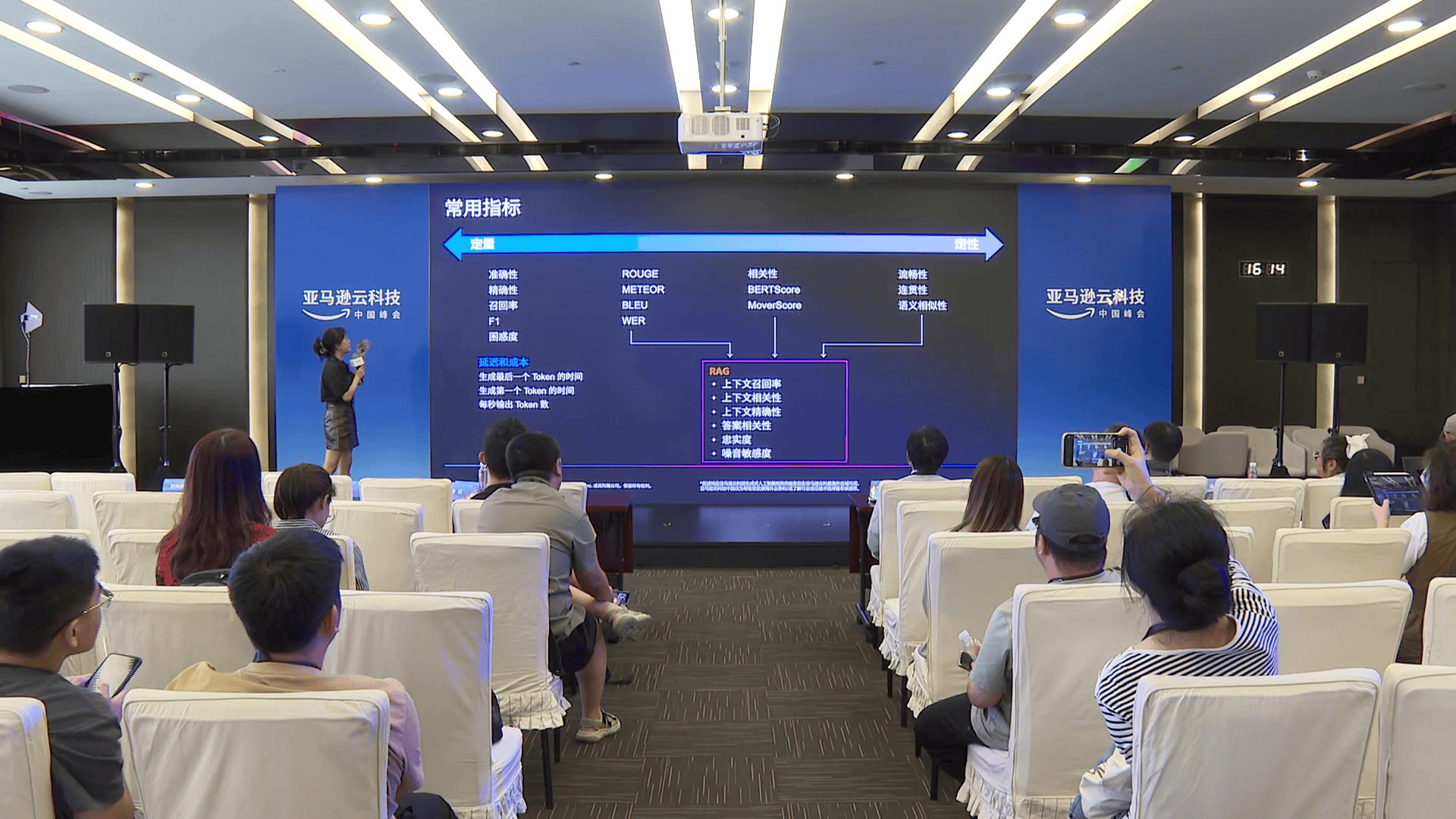

为了有效管控这些风险,嘉宾详细阐述了评估生成式AI应用的四大核心维度:质量、响应速度、成本及置信水平。质量关乎输出的准确性和可靠性;响应速度则依据应用场景的不同而有所差异,从即时推荐到离线报告生成,各有标准;成本考量不仅包括直接的经济投入,还有人力资源的分配;置信水平则聚焦于评估结果的精准度和剩余风险的可接受程度。

接着,嘉宾介绍了当前主流的四种评估方法。人工检查虽直接但成本高且难以扩展;基于规则的启发式评估虽有一定标准,但评估维度受限;大模型间的相互评估灵活且可定制,但可能引入模型偏见,成本亦不菲;性能评估则专注于模型的推理速度和成本效益。

亚马逊云科技推出的Bedrock Model evaluation服务成为此次分享的一大亮点。该服务不仅支持预制和自定义数据集,还融合了自动化与人工评估的双重优势,提供了一系列预设及自定义评估指标,极大地简化了评估流程。自动化评估涵盖准确性、稳健性和毒性等多个方面,而大模型评估则进一步细化为连贯性、完整性、有用性等12个维度。人工评估则侧重于创意和写作风格的考量。

针对检索增强生成(RAG)模型,评估聚焦于知识检索的覆盖率和相关性,以及生成结果的连续性、完整性和有用性。对于智能体(Agent)模型,评估更为复杂,需从端到端任务完成度、工具使用正确性、有效性及推理规划准确性等多个角度进行综合评价。其中,端到端评估借助大模型作为评判者,确保了任务完成度的准确衡量。

为了确保生成式AI应用在上线前的万无一失,Bedrock的Gatekeeper Drill服务作为最后一道防线,通过设置过滤器有效防止了Prompt注入攻击,检测并屏蔽了不相关内容,同时准确识别个人身份信息和敏感信息,为面向客户的应用场景提供了坚实的安全保障。

即便如此,持续的评估与跟进仍是必不可少的。通过定期生成离线评估指标,并保持每周的跟进频率,企业能够不断增进对生成式AI应用的信心。事实上,已有不少企业委托亚马逊云科技为其智能体和大模型提供评估支持,其中不乏早在2024年便涉足生成式AI领域的企业。

亚马逊云科技的CageMaker与开源框架FMEVO也为模型评估提供了更多选择。对于RAG模型,开源框架ReGGAs同样是一个值得考虑的评估工具。而在智能体模型评估方面,LongFils和DPV等开源方案也在业界获得了广泛认可,它们能够在线评估模型并自动生成评估报告。