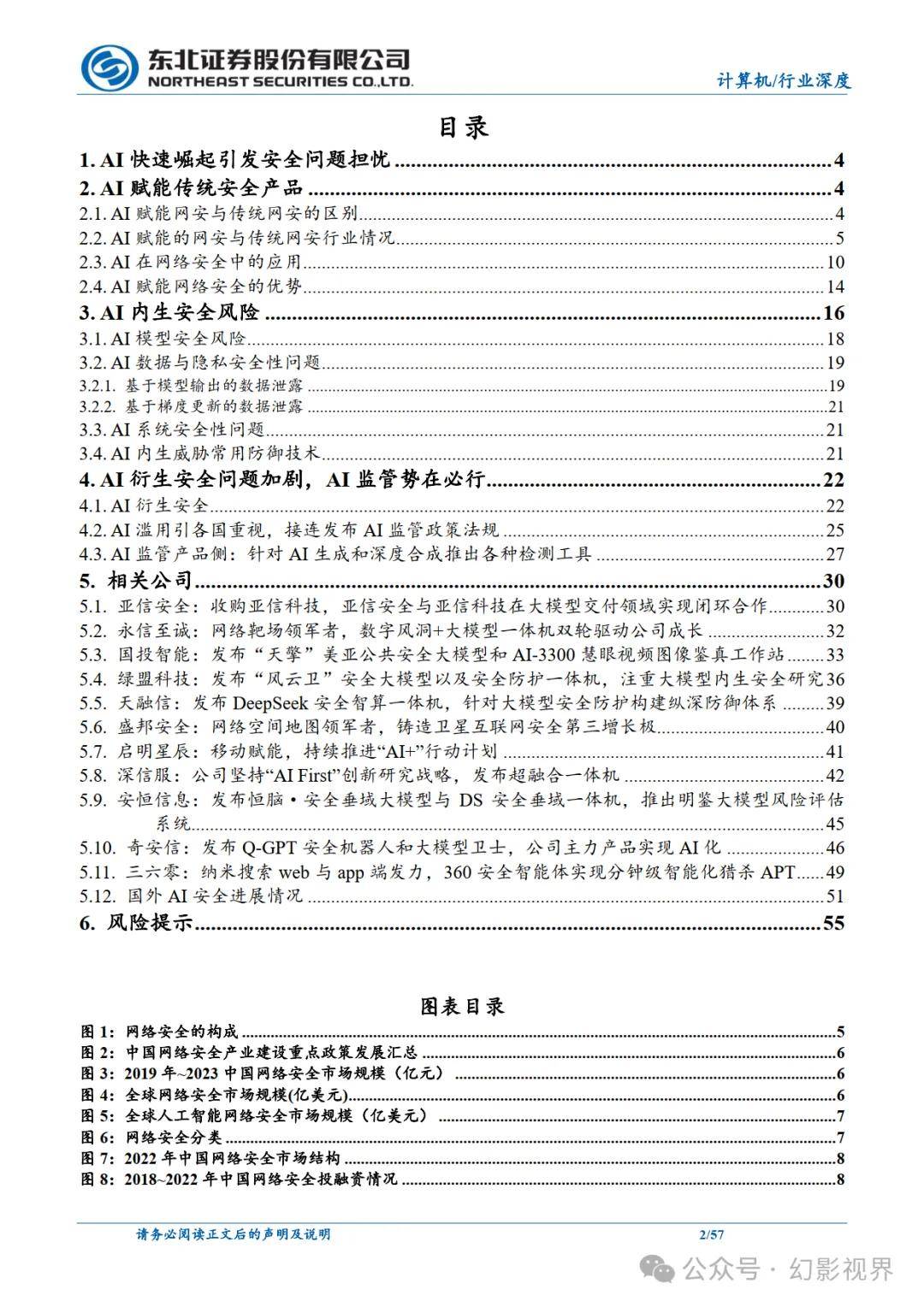

随着人工智能技术的飞速发展,特别是生成式AI如ChatGPT的兴起,“AI+安全”已成为业界关注的焦点。这一领域不仅涵盖了AI如何增强网络安全防护,还涉及AI自身存在的安全挑战及其对其他领域的潜在影响。

AI技术在网络安全领域的应用,无疑为传统安全手段带来了革新。它不仅能够提升风险检测的精准度和响应速度,还在数据安全、防火墙构建等方面展现出巨大潜力。据Statista预测,从2023年至2030年,全球AI安全市场的年复合增长率将达到27.60%,预计到2030年,市场规模将激增至1340亿美元。这一增长背后,是AI在威胁检测、数据加密、以及网络安全运营等多个环节的深度融入。

然而,AI技术的广泛应用也伴随着一系列安全问题。AI模型的训练与测试完整性、鲁棒性不足,以及数据与隐私泄露等问题,都构成了严峻的挑战。AI系统的硬件设备与软件安全同样不容忽视,它们直接关系到AI技术的整体安全性和可靠性。

更令人担忧的是,AI技术的衍生安全问题正在加剧。由于AI系统的脆弱性被利用,可能导致其他领域的安全事故,如深度伪造视频、图像、文本等内容的泛滥,不仅影响AI的合规使用,还可能威胁到人身安全和隐私保护。因此,加强AI监管,推动相关检测产品的研发与应用,已成为当务之急。我国已出台《生成式人工智能服务管理暂行办法》等法规,以应对AI滥用和衍生安全问题。

在AI赋能网络安全的同时,如何确保AI自身的安全,以及防范其可能带来的衍生风险,已成为业界亟待解决的问题。未来,随着AI技术的不断进步和应用的深入,这一领域的安全挑战将更加复杂多变,需要各方共同努力,构建更加安全、可靠的AI生态系统。