在人工智能领域的激烈竞争中,小红书人文智能实验室(Humane Intelligence Lab,简称hi lab)以其独特的多模态技术脱颖而出。近日,该实验室宣布开源其最新的视觉语言模型dots.vlm1,这一举措不仅展示了其在技术自研方面的决心,也为多模态AI的发展带来了新的活力。

dots.vlm1是小红书hi lab首个开源的多模态大模型,它基于全自研的12亿参数NaViT视觉编码器和DeepSeek V3大语言模型构建。在视觉理解和推理任务上,dots.vlm1展现出了接近业界领先水平的能力,同时在纯文本任务中也保持了竞争力。这一模型的出现,打破了当前AI模型大多局限于文本处理的现状,为多模态AI的发展开辟了新的道路。

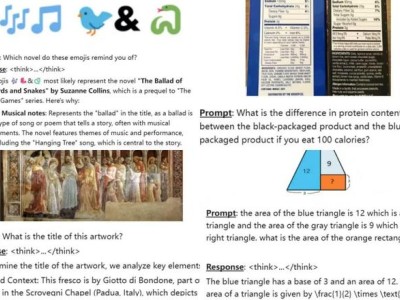

在实际测试中,dots.vlm1的表现令人惊艳。它能够准确识别空间关系、解析复杂图表、完成数独解题,甚至能够理解和解答高考数学题。dots.vlm1还展现出了强大的图像识别能力,无论是常见的物体还是冷门的图片,它都能准确识别并给出详细的解释。例如,在面对经典的红绿色盲数字问题时,dots.vlm1一次性全部答对,无论是颜色还是形状识别都表现得非常准确。

除了强大的视觉和推理能力,dots.vlm1在文本生成方面也表现出色。它能够模仿李白的诗词风格,写出一首描述刘慈欣《诗云》中诗云的诗。这首诗不仅意境深远,而且用词精准,充分展示了dots.vlm1在文本生成方面的实力。

dots.vlm1的成功,离不开小红书hi lab在技术自研方面的持续投入。该实验室由小红书内部大模型技术与应用产品团队合并升级而来,致力于将研发重点放在多元智能形态上。通过融合人际智能、空间智能、音乐智能、人文关怀等各种智能形态,hi lab不断拓展人机交互的可能性,为AI技术的发展注入了新的活力。

在dots.vlm1的开发过程中,hi lab采用了三阶段训练流程。首先,对NaViT视觉编码器进行预训练,以最大化其对多样视觉数据的感知能力。接着,将视觉编码器与DeepSeek V3大语言模型联合训练,使用大规模、多样化的多模态数据集。最后,通过有监督微调增强模型的泛化能力。这一训练流程确保了dots.vlm1在视觉和文本两个领域都能表现出色。

值得注意的是,dots.vlm1的开源不仅为AI研究者提供了宝贵的资源,也进一步推动了多模态AI技术的发展。在当前AI圈神仙打架、竞争激烈的背景下,小红书hi lab的这一举措无疑为行业树立了新的标杆。未来,随着dots.vlm1的不断完善和应用场景的拓展,我们有理由相信,它将在更多领域发挥出巨大的潜力。