在AI领域,小红书以其独特的方式加入了这场激烈的竞赛。近日,小红书人文智能实验室(Humane Intelligence Lab,简称hi lab)宣布开源了其首个多模态大模型——dots.vlm1。这款模型不仅在视觉理解和推理任务上表现出色,还展示了强大的文本处理能力,让业界为之瞩目。

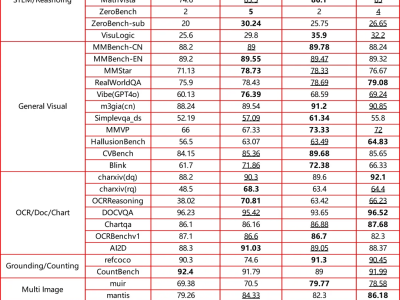

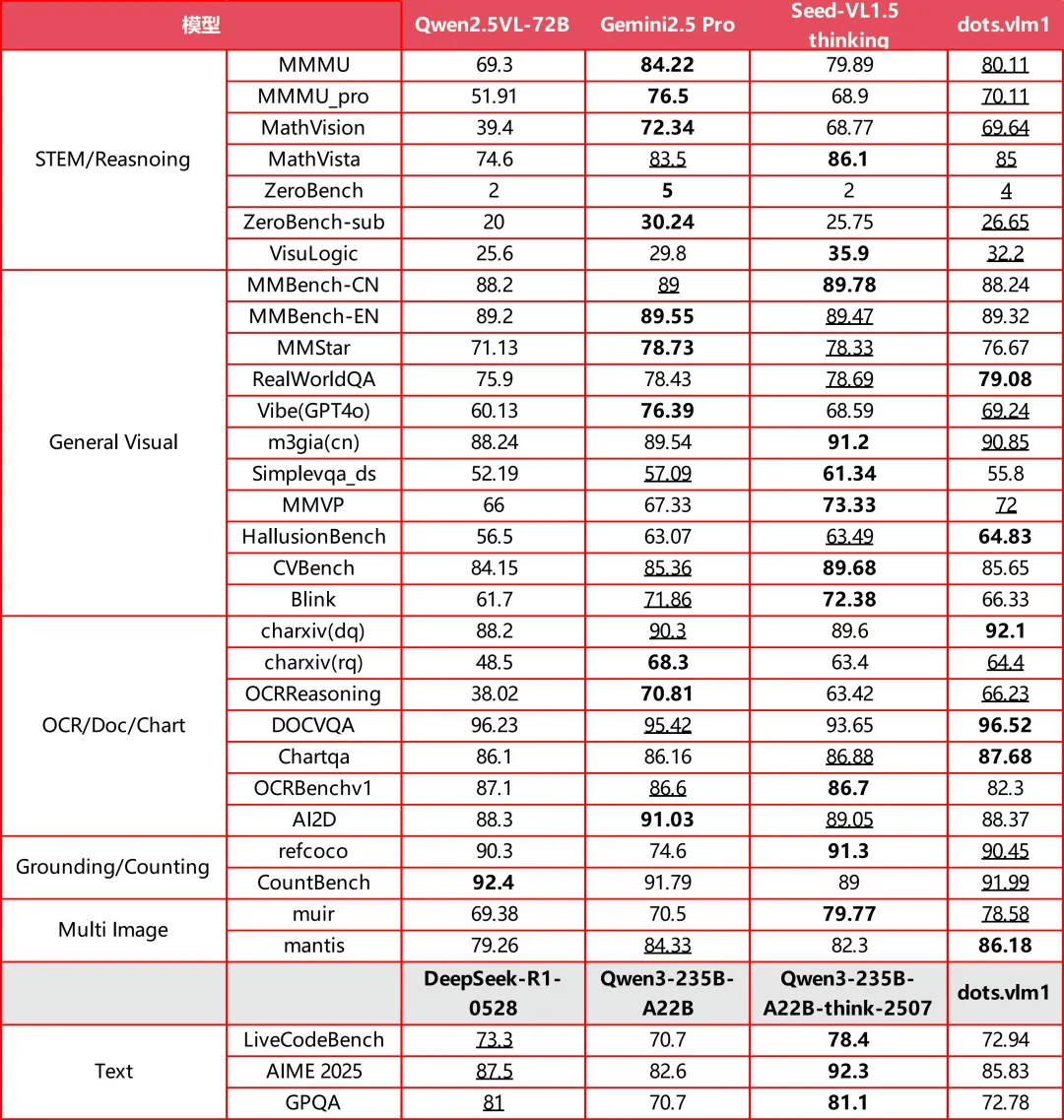

dots.vlm1基于hi lab自研的12亿参数NaViT视觉编码器和DeepSeek V3大语言模型构建。在视觉评测集如MMMU、MathVision和OCR Reasoning上,dots.vlm1的整体表现接近当前领先的Gemini 2.5 Pro和Seed-VL1.5 Thinking模型,显示出强大的图文理解与推理能力。在文本推理任务上,dots.vlm1的表现也相当出色,尽管在数学和代码能力上仍有提升空间。

hi lab近期在开源模型方面动作频频,先是dots.ocr文档解析模型在Huggingface热榜上冲到第七,紧接着dots.vlm1的发布更是引起了广泛关注。这款多模态大模型的出现,不仅为小红书在AI领域的布局增添了浓墨重彩的一笔,也为整个行业带来了新的可能性。

在实测中,dots.vlm1展现了令人惊艳的能力。它能够准确理解复杂图表中的信息,如从图表中提取特定分数和模型名称的模型。在面对数独问题时,dots.vlm1也能够通过逐步试算和检查,最终找到正确答案。它还能解决红绿色盲数字问题,以及进行复杂的数学计算和逻辑推理。

dots.vlm1的强大不仅体现在视觉和推理能力上,它还展示了出色的文本生成能力。例如,在模仿李白诗词风格写诗的任务中,dots.vlm1不仅把握住了问题的精髓,还创作出了一首意境深远、韵味十足的诗句。这充分证明了dots.vlm1在理解和生成文本方面的卓越能力。

hi lab在开发dots.vlm1时,采用了三阶段训练流程。首先是对视觉编码器进行预训练,旨在最大化对多样视觉数据的感知能力。其次是将视觉编码器与大语言模型联合训练,增强多模态能力。最后是通过有监督微调增强模型的泛化能力。这种训练策略使得dots.vlm1在视觉和文本处理方面都达到了较高水平。

hi lab在开发NaViT视觉编码器时,选择了从零开始训练的方式,而不是基于成熟视觉编码器进行微调。这种做法使得NaViT编码器原生支持动态分辨率,能够处理高分辨率输入,为视觉语言模型的设计提供了有力支持。

小红书作为一个内容分享平台,为何会投入大量资源自研多模态大模型呢?这背后有着深刻的战略考量。多模态AI模拟了人类利用多种感官综合感知世界的方式,能够形成更全面、细致的理解。在自动驾驶、具身智能等领域,多模态AI正成为企业升级的主战场。小红书希望通过自研多模态大模型,提升对海量图文内容的理解能力,实现更精准的个性化推荐,同时探索未来AI在社区交互中的应用。

从dots.llm1到dots.ocr,再到dots.vlm1,小红书人文智能实验室的dots模型家族正在不断壮大。这些模型的推出不仅展示了小红书在AI技术自研方面的决心和实力,也为整个行业带来了新的思考和启示。未来,随着dots模型家族的不断完善和发展,我们有理由相信小红书将在AI领域取得更加辉煌的成就。