近日,智谱公司正式发布了其最新一代的视觉理解模型GLM-4.5V。这款模型基于GLM-4.5-Air文本基座模型进行训练,沿袭了GLM-4.1V-Thinking的视觉推理技术路线,拥有惊人的1060亿参数和120亿激活参数。

GLM-4.5V的一大亮点在于新增了思考模式开关功能,用户可以根据需求自由控制模型是否启用思考模式。这一功能不仅提升了模型的灵活性,也使用户体验更加个性化。

在视觉能力方面,GLM-4.5V展现出了诸多有趣的应用。例如,它能够区分麦当劳和肯德基的炸鸡翅,并从色泽、外皮质感等多个角度进行全面分析。这种细致入微的观察能力,让人对模型的视觉理解深度刮目相看。

GLM-4.5V还参与了与人类玩家的拍图猜地点积分赛。仅加入比赛7天后,它的积分就跃升至赛事网站的第66名,超越了99%的人类用户。这一成绩不仅证明了模型在视觉识别方面的强大实力,也展示了其在复杂场景下的应用潜力。

更令人惊叹的是,GLM-4.5V还能根据网页截图,打造出与小红书高度相似的网页。尽管在布局细节上略有差异,但整体相似度极高,几乎可以以假乱真。这一功能对于网页设计和开发来说,无疑是一个巨大的福音。

在基准测试方面,GLM-4.5V同样表现出色。在覆盖图像、视频、文档理解以及图形界面智能体操作等42个常见任务的测试中,它在41个测试中得分超过了同尺寸模型,如Step-3、Qwen2.5-VL等。这一成绩再次证明了GLM-4.5V在视觉理解领域的领先地位。

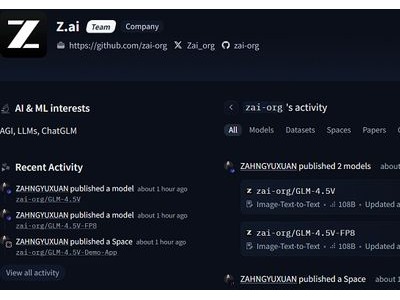

目前,GLM-4.5V已在开源平台Hugging Face、魔搭、GitHub上发布,并提供了FP8量化版本。为了方便用户体验,智谱还为其打造了一个体验App,不过目前仅限于Mac端(且需为非Intel芯片)使用。用户还可以在z.ai平台上选择GLM-4.5V模型,上传图片或视频进行体验。

为了助力开发者更好地体验GLM-4.5V的模型能力,智谱还同步开源了一款桌面助手应用。这款应用可以实时截屏、录屏获取屏幕信息,并依托GLM-4.5V处理多种视觉推理任务。无论是代码辅助、视频内容分析,还是游戏解答、文档解读,它都能轻松应对。

在实际测试中,GLM-4.5V的表现同样令人印象深刻。在一张“灵隐寺一角”的照片中,尽管画面中没有明显的地标性信息,但模型还是结合环境特征进行了详细推理,虽然最终将结果推断为四川都江堰的青城山,与真实地点有所出入,但推理过程的细节丰富,结果仍具备一定的参考价值。

GLM-4.5V还具备一定的GUI(图形用户界面)能力。它可以帮助用户在复杂的购物网站截图中计算出折扣信息,还能对生成结果进行反思和确认。这一能力对于理解、操作网页或App等Agent场景至关重要。

在生产力方面,GLM-4.5V同样不容小觑。它可以根据网页录屏、截图等复现前端代码,分析画面中内容、样式、布局等元素,推测背后的代码,并对交互逻辑进行建模与实现。这一功能对于网页开发和设计来说,无疑是一个巨大的助力。