在AI领域的激烈竞争中,一项关于AI推理业务盈利能力的深度分析近日引起了广泛关注。这份由摩根士丹利发布的报告,采用精密的财务模型,对全球AI算力竞赛的经济回报进行了全面剖析。

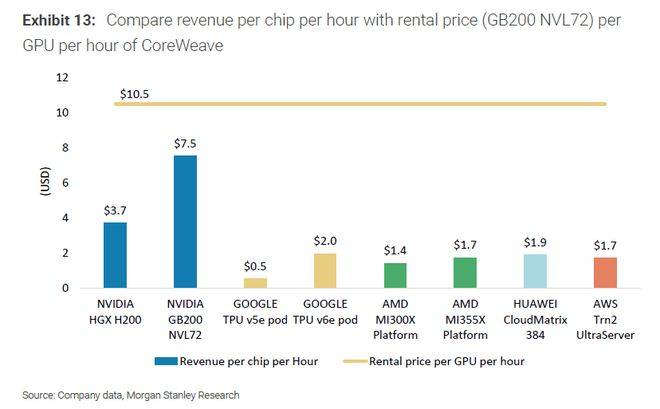

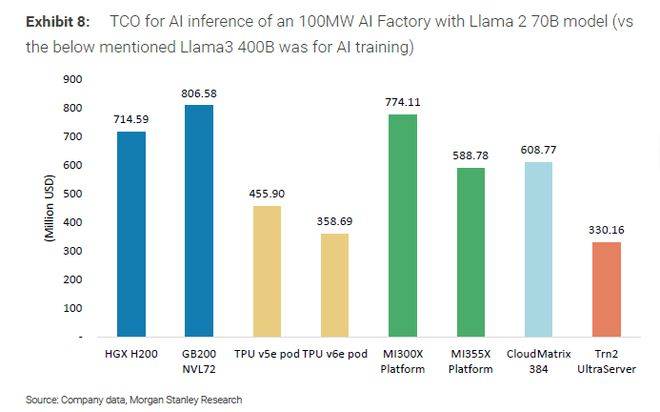

报告指出,构建一座标准的“AI推理工厂”,不论采用哪家科技巨头的芯片,其平均利润率普遍超过50%,展现出了AI推理业务的巨大盈利潜力。其中,英伟达GB200芯片的表现尤为抢眼,以近78%的利润率稳居榜首,谷歌和华为的芯片同样实现了可观盈利。然而,AMD的AI平台在推理场景下却遭遇了严重亏损,这一结果令人颇感意外。

摩根士丹利的模型测算结果清晰地展示了AI硬件巨头们在真实商业场景下的盈利能力分化。英伟达、谷歌、亚马逊和华为等科技巨头在AI推理领域表现出色,盈利能力遥遥领先。特别是英伟达,其旗舰产品GB200 NVL72凭借其卓越的计算、内存和网络性能,以及持续创新和深厚的CUDA软件生态壁垒,展现出了绝对的市场统治力,盈利能力高达77.6%。

谷歌自研的TPU v6e pod则以74.9%的利润率紧随其后,证明了顶级云厂商通过软硬件协同优化,能够构建起极具经济效益的AI基础设施。AWS的Trn2 UltraServer和华为的昇腾CloudMatrix 384平台也分别取得了62.5%和47.9%的利润率,表现不俗。

相比之下,AMD的AI平台在推理场景下的财务表现则令人失望。报告显示,采用AMD MI300X和MI355X平台的“AI工厂”,利润率分别为-28.2%和-64.0%。高昂的成本与产出效率的严重失衡是导致亏损的主要原因。尽管AMD平台的年度总拥有成本与英伟达GB200平台相当,但在模拟的推理任务中,其token产出效率所能创造的收入远不足以覆盖成本。

摩根士丹利的这份报告还首创了一套标准化分析框架——“100MW AI工厂模型”,用于量化评估不同技术路径的AI解决方案。该模型以100兆瓦的电力消耗作为基准单位,全面核算了总拥有成本,并设定了市场化的收入公式,以量化投资回报。这一框架为决策者和投资者提供了重要的参考依据,有助于他们更准确地评估AI时代的算力投资。

报告还揭示了未来AI战场上的焦点将集中在技术生态的构建和下一代产品的布局上。在非英伟达阵营中,关于“连接标准”的战争已经打响,各大厂商纷纷推出自己的解决方案,力图建立起一个可与英伟达NVLink抗衡的开放生态。而英伟达则以其清晰的路线图巩固领先地位,其下一代平台“Rubin”预计将于2026年第二季度进入大规模量产,给竞争对手带来了更大的压力。