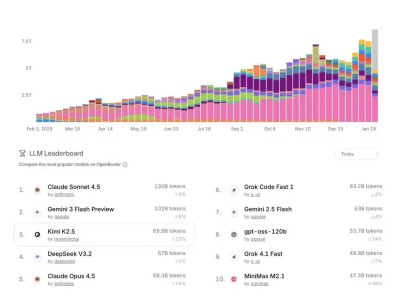

英伟达近日正式推出全新开源模型系列Nemotron 3,涵盖Nano、Super和Ultra三种规格,并同步发布配套技术工具与数据集,旨在为专用智能体AI系统开发提供高性能解决方案。该系列模型通过架构创新与训练方法突破,在推理效率、长序列处理及多智能体协同等核心场景实现显著提升。

Nemotron 3系列采用差异化定位设计:Nano版本配备300亿参数(活跃参数量30亿),专为DGX Spark、H100和B200 GPU优化,聚焦高效任务处理,现已投入市场;Super版本拥有1000亿参数,侧重多智能体协同与高精度推理;Ultra版本参数规模达5000亿级,搭载超大推理引擎,可应对最复杂的应用场景。后两者计划于2026年上半年发布,通过架构升级进一步扩展基础能力。

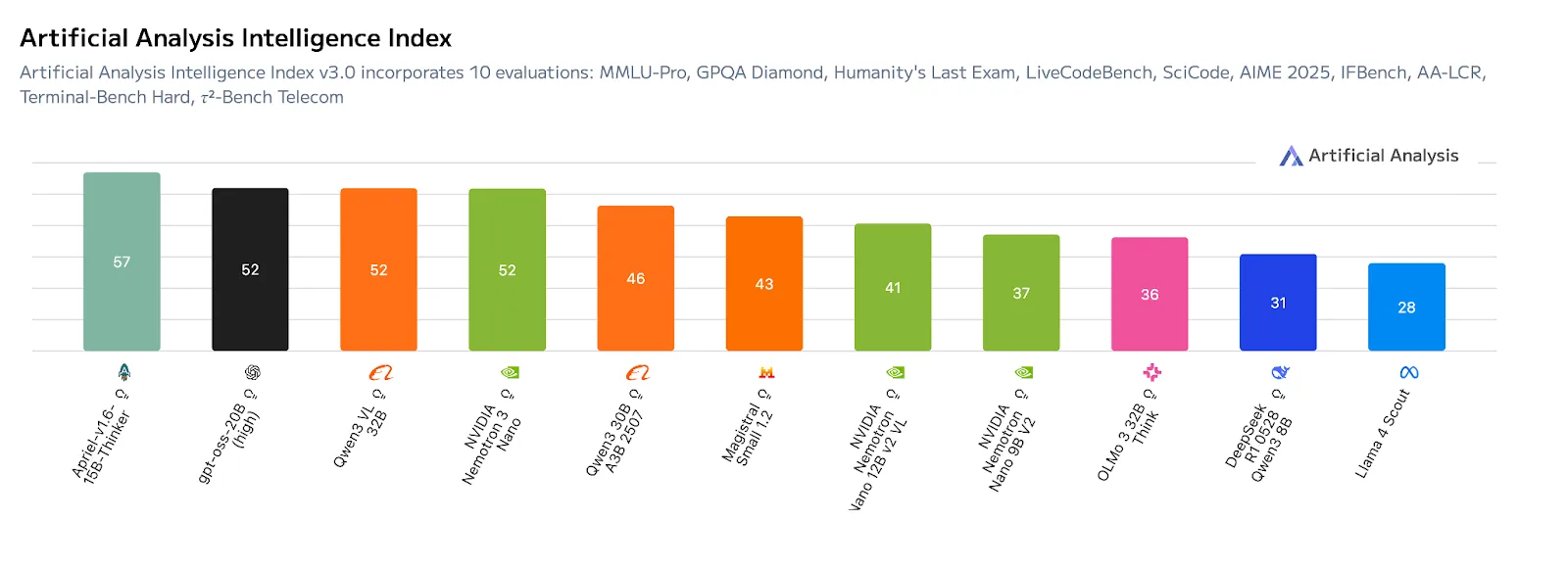

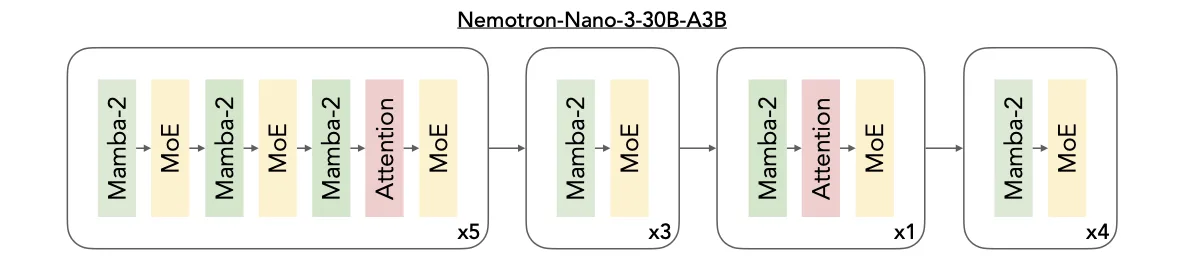

在基准测试中,Nano版本于Artificial Analysis Intelligence Index v3.0中以52分领先同规模模型,其性能优势源于创新的Mamba-Transformer MoE混合架构。该架构整合三大核心技术:Mamba层以极低内存开销实现超长序列依赖追踪,支持百万级Token处理;Transformer层通过注意力机制精准建模任务逻辑,强化推理能力;MoE路由机制则通过动态调用专家模块,在控制计算成本的同时提升吞吐效率。这种设计使模型天然适配多智能体并发场景,例如同时生成任务计划、分析上下文或调用工具执行工作流。

为提升模型实际应用能力,英伟达在开源强化学习平台NeMo Gym中对Nemotron 3进行后训练。该平台模拟真实世界环境,要求模型完成复杂动作序列,如调用API查询数据、编写可运行代码或规划多阶段任务。这种训练方式有效减少“推理漂移”现象,增强模型处理结构化流程的稳定性,降低将大模型转化为领域专家的技术门槛。

Nemotron 3的另一突破是支持100万Token上下文窗口,可完整保存任务背景、历史记录与复杂计划,避免传统文本切割导致的信息碎片化。这一能力得益于混合架构的低内存开销特性与MoE机制的按需激活策略,为企业级文档分析、跨会话协作等场景提供逻辑连贯性保障。

针对Super和Ultra版本,英伟达引入三项进阶技术:潜在MoE通过共享潜在表征空间运算,使模型以相同成本调用4倍专家数量,提升对细微语义与复杂推理的处理精度;多Token预测技术允许模型一次生成多个词,显著加快长篇逻辑推理与结构化输出的响应速度;NVFP4训练格式则通过4位浮点优化,在25万亿Token数据集训练中实现成本与精度的平衡。

为支持开发者训练定制模型,英伟达同步开放四大数据集:包含3万亿Token的预训练集、1300万样本的后训练集3.0、强化学习专用数据集,以及涵盖近1.1万条智能体工作流轨迹的安全数据集。结合NeMo Gym、RL、Data Designer等开源工具库,开发者可完整复现模型开发流程。目前,埃森哲、德勤、甲骨文云基础设施、西门子等企业已成为Nemotron 3的早期采用者。