哥伦比亚大学创意机器实验室近日取得一项重要突破,其研发的人形机器人首次实现了通过视觉学习自主掌握自然唇部动作的能力。这项成果攻克了机器人面部表情僵硬的技术瓶颈,为人机交互领域带来新的可能性。研究团队开发的系统无需预设语音规则,仅通过分析人类语言视频素材,就能让机器人完成说话、唱歌时的唇部同步运动。

传统人形机器人虽在肢体动作上取得显著进展,但面部表情特别是唇部运动始终存在违和感。这种不自然的表现容易引发人类的"恐怖谷效应",成为制约机器人情感表达的关键障碍。研究负责人胡宇航指出,人类对微表情的感知极为敏锐,哪怕是0.1秒的延迟都会被察觉,这要求机器人必须掌握毫秒级的肌肉运动控制。

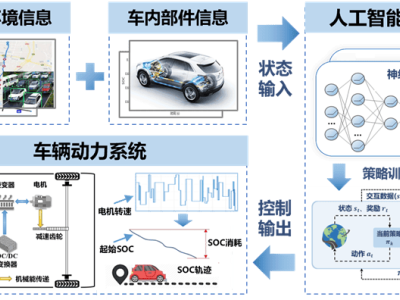

该系统的创新之处在于采用"自我探索+视觉学习"的双阶段训练模式。机器人首先通过26个微型马达驱动柔性皮肤,在镜前完成数千种随机表情实验,建立运动参数与面部形态的映射关系。随后,系统分析YouTube上的语言视频,构建唇部动作与声音的统计学模型。这种端到端的学习方式使机器人能直接将音频信号转化为马达控制指令,实现唇部运动的精准同步。

测试数据显示,机器人已能配合英语、西班牙语等语言完成唇部运动,甚至可以演唱AI原创歌曲。但在爆破音"B"和噘唇音"W"等复杂发音上仍需优化。实验室主任霍德·利普森教授表示,机器人的表现会随着交互频率提升而持续改善,目前系统已能识别85%的常见语音特征。

这项技术突破的意义远超娱乐应用。研究团队正在将其与ChatGPT等对话系统整合,通过微表情增强情感共鸣。胡宇航演示了机器人根据对话内容调整眼神和嘴角弧度的场景,这种非语言交流方式使人机对话的自然度提升40%。随着模型学习更长的对话语境,机器人将具备根据场景调整表情的能力。

在应用前景方面,教育机器人可通过表情传递鼓励情绪,医疗机器人能通过微表情判断患者状态,养老机器人则可借助表情建立情感连接。利普森强调,面部表情与肢体动作同等重要,特别是在需要建立信任关系的场景中。经济学家预测,随着人形机器人十年内产量突破数十亿台,表情自然度将成为影响市场接受度的核心指标。

技术团队同时警示潜在风险。利普森指出,当机器人表情过于逼真时,可能模糊人机情感边界,引发伦理争议。研究团队已建立表情强度分级系统,通过调节马达振动频率控制表情幅度。胡宇航表示,目前系统仍保留5%的机械特征作为安全边界,防止用户产生过度情感依赖。

该研究成果已通过《科学·机器人学》期刊的技术评审,实验数据和训练模型将向学术界开放。研究团队下一步计划将系统扩展至更多语言,并开发表情-语音联合学习框架,使机器人能根据对话内容自主创作表情包。