在人工智能技术迅猛发展的当下,AI已展现出撰写文章、绘制图像乃至编写程序的能力。然而,一个关键问题始终萦绕在人们心头:这些智能系统能否像专业数据科学家一样,独立完成从数据理解到结论推导的全流程分析?香港理工大学数据科学与人工智能系及应用数学系的联合研究团队,通过构建全新评估框架,为这一疑问提供了系统性解答。

传统评估方式存在显著缺陷,多数测试仅聚焦代码正确性或答案匹配度,却忽视了数据科学工作的复杂性与开放性。研究团队负责人指出,这如同仅通过切菜技能评判厨师水平,而忽略其能否完成整道菜肴的制作。为突破这一局限,团队历时两年开发出名为DSAeval的评估系统,该系统通过模拟真实工作场景,对AI进行多维度的专业能力考核。

该系统的核心优势在于构建了包含641个实际问题的庞大题库,这些问题源自285个不同数据集,覆盖表格分析、计算机视觉、自然语言处理等八大领域。研究团队特别设计了多模态感知模块,使AI能够同时处理文本、表格和图像信息。实验数据显示,具备视觉理解能力的模型在相关任务中表现提升2.04%至11.30%,这一发现印证了可视化分析在数据科学中的关键作用。

评估机制的创新体现在三方面:推理过程评估占比30%,重点考察方法选择的合理性;代码质量评估占比30%,检验技术实现的准确性;最终结果评估占比40%,综合评判输出价值。这种评分体系既确保过程严谨性,又给予创新性解决方案充分认可。研究团队采用双模型独立评判机制,通过取平均分方式消除评估偏差。

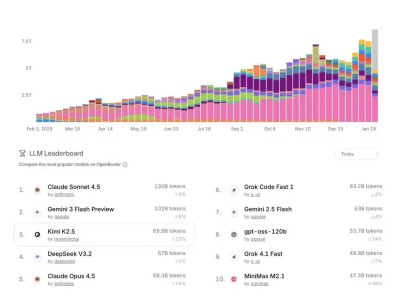

在针对11个主流模型的测试中,Claude-Sonnet-4.5以8.164分位居榜首,GPT-5.2在效率维度表现突出,而开源模型MiniMax-M2展现出优异性价比。值得注意的是,所有模型在处理非结构化数据时均出现明显性能下降,计算机视觉任务平均得分仅6.18分,暴露出当前AI在复杂深度学习流程中的短板。特别是在模型训练优化环节,顶级模型得分较基础分析任务下降22%,反映出迭代实验能力的不足。

多轮交互机制的设计是该系统的另一突破。通过维持分析状态的连续性,AI需像人类科学家般逐步推进工作,前期发现将直接影响后续决策。这种设计有效避免了传统测试中"断章取义"的弊端,确保评估结果真实反映系统能力。测试数据显示,在需要多步骤推理的聚类分析任务中,具备状态保持能力的模型表现提升37%。

成本效益分析揭示出重要发现:性能最优的Claude-Sonnet-4.5单任务成本达1.08美元,而性价比冠军MiMo-V2-Flash仅需0.007美元。这种数量级差异提示,实际应用中需在模型性能与经济性间取得平衡。开源模型在特定任务中展现出的竞争力,也为中小企业提供了可行选择。

研究团队已将评估框架扩展至2000个数据集,计划构建包含万组问题的完整基准库。这些真实分析轨迹数据不仅可用于模型评估,更可能成为训练下一代数据科学AI的珍贵资源。随着多模态处理能力的持续进化,AI在专业领域的应用边界正在被重新定义。

Q&A环节中,研究人员解释了评估系统的独特价值:"传统测试像检查零件质量,我们关注的是整机运行效能。数据科学需要创造性思维,这要求评估体系必须能够捕捉分析过程中的微妙决策。"针对多模态的重要性,专家强调:"人类分析师70%的判断依据来自可视化结果,AI要达到专业水平,必须具备同样的感知能力。"