社交媒体上,一场围绕AI架构起源的激烈讨论持续发酵。事件的导火索是“欧洲版OpenAI”Mistral首席执行官Arthur Mensch在访谈中的惊人表态——他声称中国开源模型DeepSeek-V3的架构基础源自Mistral的技术方案。这一论断迅速点燃全球开发者社区,引发对技术原创性与开源生态边界的深度探讨。

争议焦点集中于技术演进的时间线与核心创新点。公开资料显示,Mistral于2024年初推出首个稀疏混合专家模型(MoE),而DeepSeek团队几乎同步提交的论文仅比前者晚3天。技术社区通过对比原始论文发现,尽管两者同属SMoE架构,但设计理念存在显著分野:Mistral侧重工程优化路径,而DeepSeek重构了算法底层逻辑,引入“细粒度专家分割”与“共享专家”机制,实现通用知识与领域知识的解耦。这种架构差异使得两者在专家模块的层级设计与知识分配方式上呈现本质区别。

戏剧性转折出现在2025年末。开发者社区对Mistral3Large的逆向分析显示,该模型底层架构与DeepSeek-V3首创的MLA技术存在高度相似性。这一发现引发技术圈对“技术回流”现象的热议,部分专家指出,DeepSeek在MoE架构的创新实践已形成显著行业影响力,而Mistral的架构调整更像是技术追赶的应激反应。社交媒体上甚至出现调侃言论,称某些机构试图通过重构技术叙事来维持市场话语权。

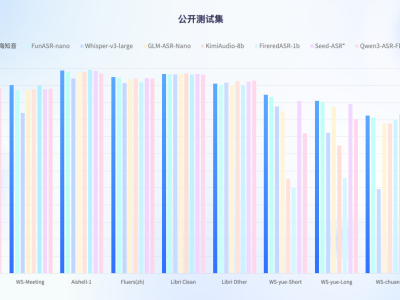

在这场技术路线之争背后,全球AI实验室的竞争焦虑愈发凸显。DeepSeek团队被曝正筹备2026年春节期间发布新一代模型,其性能指标可能再次突破现有边界;与此同时,Mistral持续迭代Devstral家族产品,试图在开源编程智能体领域重夺优势地位。开源社区的开发者普遍认为,这种白热化竞争客观上推动了技术进步,但单纯的技术路线争论终需回归模型性能的实证检验。

值得关注的是,Arthur Mensch在引发争议的访谈中,也曾强调开源生态的核心价值在于“站在巨人肩膀上持续创新"。这种看似矛盾的表述,恰恰折射出当前AI领域的技术博弈困境:既需要开放协作的生态基础,又面临商业竞争的生存压力。随着模型复杂度指数级增长,技术溯源的难度与争议性将持续存在,而最终裁决权始终掌握在客观性能测试与真实场景应用之中。