蚂蚁集团旗下具身智能企业蚂蚁灵波科技近日宣布,其自主研发的LingBot-VLA具身大模型及配套后训练工具链正式开源,同时开源的还有面向三维空间感知的LingBot-Depth深度补全模型。这一系列技术突破标志着具身智能领域在数据驱动、跨平台迁移及三维感知能力方面取得重要进展。

在机器人跨本体适配方面,LingBot-VLA已与星海图、松灵机器人、乐聚机器人等企业完成技术对接,验证了该模型在双臂协作机器人、轮式移动机器人等不同构型设备上的迁移能力。通过构建标准化后训练工具链,该系统在8卡GPU环境下实现每秒261个样本的处理速度,训练效率较同类框架提升1.5至2.8倍,有效降低了数据采集与算力投入成本。

基于20,000小时真实机器人操作数据的预训练研究显示,当数据规模从3,000小时逐步扩展至20,000小时时,模型在复杂任务中的成功率呈现持续上升趋势。特别值得注意的是,在达到最大数据规模时性能仍未出现饱和迹象,这为具身智能系统的持续优化提供了重要理论依据。研究团队构建的训练数据集覆盖AgileX Cobot Magic、Galaxea R1Pro等9种主流双臂机器人构型,涵盖抓取、搬运、装配等100余项真实操作场景。

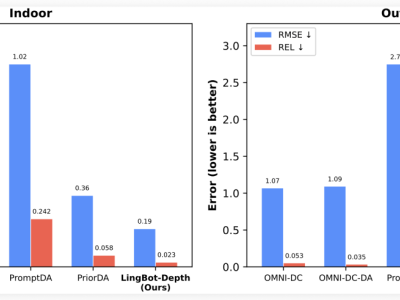

在性能验证环节,上海交通大学开源的GM-100评测基准显示,搭载LingBot-VLA的机器人平台在跨本体泛化测试中取得显著突破。相比基线模型13.0%的成功率,该系统在无深度信息输入时达到15.7%,引入深度数据后进一步提升至17.3%。这一提升得益于LingBot-Depth模型提供的精准空间感知能力,该模型可将含噪声的原始深度数据转化为毫米级精度的三维点云。

作为全球首个通过工业级深度相机认证的开源模型,LingBot-Depth在ETH3D、NYUv2等国际基准测试中刷新多项纪录。其创新性的训练方法直接利用奥比中光Gemini 330系列相机的原始深度数据,在单目深度估计、双目匹配等任务上达到行业领先水平。特别在动态场景处理方面,该模型无需复杂时序建模即可保持视频流的空间一致性,这对自动驾驶、服务机器人等实时应用场景具有重要意义。

目前,两大模型的技术文档与源代码已在指定平台开放下载,开发者可获取涵盖数据预处理、模型训练、部署优化的全流程工具包。此次开源不仅为学术界提供了前沿研究基准,更为工业界降低具身智能技术应用门槛提供关键支撑。