蚂蚁集团机器人团队在机器人学习领域取得重大进展,其研发的LingBot-VLA系统为行业带来突破性成果。这项研究通过构建大规模真实操作数据集和优化训练框架,使机器人能够像人类一样通过观察和指令完成复杂双手操作任务,相关论文已发表于学术平台供全球研究者查阅。

传统机器人受限于预设程序,难以适应动态环境。研究团队开发的LingBot-VLA系统通过多模态融合架构,将视觉理解、语言解析和动作规划整合为统一系统。其核心的Mixture-of-Transformers架构包含两个协同工作的模块:一个负责解析环境信息与指令语义,另一个专注生成连续流畅的动作序列,二者通过注意力机制实现信息互通,使机器人具备空间感知与精准操作能力。

研究团队历时两年构建了全球最大规模的机器人操作数据集,涵盖9个不同平台约20000小时的真实操作记录。这些数据通过遥操作技术采集,由真人远程控制机器人完成多样化任务,确保数据真实性。自动标注系统结合人工校验,为每个动作序列匹配详细的任务描述与分解步骤。实验表明,随着训练数据量从3000小时增至20000小时,系统性能持续提升且未现饱和迹象,证明数据规模对机器人学习的重要性。

在训练效率方面,研究团队通过分布式计算优化实现重大突破。改进的Fully Sharded Data Parallel技术将模型参数分片存储于不同GPU,减少通信开销的同时提升计算效率。FlexAttention机制与算子融合策略使系统在8块GPU配置下达到每秒261个样本的处理速度,较现有开源框架提升1.5至2.8倍。这种效率提升显著降低了模型训练成本,为技术落地应用创造条件。

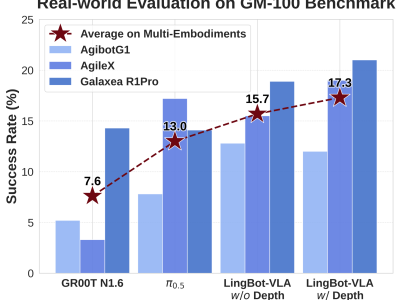

大规模测试验证了系统的泛化能力。研究团队在三个不同硬件平台(AgileX、Agibot G1、Galaxea R1Pro)上部署系统,完成100个涵盖物体抓取、组装等场景的任务测试,累计试验次数超过22500次。结果显示,LingBot-VLA平均成功率达17.30%,进度评分35.41%,均显著优于对照组。值得注意的是,约50%的测试动作未出现在训练数据中,证明系统具备知识迁移与新场景适应能力。

深度信息学习机制是提升空间操作精度的关键创新。系统通过可学习查询机制将多视角图像与深度感知模型生成的深度标记对齐,使机器人具备三维空间理解能力。实验数据显示,集成深度信息的版本在物体放置任务中成功率提升3至4个百分点,在需要双手协调的操作中表现尤为突出。

数据效率研究揭示了系统在微调阶段的优异表现。使用80个演示样本时,LingBot-VLA性能即超越使用130个样本的对照模型,且随着数据量增加,性能提升幅度持续扩大。这种特性使系统能够快速适应新任务,降低实际应用中的数据采集成本。

仿真环境测试进一步验证系统鲁棒性。在RoboTwin 2.0平台进行的50项任务测试中,系统在清洁环境与随机化环境下的成功率分别达88.56%和86.68%,较对照组提升显著。随机化测试通过改变光照、障碍物位置等变量模拟真实场景,证明系统具备应对复杂环境的能力。

为推动技术发展,研究团队将代码、预训练模型和基准数据集完全开源。开源的GM-100数据集包含100个标准化任务及评估标准,为行业提供统一评测基准。训练框架的优化设计使中小型研究团队也能利用有限资源开展大模型训练,加速技术迭代进程。

这项成果标志着机器人学习向实用化迈出重要一步。通过整合多模态感知、大规模数据训练与高效计算框架,系统展现出在工业制造、医疗护理等领域的潜在应用价值。研究团队正探索扩展系统通用性,计划集成单臂与移动机器人数据,开发能够在开放环境中执行多样化任务的智能系统。