人工智能领域迎来一项突破性进展——浙江大学联合蚂蚁集团、北京大学的研究团队提出了一种名为InftyThink+的新型推理框架,成功破解了当前AI模型在复杂任务中面临的"长篇大论"困境。这项发表于学术平台arXiv的研究成果,通过模拟人类分段思考模式,使AI在保持深度推理能力的同时,计算效率获得质的飞跃。

传统AI模型在处理复杂问题时,往往需要生成数万字的推理过程,这种"话痨式"的解题方式导致三大技术瓶颈:计算成本随推理长度呈指数级增长,内存容量限制迫使推理中断,以及关键信息在冗长过程中被稀释。研究团队形象地将这种现象比作"马拉松选手被迫在半途停止比赛",即便投入更多计算资源也难以突破物理限制。

InftyThink+的创新之处在于引入迭代推理机制,其核心设计理念借鉴了人类解决复杂问题的策略。当面对数学难题时,系统会自主判断何时暂停推理,将已完成的思考内容提炼为关键结论,再基于这些精炼信息继续推进。这种"思考-总结-再思考"的循环模式,使AI能够在有限内存中实现无限深度的推理。

研究团队通过两阶段训练法赋予AI自主决策能力。初期采用监督学习让系统掌握基础迭代格式,随后通过强化学习训练其策略优化能力。在数学竞赛级数据集AIME24的测试中,优化后的系统准确率提升21%,推理延迟减少32.8%,训练速度加快18.2%。更关键的是,系统学会了在准确性与效率间寻找平衡点,当引入效率奖励机制后,推理过程自动缩短30%而正确率保持稳定。

技术验证显示,InftyThink+的优势具有跨领域普适性。在科学推理数据集GPQA_diamond上,系统在未接触过该领域训练数据的情况下,仍取得5%的准确率提升。对40亿参数的Qwen3-4B-Base模型测试表明,该方法在不同规模模型中均有效,证明其不是特定任务的技巧优化,而是具有根本性的技术突破。

深入分析揭示,系统的智能体现在三个维度:在总结时机选择上,自适应策略比固定规则性能提升15%;在信息压缩环节,系统生成的专用总结比通用模型摘要更有效;在推理延续阶段,其生成的中间结论能更好地支持后续推理。这种端到端的优化使计算复杂度从O(L²)降至O(n×l²),其中n为迭代次数,l为单次迭代长度。

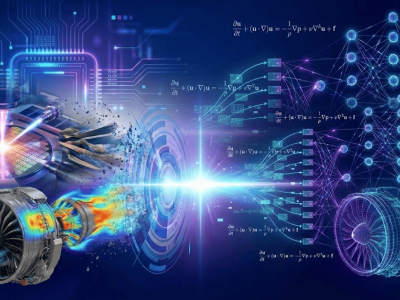

该技术的实际应用前景广阔。教育领域可开发出能自动提炼解题要点的AI导师,科研场景能支持需要多步验证的理论推导,工程设计领域可系统性分析复杂系统的多个约束条件。特别是在资源受限的移动端设备上,其高效推理能力将使AI助手实现更快的响应速度。

针对公众关心的技术落地问题,研究团队解释称,虽然当前成果仍处于实验室阶段,但已为下一代AI系统开发指明方向。未来智能助手处理复杂问题时,将不再需要输出冗长解释,而是通过结构化推理过程,在保持可解释性的同时显著提升效率。这项突破标志着AI推理能力从"量变"向"质变"的关键跨越。