腾讯技术团队近期对DeepSeek开源项目中的DeepEP通信框架进行了深度优化,这一举措显著提升了该框架在各种网络环境下的性能表现。经过一系列精心设计的测试,结果显示,优化后的DeepEP在RoCE网络环境下性能实现了翻倍,而在IB(InfiniBand)网络环境下也提升了30%。这一成果无疑为企业的AI大模型训练提供了更为高效的解决方案。

DeepEP是一个专为专家混合(MoE)和专家并行(EP)设计的通信库,其特点在于能够提供高吞吐量和低延迟的全对全GPU内核,这些内核在MoE的派发和组合过程中发挥着关键作用。该库还支持低精度运算,包括FP8,从而进一步提升了计算效率。

腾讯星脉网络团队在DeepEP开源后迅速展开了技术攻关,针对框架在实际应用中遇到的两大瓶颈问题进行了深入研究。一是双端口网卡带宽利用率不足的问题,二是CPU控制面交互存在的时延问题。通过腾讯技术团队的优化,这两个关键问题得到了有效解决。

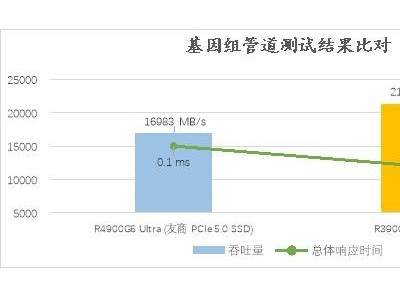

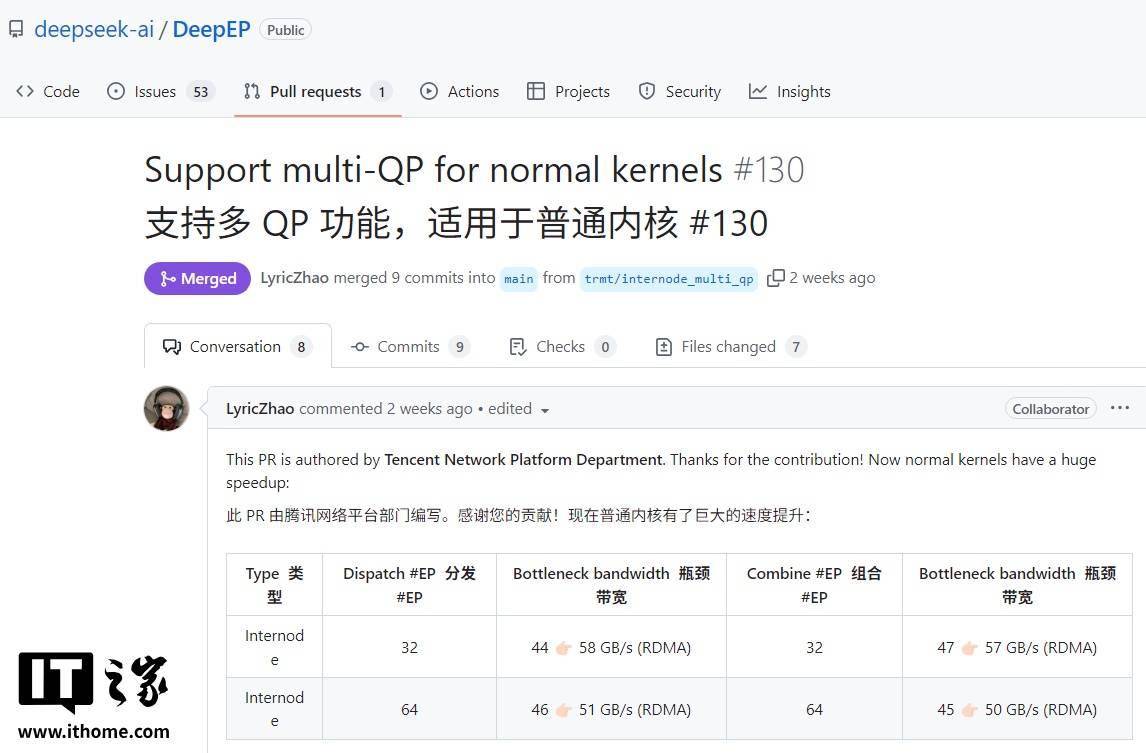

优化后的DeepEP在RoCE网络环境下实现了性能的显著提升,性能翻倍的表现令人瞩目。同时,在IB网络环境下,优化后的框架也展现出了更加出色的通信效率,相较于优化前提升了30%。这一成果不仅得到了DeepSeek项目的公开致谢,还被赞誉为一次“巨大的加速”代码贡献。

腾讯已经将这一优化后的技术全面开源,并成功应用于其混元大模型等项目的训练推理过程中。在腾讯星脉与H20服务器构建的环境中,该方案展现出了出色的通用性和稳定性,为企业AI大模型训练提供了强有力的技术支持。