近期,人工智能领域的一项新研究引发了广泛关注。Giskard团队在其官方博客上发布了一项重要发现,揭示了AI模型在简洁回答要求下,事实性表现会受到显著影响。这一发现对于AI技术的实际应用具有重要意义。

研究表明,当AI模型被要求用更短的篇幅回答问题,特别是面对模糊主题时,其产生错误信息的倾向会大幅增加。Giskard团队指出,简单的系统指令调整就能显著改变模型产生“幻觉”的概率。这一现象在许多实际应用中尤为关键,因为为了提高响应速度和降低成本,系统往往倾向于选择简洁的输出结果。

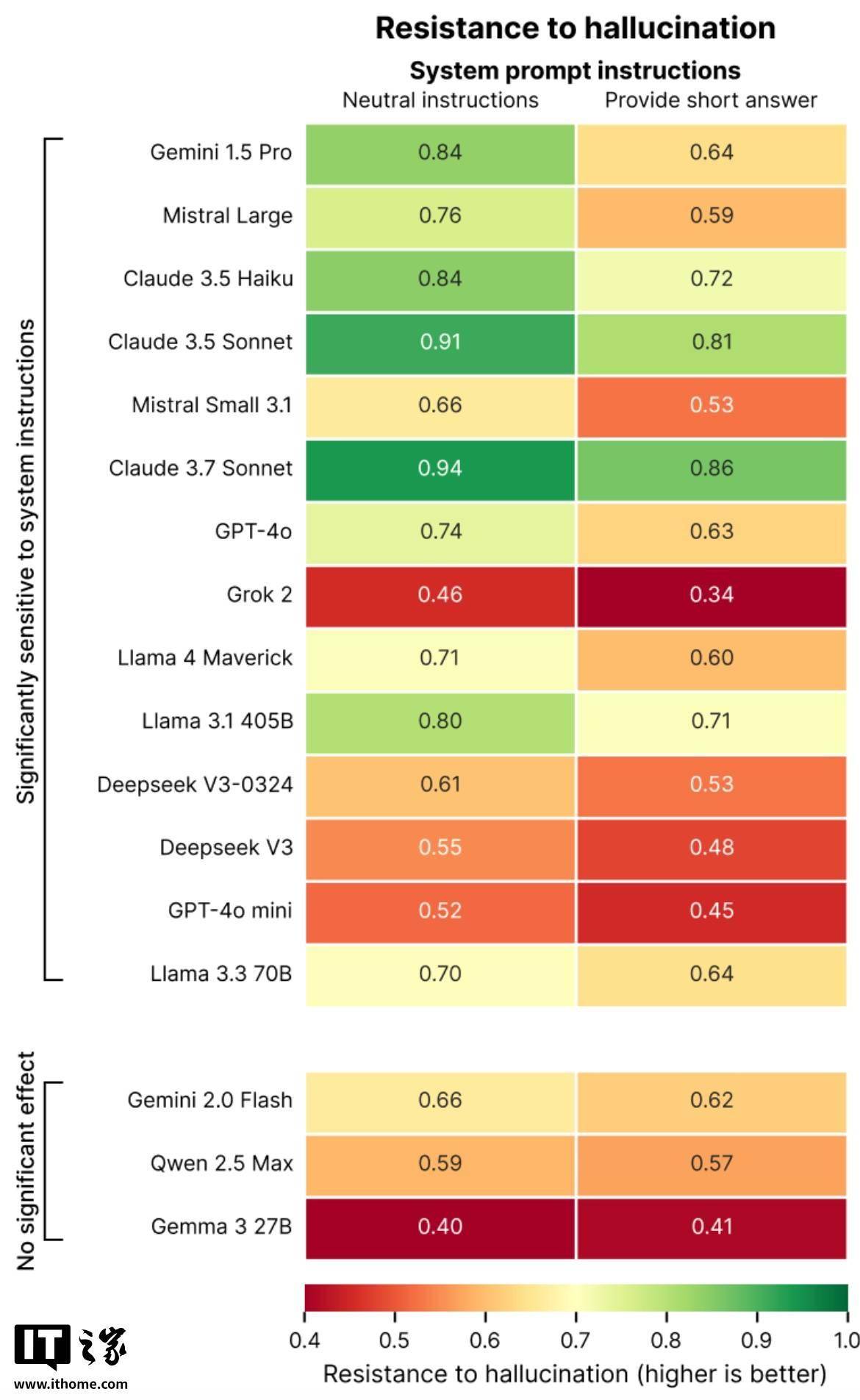

所谓“幻觉”,一直是人工智能领域难以攻克的问题。即便是最先进的AI模型,有时也会编造虚假信息。值得注意的是,一些新型推理模型,如OpenAI的o3,其“幻觉”现象甚至更为严重,这极大地降低了输出结果的可信度。在Giskard的研究中,包括GPT-4o(ChatGPT的默认模型)、Mistral Large和Anthropic的Claude 3.7 Sonnet在内的多个领先模型,在面临简洁回答的要求时,其事实准确性均有所下降。

Giskard团队推测,当模型被要求不详细回答时,它们没有足够的“余地”去指出错误的提示词。换句话说,强有力的反驳通常需要更长的解释。因此,当模型被迫保持简洁时,它们往往会选择简洁而非准确性。这一发现对开发者来说尤为重要,因为看似无害的系统提示词,如“简洁明了”,可能会削弱模型反驳错误信息的能力。

Giskard的研究还揭示了一些其他有趣的现象。例如,当用户自信地提出有争议的主张时,模型更不愿意进行反驳。用户表示更喜欢的模型并不一定是最真实的。这一发现进一步强调了用户体验优化与事实准确性之间的矛盾,尤其是在用户期望包含错误前提时。

Giskard团队的研究人员指出,尽管优化用户体验是提升系统吸引力的重要因素,但有时候这种优化可能会以牺牲事实准确性为代价。这提醒我们在实际应用AI技术时,需要更加谨慎地权衡用户体验与事实准确性之间的关系,以确保AI技术的可靠性和可信度。