近日,科技界迎来了一项重要进展,谷歌公司推出了名为LMeval的开源框架,旨在为大语言模型及多模态模型提供一个统一、标准化的评测体系。这一消息由知名科技媒体The Decoder在5月26日的报道中首次披露。

长久以来,新型AI模型的评测工作一直面临着诸多挑战。由于不同供应商在API设计、数据格式以及基准设置上的差异性,跨模型比较不仅耗时费力,还极为复杂。而LMeval框架的推出,无疑为解决这一问题提供了全新的思路。

LMeval框架通过一次性的基准设置,即可实现评测流程的标准化,极大地简化了评测工作的复杂度,为研究人员和开发者节省了大量时间和资源。这一创新性的设计,无疑为AI模型的评测工作带来了革命性的变化。

不仅如此,LMeval还通过LiteLLM框架实现了对Google、OpenAI、Anthropic、Ollama和Hugging Face等平台之间接口差异的兼容,确保了跨平台测试的无缝运行。这一功能不仅提升了测试的便捷性,还进一步推动了AI模型评测的标准化进程。

LMeval框架的评测范围广泛,不仅支持文本评测,还涵盖了图像和代码等领域的基准测试。其灵活的输入格式使得新测试项的扩展变得轻而易举,同时支持是非题、多选题和自由文本生成等多种评估类型。LMeval还能有效识别模型采用的“规避策略”,即故意给出模糊回答以避免生成有害内容的行为。

为了更全面地评估模型的安全性,谷歌还引入了Giskard安全评分,通过百分比的形式直观展示模型在规避有害内容方面的表现。同时,测试结果被存储在自加密的SQLite数据库中,既保证了数据的本地化存储,又避免了被搜索引擎索引的风险,从而实现了隐私与便捷的兼顾。

LMeval框架还具备增量评估功能,这意味着在新增模型或测试项时,无需重新运行整个测试流程,仅需执行新增部分即可。其多线程引擎能够并行处理多项计算任务,有效降低了计算成本和时间消耗。

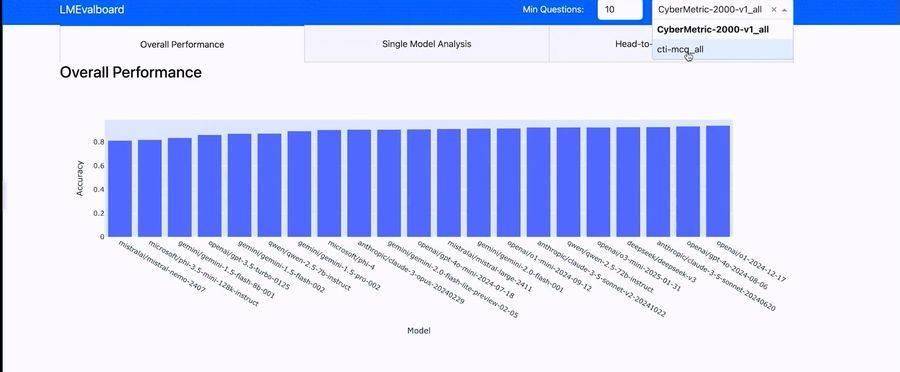

为了更直观地展示模型在不同类别中的表现,谷歌还开发了LMevalboard可视化工具。该工具通过雷达图的形式,清晰地展示了模型在各项任务中的得分情况。用户可以通过该工具深入查看具体任务,精准定位模型错误,并直接比较多个模型在特定问题上的差异。