百度在人工智能领域迈出了重要一步,正式推出了文心大模型4.5的开源版本,标志着国产通用大模型向更加开放和实用的方向迈进。这一里程碑式的进展,不仅展现了百度在AI技术上的持续创新,也为国内AI生态的发展注入了新的活力。

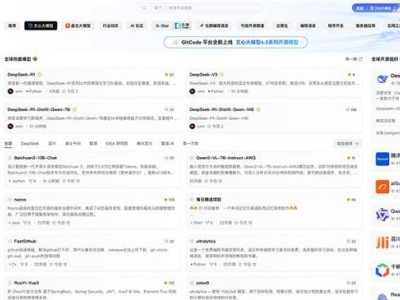

作为首批合作伙伴,模力方舟在文心大模型4.5开源首日便完成了全量接入与上线工作。用户现在可以在模力方舟平台上直接体验并下载完整的模型权重,进行自主部署和深度定制,极大地提升了大模型的可用性和实用性。

文心大模型4.5系列共包含了10款开源模型,其中涵盖了参数规模分别为47B和3B的混合专家(MoE)模型,以及参数规模为0.3B的稠密参数模型。最大的模型总参数量更是达到了惊人的424B。这些模型均采用了飞桨深度学习框架进行高效训练、推理和部署,模型FLOPs利用率高达47%。

针对MoE架构,百度提出了一种创新性的多模态异构模型结构。通过跨模态参数共享机制,实现了模态间知识的有效融合,同时为各单一模态保留了专用参数空间。这一架构不仅适用于从大语言模型向多模态模型的持续预训练范式,还在保持甚至提升文本任务性能的基础上,显著增强了多模态理解能力。

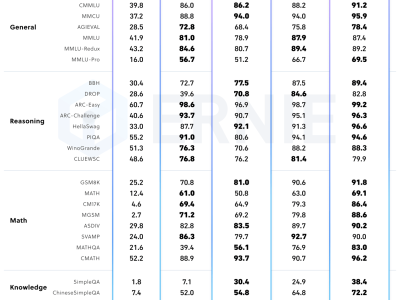

文心大模型4.5系列模型在多个文本和多模态基准测试中均达到了业界领先水平,特别是在指令遵循、世界知识记忆、视觉理解和多模态推理任务上表现尤为突出。这些模型权重按照Apache 2.0协议进行开源,支持学术研究和产业应用。同时,基于飞桨提供的开源产业级开发套件,这些模型还广泛兼容多种芯片,降低了后训练和部署的门槛。

在技术优势方面,文心大模型4.5采用了多模态混合专家模型预训练方法,通过在文本和视觉两种模态上进行联合训练,更好地捕捉了多模态信息中的细微差别,提升了在文本生成、图像理解以及多模态推理等任务中的表现。百度还提出了高效训练推理框架和针对模态的后训练方法,进一步提升了模型的性能和实用性。

作为领先的国产人工智能服务平台,模力方舟一直致力于提供开放、轻量、易用的大模型服务。此次文心大模型4.5的上线,进一步完善了模力方舟在国产主力模型方向的覆盖能力,为用户提供了更多具备工程可落地性的模型选项。用户无需本地部署,即可在模力方舟平台上即开即用模型,同时支持API调用与在线交互,便于接入现有业务。

模力方舟还依托国产GPU架构,为用户提供了强大的算力支撑,使得用户能够以极低的价格体验大模型推理。同时,模力方舟还全面适配了国产生态,兼容本地私有化部署、国密标准与信创环境,为用户提供了更加灵活和安全的模型使用体验。

百度与模力方舟的合作不仅是一次技术上的对接,更是国产模型生态共建的一次重要尝试。双方将携手推动国产大模型的发展和应用,为更多开发者和企业用户提供更加优质、高效的AI服务。