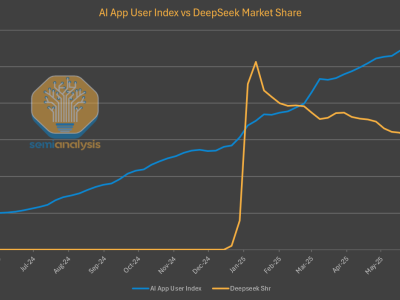

在AI领域,一场围绕性能与价格平衡的较量正在悄然上演。曾经以高性价比震撼市场的中国大模型DeepSeek,近期在用户留存和官网流量上遭遇了滑铁卢,市场份额持续下滑,引发业界广泛关注。

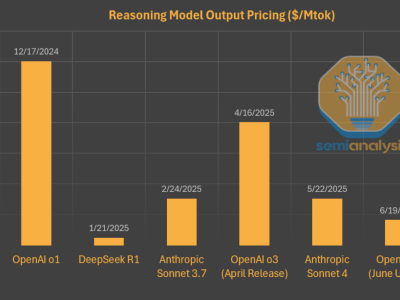

DeepSeek R1自发布以来,凭借与OpenAI相媲美的推理能力和低廉90%的价格,迅速在AI圈走红,甚至一度影响了西方资本市场。然而,随着时间的推移,这款模型在用户端的表现却出现了明显下滑。尽管在第三方平台上,DeepSeek R1和V3模型的使用量持续增长,但自家托管模型的用户增长却显得乏力。

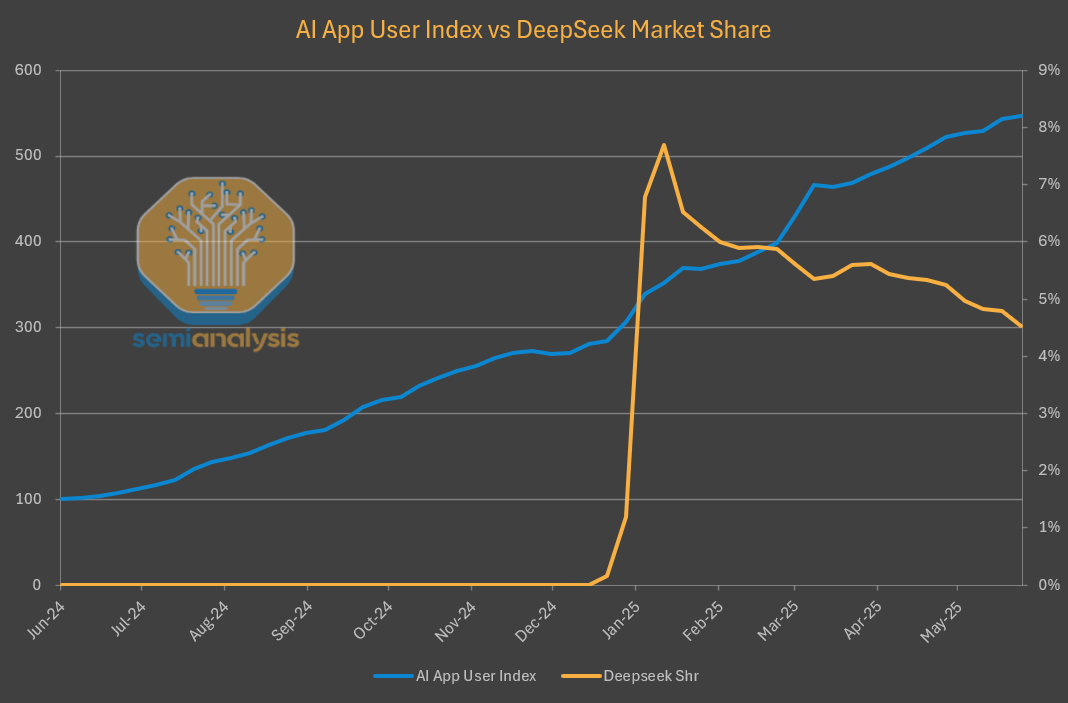

深入分析发现,这一变化背后隐藏着复杂的“Token经济学”考量。Token作为AI模型的基本单元,其价格并非孤立存在,而是模型提供商在平衡硬件、模型配置以及各项性能指标后的结果。这些性能指标包括延迟、吞吐量和上下文窗口大小,它们共同决定了模型服务的用户体验和成本效益。

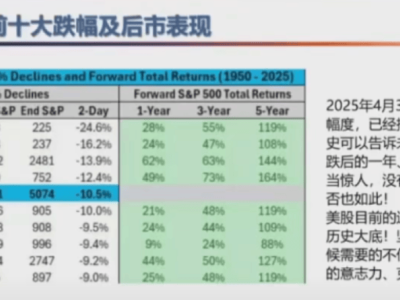

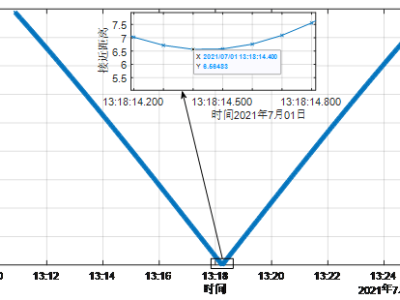

DeepSeek为了提供低价模型,在延迟和上下文窗口大小上做出了权衡。用户往往需要等待数秒才能收到模型返回的第一个Token,同时较小的上下文窗口限制了模型在编程等场景的应用。相比之下,其他服务商如Parasail、Friendli等,在提供近乎零延迟体验的同时,价格几乎没有差别。微软Azure虽然价格较高,但延迟却大幅减少。

DeepSeek采用的极高批处理方式,虽然最大限度地减少了用于模型推理和对外服务的计算资源消耗,从而将更多算力保留用于内部研发,但这一战略选择也导致了用户体验的下降。终端用户需要承受更高的延迟和更慢的吞吐量,从而影响了模型的普及和市场份额。

值得注意的是,尽管DeepSeek在自家平台上遇冷,但在全球市场上,其开源策略却赢得了广泛认可。通过让其他云服务商托管其模型,DeepSeek不仅节省了宝贵的计算资源,还赢得了全球用户的认知度和基础。这一策略与中国AI生态系统在模型服务方面的限制有关,但也反映了DeepSeek对实现通用人工智能(AGI)的坚定决心。

与此同时,另一家AI公司Anthropic也面临着类似的算力挑战。尽管其在编程领域取得了显著成功,如Cursor应用的广泛应用和Claude Code的推出,但算力上的局限仍然限制了其模型的生成速度和用户体验。为了应对这一挑战,Anthropic正在积极寻求更多算力资源,并与亚马逊达成了协议。

在这场AI领域的较量中,DeepSeek和Anthropic的故事为我们提供了宝贵的启示。在追求高性价比的同时,如何平衡用户体验和算力资源,将成为未来AI模型提供商需要深入思考的问题。而随着“GPT套壳”应用的迅速流行和主流市场的认可,AI模型的价值链和分发模式也将迎来更加深刻的变革。