在AI界掀起波澜的最新动态中,谷歌以双重策略震撼了大模型战场。一方面,T5Gemma的横空出世重新点燃了encoder-decoder架构的战火,性能实现了显著提升;另一方面,MedGemma则坚守decoder-only路线,强势进军医疗多模态领域,打破了闭源壁垒。

自2023年以来,decoder-only架构几乎垄断了大模型的江湖。从GPT系列到LLaMA、Gemma、Mistral,再到Claude、Command-R、Yi系列,主流的大语言模型(LLM)几乎清一色采用了这种“纯解码器”设计。然而,谷歌携T5Gemma的回归,打破了这一局面。

T5Gemma不仅重启了encoder-decoder的技术路线,而且通过简单的“适配”就实现了性能的飞跃,远远超过了原版Gemma 2。这一转变令人瞩目,T5Gemma 9B-9B在GSM8K(数学推理)上的得分比原始Gemma 2 9B高出9分,在DROP(阅读理解)上的得分也高出4分。更令人惊讶的是,当进一步缩小参数量时,T5Gemma 2B-2B IT的MMLU得分比Gemma 2 2B提高了近12分,GSM8K准确率暴涨到70.7%。

T5Gemma主要针对文本生成任务,包括问答系统、数学推理、阅读理解等。其encoder-decoder架构支持“不平衡”配置,例如9B编码器配2B解码器,能在质量和效率之间实现最佳平衡。在相同的计算量下,T5Gemma的性能优于仅解码器模型,且灵活度更高,可以根据具体任务调整编码器和解码器的大小。

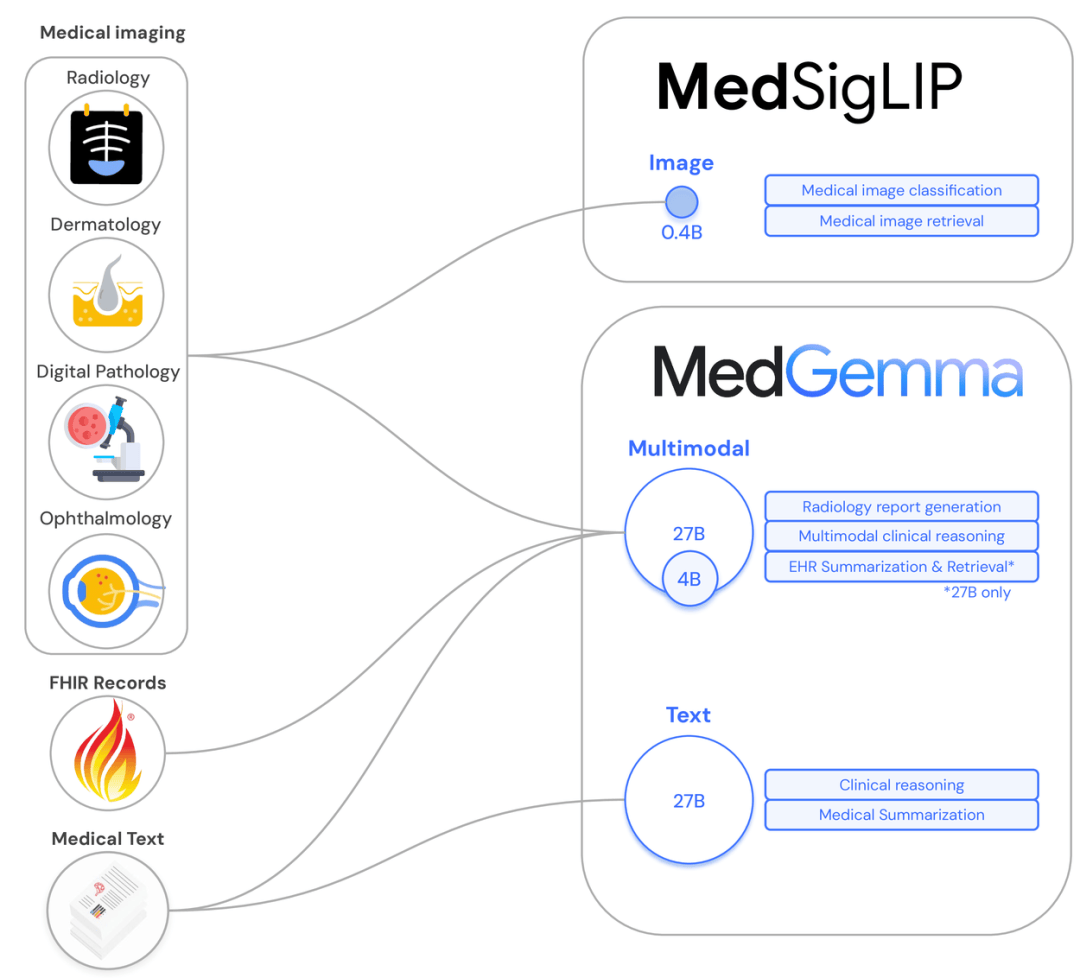

除了T5Gemma的技术回马枪,Gemma 3系列也迎来了重大更新。谷歌此次专注于医疗多模态任务,推出了MedGemma和MedSigLIP两款多模态模型。MedGemma支持图文输入,输出医学自由文本;而MedSigLIP则是轻量图文编码器。谷歌将“低资源友好”理念贯彻到底,MedGemma仅需4B模型即可逼近当前最优水平(SoTA),部署门槛极低,单卡甚至移动端也能轻松运行。

4亿参数的MedSigLIP同样表现出色,不仅在医学图像领域游刃有余,还擅长检索、零样本分类等非医学下游任务。在Med系列的“开源双子星”的推动下,医疗模型的闭源壁垒岌岌可危,同行们纷纷对谷歌表示祝贺和期待。

谷歌的T5Gemma和Med系列模型不仅在架构上实现了革新,更在产业落地方面迈出了坚实步伐。T5Gemma系列预训练模型和指令微调模型已在Hugging Face上开源,助力社区在研究与开发中挖掘新机遇。而MedGemma和MedSigLIP的发布,更是直接将医疗AI的开源门槛大幅降低,医疗机构可以轻松下载、部署,并在本地或自定义云平台完成推理与微调。

谷歌的这一波操作,不仅打破了闭源神话,更为整个AI社区树立了“工具+自由+性能”的典范。从T5Gemma到MedGemma,世界级开源模型已经到来,接下来,就看开发者们如何大显身手了。