近日,字节跳动旗下的Seed团队在机器人技术领域取得了重要突破,正式推出了全新版本的视觉语言行动(VLA)模型——GR-3,以及与之配套的通用双臂移动机器人ByteMini。

GR-3模型的最大亮点在于其卓越的泛化能力,能够迅速适应新物体和新环境。这一特性使得GR-3不仅能够理解包含抽象概念的语言指令,还能精细地操作柔性物体。更GR-3仅需少量的人类数据就能实现高效微调,从而快速迁移至新任务,极大地降低了成本和时间。与此前需要大量机器人轨迹训练的VLA模型相比,GR-3无疑是一个巨大的进步。

为了实现这一突破,Seed团队对GR-3的模型结构进行了全面改进。新的模型结构使得GR-3在处理长程任务和进行高灵巧度操作时表现出色,无论是双手协同操作、柔性物体操作,还是融合底盘移动的全身操作,都能游刃有余。

GR-3的出色表现离不开其独特的训练方法。除了通过遥操作机器人收集的高质量真机数据外,Seed团队还创新性地引入了基于VR设备的人类轨迹数据,以及公开可用的大规模视觉语言数据。这些多样性数据的融合,为GR-3的训练提供了丰富的素材,也是其区别于现有VLA模型的重要亮点之一。

作为GR-3的配套机器人,ByteMini同样不容小觑。这款通用双臂移动机器人具备高灵活性和高可靠性,专为GR-3这颗“大脑”量身打造。ByteMini全身拥有22个自由度,搭载了无偏置的7个自由度机械臂,手腕部分采用球形设计,能够在狭小空间中完成各种精细操作。

在感知层面,ByteMini搭载了多颗摄像头,实现了全方位无死角的监控。其中,2个手腕摄像头负责观察细节,头部摄像头则负责全局监控。在运动层面,ByteMini采用了先进的全身运动控制(WBC)系统,使得机器人在移动和操作过程中更加稳定和流畅。更重要的是,ByteMini作为机器人本体搭载了GR-3模型,能够在真实环境中高效处理复杂任务。

在实际应用中,GR-3展现出了“心灵”、“手巧”和“泛化好”三大特点。在超长序列的餐桌整理任务中,GR-3能够高鲁棒性、高成功率地完成任务,并严格遵循人类的分步指令。面对多件同类物品时,GR-3能够准确执行指令,如将多个杯子全部放入垃圾桶。若指令无效,GR-3则能保持不动,避免误操作。

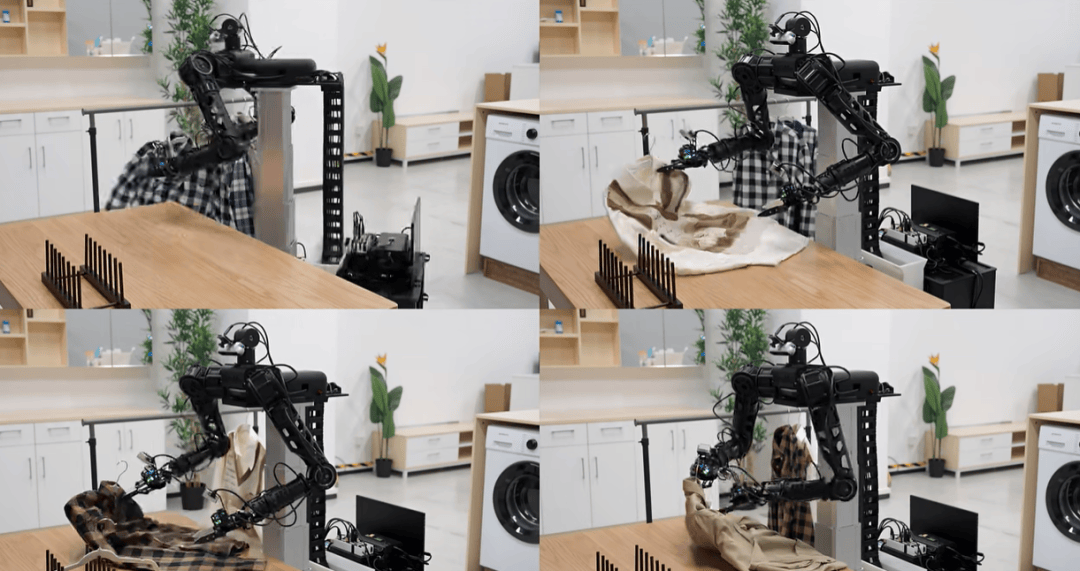

在复杂灵巧的挂衣服任务中,GR-3同样表现出色。它能够控制双臂协同操作可形变的柔性物体,还能鲁棒识别并整理不同摆放方式的衣服。即使衣服摆放混乱,GR-3也能稳定应对,顺利完成挂衣任务。

从技术层面来看,GR-3采用了先进的MoT网络结构,将“视觉-语言模块”和“动作生成模块”结合成了一个拥有40亿参数的端到端模型。在数据训练方面,GR-3突破了传统机器人只学习“机器人数据”的局限,采用了三合一数据训练法。通过同时从遥操作获取的机器人数据、人类VR轨迹数据以及公开可用的图文数据中学习知识,GR-3的训练效果得到了显著提升。

据Seed团队透露,他们后续计划进一步扩大模型规模和训练数据量,并引入强化学习方法(RL),以进一步提升GR-3的泛化能力和突破现有模仿学习的局限。这一举措无疑将为机器人技术的发展注入新的活力。