随着人工智能领域对算力需求的爆炸式增长,大智算集群已成为模型训练不可或缺的基础设施。这一趋势在摩尔线程技术分享日上得到了进一步证实,会上,摩尔线程副总裁王华围绕“基于FP8的国产万卡训练”这一主题,分享了在大规模集群上应用FP8精度进行训练的创新思路与实践经验。

从行业模型的发展历程来看,从2020年至2025年,诸如GPT、Llama、Grok等主流模型所需的算力资源呈现出惊人的增长态势。以Grok模型为例,从Grok-3到Grok-4,算力需求几乎增长了1000倍。这一增长的核心驱动力在于模型参数与数据的不断增加,两者共同推动着算力需求接近指数级增长。

在实际应用中,不同模型的算力需求及训练时间差异显著。以DeepSeek、Kimi K2和GPT-4为例,它们在千卡、五千卡和万卡集群上的训练时间截然不同。DeepSeek在万卡集群上仅需13天,而GPT-4在千卡集群上则需602天。这一对比凸显了数据和模型规模对训练算力的巨大影响。

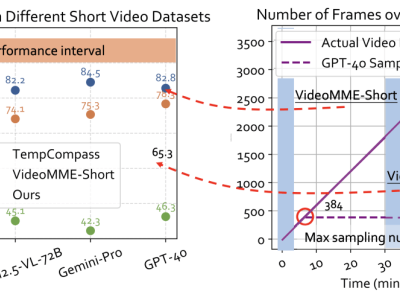

为了应对这一挑战,业界开始探索低精度训练,尤其是FP8精度的应用。FP8精度的优势在于能够显著提升算力,但同时也会带来模型效果的下降。因此,如何在精度与算力之间找到平衡点成为关键。王华指出,通过引入精度参数到Scaling Law中,可以合理配置参数量、数据量和精度,从而在保证模型效果的同时提升训练效率。实验结果显示,FP8精度位于一个最佳的“甜点区域”,能够为训练带来显著提升。

然而,低精度训练也面临着诸多挑战。由于FP8的取值范围有限,容易导致上溢和下溢问题。不同操作对精度的敏感度也不同,因此混合精度训练成为了一种有效的解决方案。在FP8时代,这一技术得到了进一步的发展和完善,包括硬件上的Tensor Core支持、权重Backup以及Tensor Scaling等技术。

摩尔线程在这一领域取得了显著的进展。他们提供了软硬件全栈的完整支持,包括支持从FP64到FP8全精度算力的GPU、针对Torch栈构建的MUSA底层插件、支持FP8混合并行训练的MT-MegatronLM框架以及用于Transformer高效训练和推理优化的MT-TransformerEngine。这些技术使得摩尔线程能够成功复现DeepSeek-V3的整个训练过程,并率先实现满血版训练的复现。

在FP8训练的探索和实验中,摩尔线程还关注了一些关键技术点。例如,在scaling factor的选择上,他们采用了不同颗粒度的选择策略,并根据观察结果进行了优化。他们还引入了Smooth SwiGLU技术来降低FP8阶段上溢的风险,从而提高训练的稳定性。

在大规模集群训练方面,摩尔线程也进行了深入的技术考虑。他们开发了Simumax软件来估算资源消耗和优化策略,并通过模拟整个计算过程来收集各种开销。他们还关注集群的可靠性问题,引入了起飞检查、飞行检查和落地检查等训练生命周期管理措施,以及容错训练技术来应对节点故障和慢节点问题。

王华在分享中强调,算力需求的发展趋势使得大智算集群成为训练的刚需,而低精度训练则能够带来大规模训练效率的提升。同时,集群的可靠性对于大规模训练至关重要。这些观点为业界提供了宝贵的参考和启示。