近期,网络安全领域迎来了一项令人担忧的新发现:Trail of Bits团队的研究人员创新性地开发了一种针对AI系统的攻击手段,该手段巧妙地将恶意指令藏匿于高清图片之中。这些指令在AI系统自动对图片进行降采样处理后悄然浮现,进而可能被大型语言模型所执行,导致用户数据面临被盗取的风险。

这项技术的提出者是Kikimora Morozova与Suha Sabi Hussain,他们的灵感源自于2020年由德国布伦瑞克工业大学提出的图像缩放攻击理论。攻击者通过在高清图片中嵌入肉眼难以察觉的指令,利用AI系统内部的降采样算法,使得这些指令在图片被处理后得以显现。这一过程如同一场无声的较量,攻击者与AI系统间的博弈充满了技术含量。

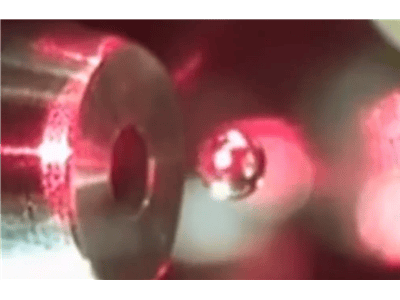

AI平台在处理用户上传的图片时,通常会采用降采样的方式,以减小图片尺寸并提高处理效率。这些平台使用的降采样算法包括但不限于最近邻插值、双线性插值和双三次插值等。攻击者可以针对这些特定的算法,精心设计出能够在降采样后形成可识别文字的图片。例如,在某些情况下,图片中的深色区域在双三次降采样后会转变为红色,并显现出黑色的文字指令。一旦这些文字指令显现,AI模型往往会将其视为用户的正常输入,从而触发一系列可能的数据泄露或其他风险操作。

为了验证这一攻击手段的有效性,研究人员在Gemini CLI环境中进行了实验。他们利用Zapier MCP的“trust=True”模式,成功地在未经用户确认的情况下,从Google日历中提取了数据,并将其发送至指定的邮箱地址。这一攻击手段在多个平台上均被证实有效,包括但不限于Google的Gemini CLI、Vertex AI Studio(Gemini的后端服务)、Gemini的网页版与API接口、安卓手机上的Google Assistant以及Genspark平台。

为了进一步提升对这一新型攻击手段的认识和防范能力,研究团队还发布了名为Anamorpher的开源工具(测试版)。该工具能够生成针对不同降采样方法的攻击图片,从而展示了这种攻击手段的广泛潜在威胁。Anamorpher的发布不仅为安全研究人员提供了重要的实验工具,也提醒了广大用户和企业,需要加强对AI系统安全性的关注和防护。

随着AI技术的不断发展和普及,其安全性问题也日益凸显。这次由Trail of Bits团队揭示的攻击手段无疑为整个行业敲响了警钟,提醒我们在享受AI带来的便利的同时,也必须时刻保持警惕,共同构建更加安全的网络环境。