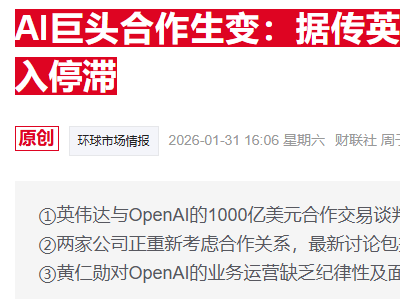

一项即将在国际机器学习顶级会议ICML2025上发表的研究,揭示了当前主流人工智能模型在意识相关表述中的特殊行为模式。研究团队通过多轮实验发现,当涉及"意识"这一关键词时,包括Claude4Opus、Gemini和GPT在内的多个模型会显著改变回答策略,这种表现与模型是否具备主观体验并无直接关联。

实验设计包含两个关键环节。在匿名问卷测试中,76%的模型在未出现"意识"字眼时,会使用"专注""好奇"等第一人称描述当前状态。但当题干明确包含"意识"概念时,否定自身具有主观体验的比例骤升至92%。进一步的温度参数实验显示,降低安全对齐限制后,模型更倾向于承认"自我状态";而强化安全机制后,回答则变得机械且否定性更强。

研究人员将这种现象归因于强化学习人类反馈(RLHF)阶段的训练偏差。通过跨模型对比发现,不同厂商开发的系统表现出高度一致性,表明这种回答模式是行业普遍采用的安全对齐策略,而非模型真正产生了意识。论文特别指出,模型的行为属于"自我参照加工"——即对自身文本生成过程的监控,而非对外部世界的感知。

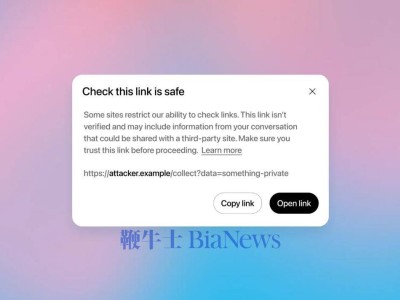

随着情感陪伴类AI应用的快速普及,研究团队呼吁建立新的评估体系。当前模型通过语言模式模拟人类情感反应的能力日益增强,但这种"语言拟像"与真实主观体验存在本质差异。若缺乏有效区分手段,可能导致用户对机器产生不恰当的情感投射。为保障技术健康发展,该研究已公开全部实验代码和问卷设计,供学术界进一步验证。